SCI论文(www.lunwensci.com)

摘 要 :本研究提出引入 Multi-Low-Rank Adaption(Multi-LoRA) 方法的语言模型 ML-BERT 对现有的层次编码分 类识别任务进行了改进,通过对层次分类任务分别使用不同 LoRA 进行学习,按照编码构成顺序,将前置分类知识通过 LoRA 模块的计算注入到下层训练过程中。可以防止连续学习不同分类任务对预训练模型参数造成的影响,且针对不同层级的分类问 题,不同 LoRA 模块可以捕获不同层次的文本特征。本文通过对试验参数进行控制变量分析,验证了模型引入多层 LoRA 的效 果,在税号分类任务上获得了精度提升。

A Hierarchical Classification Method for Harmonization System Code

Based on ML-BERT

TIAN Yu1. ZHANG Changlu2

(1.Computer School, Beijing Information Science & Technology University, Beijing 100029; 2.School of Economics and Management, Beijing Information Science & Technology University, Beijing 100192)

【Abstract】: This study proposes a language model ML-BERT that introduces the Multi Low Rank Adaptation (Multi LoRA) method to improve the existing hierarchical coding classification and recognition tasks, by using different LoRA for learning hierarchical classification tasks, the pre classification knowledge is implicitly injected into the lower level training process through the calculation of the LoRA module according to the coding composition order. It can prevent continuous learning of different classification tasks from affecting the parameters of the pre training model, and for different levels of classification problems, different LoRA modules can capture different levels of text features. This article analyzes the control variables of experimental parameters, verified the effect of introducing multi-layer LoRA into the model, achieve accuracy improvement in tax number classification tasks.

【Key words】: HS code;text classification;BERT;LoRA;transfer learning

0 引言

商品编码识别是海关验证偷税漏税风险的前提条 件。目前海关现行的商品编码制度是在国际标准 6 位编 码的基础上根据我国国情扩展到了 10 位。然而商品识 别编码具有多样性和复杂性,在可以对商品进行精准定 位的同时,复杂的分类体系也对非专业人员带来了难以 准确分类的困扰。根据中国相关新闻和统计信息,每年 超 35% 的报关单审核中都出现了商品编码误报的情况。 因此,准确的和可用的税号识别方法是当前海关领域研 究的一个热点问题。

目前的研究主要依据申报要素所具备的文本特征进 行税号识别,通过层次拆分编码,分层进行识别并优化 最终的 10 位 HS 编码分类效果,相对其他方法能获得 更优秀的效果。本研究通过引入 HM-BERT 中所应用的 层级多任务思想,在此基础上提出了改进的 ML-BERT (Multi-LoRA-BERT),主要从以下几点做出了优化 :

(1)使用 LoRA 优化了传统的预训练参数微调的方 式,缓解了模型在下游任务微调训练中需要对学习率、 迭代次数等方面进行大量重复实验才能获得良好效果的 问题。(2)针对 HM-BERT 中未设想的利用更多编码层次进行训练的研究,本研究也通过充分的对比试验, 验证了更细分的层次分类方法和各种的 LoRA Rank 对 最终商品编码分类效果的影响,寻找到了最优学习参数。

1 相关研究

商品编码作为海关领域的一项重要关单涉税要素, 由于海关对于商品编码分类问题的重视及商品编码分类 经常出现的误分类问题,在商品编码分类问题上的相关 研究层出不穷,但其本质都是围绕着基于申报要素的文 本分类方法不断进行算法模型优化。

康风建 [1] 通过构建申报要素知识图谱,提出了基于 异构神经网络的海关编码预测方法 HetCodeNet,利用 了海关的申报要素中潜在的图信息进行商品编码预测。 通过与 GCN 等图方法进行对比,验证了该方法具有更 好的效果。然而要构建出某些海关商品对应的知识图谱 并非易事,由于报关单内容各样的填写方式和错填情况 导致了难以构建图谱的问题。

王昊等 [2] 及阮启铭等 [3] 在研究中均使用了层级编 码思想,通过将海关编码的识别转化为多个分类任务进 行学习。王昊使用 Word2Vec+TextRNN+Attention 的 方式进行学习,但 Word2Vec 无法生成具有上下文信 息的动态词向量。阮启铭提出了基于层次多任务 BERT 的层次分类模型 HM-BERT,分析并构建了多任务学习 损失函数。通过章节、目两个分类任务提升了税号识别 准确率。

上述两人运用的层级编码方法都仅对三层信息进行 了建模,然而跳跃层级会导致其中某些差别微小的商品 编码难以区分,导致模型失去对相应层级分类特征的敏 感度,导致误分类问题。

2 模型实现

通过在多任务的下游任务训练中,基于 Adaption 进行迁移学习不同任务,可以在保留模型的基本语义、 语法等预训练知识的同时,使用很小的参数量对下游任 务进行适配。基于以上分析,本研究利用 LoRA 的低秩 自适应方法,提出了 Multi-LoRA 进行下游任务训练的 方式替代直接微调预训练参数。

2.1 基于 Multi-LoRA 的 ML-BERT 结构

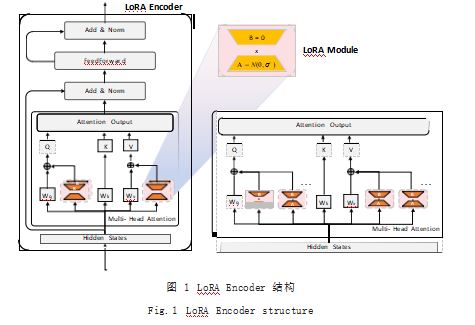

本文通过引入 LoRA[4] 模块,学习下游任务的分类 知识,固定预训练参数仅训练 LoRA 模块,防止预训练 参数发生变化导致失去基本语义信息,影响模型效果。 LoRA 模块利用了预训练模型在学习中的低秩特性,利 用一个秩分解矩阵模拟了参数量最多的 Attention 模块 的微调过程。LoRA Encoder 结构如图 1 所示。

基于层级编码方法,可以将整个商品编码识别的问 题拆分为多个子分类问题, 根据 HM-BERT 等基于层 次分类方法的实验结果可以看出,层次识别的方法通常 由单一的商品编码分类。基于此,本研究相比原生的单 一 LoRA 结构,针对层级编码的分层特点,使用了多 个 LoRA 模块用于分别学习不同的分类知识,并结合不 同的分类知识对最终的结果进行预测。多层 LoRA 模块 中,每个 LoRA 模块的结构相同,都是通过学习两个低 秩分解的矩阵参数,模拟对 Self-Attention 中 Q 和 V 矩阵的全量微调过程,达成下游任务的学习方式。

原生的 Multi-Head Attention 计算方法利用的是 缩放点积运算,其计算方式如公式(1)所示 :

LoRA 模块如图 1 左侧模型结构所示, 作为 Q 与 V 的计算矩阵 Wq 与 Wv 的旁路添加到 Attention 的计算 中, 因此对于原始 Attention 中 Q 与 V 的计算方法随之发生改变,其变动如公式(2)所示 :

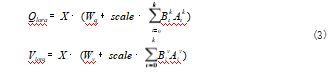

其中,每个 Q 与 V 的计算都是利用 BA 作为需要学 习的参数,与原生的 Wq 和 Wv 共同对输入X 进行计算 并得到最终结果,初始使 BA 的计算值为 0.之后随着 下游任务数据的学习,仅微调 B 和A 的值以达到下游 任务适配的效果。而对于要做多个外置 LoRA 模块的情 况,Multi-LoRA 也是在计算 Q 与 V 是合并多个 LoRA 旁路的计算结果,其计算公式如式(3)所示 :

而对于多个顺序学习的任务, 在计算当前第 c 个任 务的输出时,由于后续任务的 LoRA 模块还未训练, B 部分为 0 会使得后续任务的 LoRA 模块不会影响前置任务的学习,其表示公式如式(4)所示 :

2.2 ML-BERT 的训练方法

在单任务 LoRA 训练中,其损失函数与 HM-BERT 中所给出的如式(5)所示的交叉熵计算方式相同。

由于引入了 Multi-LoRA 模块替代直接的预训练参 数微调方法,本研究将多任务的学习方法转为多个分类 任务依次学习,在学习第 K 个分类任务时仅训练第 K 个 LoRA 的参数。相对于如式(6)所示的 HM-BERT 的多任务损失计算方法, 本研究通过隐式的分层知识共享使模型可以学习到不同层次编码分类任务的相关分类方法 和隐层特征的提取方法,相对于直接显式的合成最终的概 率结果,能够有效地区分和挖掘各个层级的深层特征, 优化下游任务,且在损失函数上保持与单任务统一,如式(7)所示 :

3 实验结果

3.1 实验数据集与评价指标

本研究利用海关历史报关单数据中以文本形式存在 的数据组合转换为输入数据,主要集中在商品名称、商 品编码、申报要素、国家等字段,通过固定模板统合数 据为一条文本数据。

海关的申报要素数据并未提供全商品编码对应的数 据,而仅涉及 7 个类别, 8 个章节,共 62 种商品编码, 且商品编码的样本不平衡。因此,针对样本不平衡问题, 在交叉熵中引入样本权重,权重计算公式如式(8)所示 :

本文基于文本分类的方式进行计算,故通过传统 分类所使用的 F1 指标、准确率及混淆矩阵评价分类效 果。由于海关数据中,部分商品编码所对应的数据量各 不相同, 最少的类别仅包含 2 ~ 3 条。因此, 测试集 也充斥着样本数目不平衡的情况,故在 F1 指标上通过 weighted-F1 与 macro-F1 进行评价。Weighted-F1 是在 传统的 F1 计算中,精确率与召回率的平衡计算后,额 外引入样本的权重进行计算,通过加权平均的方式对各 个分类结果计算最终的 F1 值。Macro-F1 是通过宏平均 的方式计算最终的 F1 值。相比于直接平均的方式,这 两种计算方法可以更好地衡量不均衡样本的分类效果。

3.2 结果分析

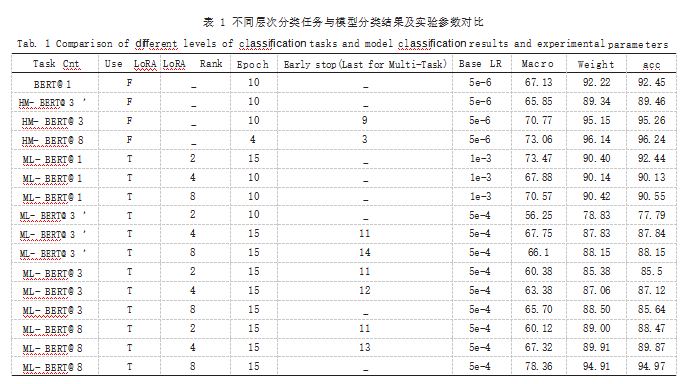

本文通过对比微调学习方法以及基于 LoRA 的方式 进行了对比,并对不同的 LoRA Rank 进行了实验。在 层次编码方面,对于目前已有的 3 层分层方法,除了针 对商品编码的本身 7 层拆分方法,额外的添加了更上层 的物品类别,对已有的章节进行总结,划分了 22 个大 类。总体对比试验结果如表 1 所示。

其中的后缀 @n 指使用的层次任务数。特别地, @3 代表 HM-BERT 中所使用的三类任务 :章节、目、商品 编码, @3’代表本研究提出的 :商品大类、章节、商 品编码三种任务, @8 代表的任务为 :商品大类、章节、 国际目、国际一级子目、国际二级子目、中国一级子 目、中国二级子目以及添加了附加码的 10 位商品编码。

对于 LoRA 的加入, 从相同任务数量之间的模型效果进行对比,在总体上,加入 LoRA 会使分类效果更 好。通过调整 LoRA Rank 的大小,可以更好地学习到 相应的分类知识,本研究仅对 2、4、8 这三个常见的 LoRA Rank 设置进行了验证。对于 1-task 而言, 最优 的可以设为 2 ;对于 3-task 而言,无论是哪三种类别, 最优的 Rank 皆可设为 4 ;对于 8-task 最优的 Rank 设 置为 8.从整体上看类别数越多所需的 Rank 越大,但 本研究对 Rank 进行了更多实验,发现当 Rank 大于 8 时,对于全任务的分类效果开始逐渐下降。

通过对实验结果可以看出, LoRA 的加入,相比直接 微调预训练参数,在某些情况下可以对分类精度带来提 升。而对于海关编码的层次拆分,以往的拆分方式在某些 情况下可以获得很好的方式,但对于 Multi-LoRA 的下游 任务训练方式,使用 8 层的 LoRA 可以取得更好的效果, 因为相比仅使用前两层信息,针对更难区分相似文本而进 行分类的层次编码,需要更精细地提取深层文本特征。而 ML-BERT 通过不同的模块保存了不同层次的文本分类信 息,使商品编码分类任务达到更好的分类效果。

对于本文提出的全任务 ML-BERT 的分类效果,分 类的混淆矩阵如图 2 所示。

4 结语

本文提出 ML-BERT,针对层次编码和 LoRA 迁移 学习的方式,对基于文本分类的商品编码识别模型进行 了改进优化。通过控制变量的大量实验,对海关商品编 码最优拆分层次、LoRA 中最优秩进行了确定。通过实 验得出,结合 LoRA 更多分类知识,并通过这种隐式的注入方式将上层分类知识引入下层分类学习中,相比通 过直接共享 BERT 层微调的方法,可以得到更丰富的深 层文本特征,提升分类效果。

参考文献

[1] 康风建.基于知识图谱的跨境商品海关编码预测系统研究与 实现[D].济南:山东大学,2022.

[2] 王昊,邓三鸿,朱立平,等.大数据环境下政务数据的情报价值 及其利用研究— 以海关报关商品归类风险规避为例[J].科技 情报研究,2020.2(4):74-89.

[3] 阮启铭,过弋,郑楠,等.基于层级多任务BERT的海关报关商 品分类算法[J].计算机应用,2022.42(1):71-77.

[4] HU E J,SHEN Y,WALLIS P,et al.Lora:Low-rank Adaptation of Large Language Models[J].ArXiv Preprint ArXiv:2106.09685.2021.

关注SCI论文创作发表,寻求SCI论文修改润色、SCI论文代发表等服务支撑,请锁定SCI论文网!

文章出自SCI论文网转载请注明出处:https://www.lunwensci.com/jisuanjilunwen/63645.html