SCI论文(www.lunwensci.com):

摘 要:针对目前城市生活垃圾依赖人工分类效率低下,造成环境污染以及资源浪费等问题,提出了一种融合通道空间注 意力机制的垃圾分类迁移学习方法。通过迁移学习,减少了垃圾分类模型的训练时间,通过改进 ResNext101 32x16d wsl 模 型,增加注意力机制,提高了模型对垃圾特征的提取能力,使用 Focal Loss 代替标准交叉熵损失函数,解决了数据集样本不平 衡的问题,提升了模型分类精度。通过实验证明,在华为垃圾公开数据集上,该模型对 40 小类的垃圾进行分类,其精度可以 达到 92.6%,表明模型有较强的泛化能力。

关键词:垃圾分类 ;迁移学习 ;注意力机制 ;损失函数 ;残差网络

Garbage Classification Transfer Learning Method Based on Attention Mechanism

KE Jian, WANG Min, ZHANG Liang

(School of Computer Engineering, Suzhou Vocational University, Suzhou Jiangsu 215104)

【Abstract】: Aiming at the problems of low efficiency, environmental pollution and waste of resources caused by the manual classification of municipal solid waste, a transfer learning method of garbage classification based on channel-spatial attention mechanism is proposed. Through transfer learning, the training time of garbage classification model is reduced, by improving the ResNext 101 32x16d wsl model and adding attention mechanism, the ability of garbage feature extraction is improved. Using Focal Loss instead of standard cross entropy loss function, the problem of sample imbalance in data set is solved, and the classification accuracy of the model is improved. Experiments show that the model classifies 40 categories of garbage on the Huawei garbage public data set, and its accuracy can reach 92.6%, which shows that the model has strong generalization ability.

【Key words】: garbage classification;transfer learning;attention mechanism;loss function;residual network

0 引言

近年来,随着各地城市建设的快速发展,城市环境 也遭到了不同程度地破坏,这与日益增加的城市生活垃 圾有很大的关系。合理地对生活垃圾进行分类处理,一 方面可以有效地进行垃圾处理、减少环境污染,另一方 面也可以使资源再利用。2019 年全国地级及以上城市全 面启动城市生活垃圾分类 , 垃圾分类制度在我国已处于 确立和实施阶段 [1],但是现在很多城市的社区大多是采

用人工判别的方法对生活垃圾进行分类,人工分拣垃圾 存在工作环境差,任务繁重并且分拣效率低下等问题。 为了解决这一问题,需要对生活垃圾进行智能化识别分类。

1 相关工作

目前智能化垃圾分类的研究方向主要集中在计算机视觉等方面,用于提高垃圾分类的识别精度。Abeywickrama 等人 [2] 将垃圾分类作为图像分类进行处理,使用支持向 量机和卷积神经网络对 6 类垃圾进行了识别分类,取得 了 83% 的识别精度。郑佑顺等人 [3] 设计的基于残差结 构和幻象模块的垃圾图片分类算法,对 Resnet18 做了 改进,增加了幻象模块,垃圾识别的精度达到了 89%。 武凌等人 [4] 的基于深度迁移学习的垃圾分类系统设计与 实现,使用 InceptionResNetV2 预训练模型进行微调训练,在验证集上的准确率达到 90%,但是实验所用 的数据集比较小,只有 6 类可回收垃圾,共 2527 张垃 圾图片。吕泽正等人 [5] 设计的基于 GINet 的垃圾分类 检测网络,在 VGG16 模型的基础上,添加了 TUM 多 特征融合和 SFAM 注意力机制模块,在 Kaggle 和华为垃圾分类公开数据集上,将垃圾分为干垃圾、湿垃圾、 可回收垃圾和有毒有害垃圾四大类,迭代 20000 次后, 训练精度达到了 94.5%,但是缺少验证精度等相关数据 而且训练时间较长。袁建野等人 [6] 的注意力机制下的轻 量级垃圾分类网络,精度达到 89.7%,但是实验数据集 只有 2340 张垃圾图像信息,且只针对 6 类可回收垃圾进行分类。

传统的基于卷积神经网络的深度学习需要大量的训练样本,对硬件设备尤其是显卡要求高,而且训练时间 长。本文在深入研究了多种深度学习模型的基础上,对 ResNeXt 模型进行了改进,设计了一个融合注意力机 制 [7] 的垃圾分类模型,使用在 ImageNet 数据集上预 训练的权重进行训练,使用迁移学习的方法一方面可以 减少模型的训练时间,另一方面在训练样本数量相对 较少的情况下,可以减少模型过拟合,提高模型泛化能 力,除了对深度学习模型的主干网络结构进行改进外, 还把 Focal Loss 损失函数 [8] 应用于垃圾分类任务中, 与标准交叉熵损失函数相对比,Focal Loss 损失函数能 够在样本不平衡的情况下提升模型的准确率。基于上述 方法实现了对日常生活中 40 种常见垃圾进行智能识别 分类,从而提高了垃圾分类的准确率,也提高了垃圾分 类的投放效率,减少了因错误投放而产生的环境污染。

2 本文方法

2.1 迁移学习

提高垃圾正确投放的前提条件是垃圾分类的精确 度,要使用深度学习方法来解决垃圾图像识别分类问 题,就需要采用大量的垃圾图像数据集作为样本训练深 度学习模型,当数据集较小时,一旦加深模型结构,就 很有可能出现模型过拟合的问题,这样训练得到的模型 泛化能力不足,识别精度不高。另外从零开始训练整个 深度学习模型也是非常困难的,需要花费大量的计算时 间以及计算资源,所以本文采用迁移学习 [9-10] 作为解决 训练样本较少的一种有效的方案。

本文在迁移学习的基础上调整模型的网络结构,对 预训练模型加以改进。使用在 ImageNet 数据集上训练 好的模型参数进行初始化,而不是对模型参数进行随机 初始化。把预训练的模型作为图像特征提取器,冻结除了全连接层以外的所有其他层的权重,保持网络中其他 层的参数不变,修改预训练网络的全连接层,替换为具 有随机权重的层,然后在新的垃圾数据集上重新对该层 进行训练。这样可以用较小的学习率训练整个网络。

2.2 垃圾分类主干网络

在垃圾识别分类过程中,由于垃圾种类众多而且垃圾的形态差别大,造成垃圾正确识别分类难度大,那么选 取一个合适的深度学习主干网络就变得非常重要了,合适 的主干网络在预训练模型基础上进行迁移学习可以有效 提高垃圾分类的识别率并减少模型的训练时间。自 Yann LeCun 提出卷积神经网络 [11] 后,各种基于卷积神经网络 的模型成为当前图像识别与图像分类领域的研究热点之 一,其典型代表有 :AlexNet[12]、GooleNet[13]、VGG[14]、 ResNet[15]、DenseNet[16]、ResNeXt[17]、ResNeXt wsl[18] 等。

自何凯明提出残差网络后,大幅提升了模型的分类精 度,表 1 为几类有代表性的深度学习模型在 ImageNet 数据集上训练得到的 top-1 error、top-5 error 以及模 型的参数大小。

在表 1 中,模型的 top-1 error 和 top-5 error 值越 小,说明模型在图像分类方面的准确率越高,params 为模型的参数量,值越大,说明模型占用的内存越多。

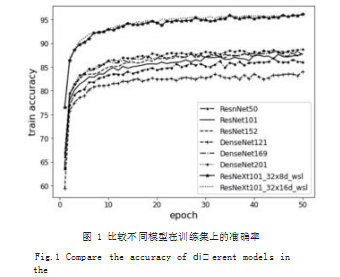

表 1 中的模型使用迁移学习在华为公开垃圾数据集 上的准确率如图 1、图 2 所示。

由图 1 和图 2 可以看出,不论是在训练集还是验证 集,ResNeXt 101 32x16d wsl 模型在垃圾分类的准确 率上优于其他几种模型,因此这里选择 ResNeXt 101 32x16d wsl 作为迁移学习的主干网络。

ResNeXt 模型是在 ResNet 模型的基础上进行了改进,ResNeXt 用一种平行堆叠相同拓扑结构的残差模 块代替 ResNet 的三层卷积模块,该残差模块聚集了具 有相同拓扑结构的一组转换,ResNeXt 在 ResNet 残差 模块的基础上,增加了多个称为基数的卷积分支,这是 除了增加模型深度和宽度之外,在不明显增加参数数量 的情况下,能够使得模型提取更加丰富的特征信息,提升了模型识别分类的准确率。本文采用的 ResNeXt 10132x16d wsl 是一个 101 层的 ResNeXt 模型 , 它的残差模块具有 32 个分组,瓶颈块的宽度为 16,在此基础上又增加了弱监督学习,用 Instagram 上面的 9.4 亿张没有经过特别标注,只带有用户自己添加的话题标签的图片,当作预训练的数据集,它的准确率可以比 200 层的 ResNet 获得更高的精度,但是计算复杂度比 200 层的 ResNet 低得多。

2.3 通道空间注意力机制

注意力机制最初用于自然语言处理领域 [19],现在注 意力机制也越来越多地应用于计算机视觉领域,计算机 视觉中的注意力机制主要是使模型把注意力放在感兴趣 的区域,关注图像中有助于判别的信息而忽略掉不相关的信息。本文采用了一种结合了空间和通道的软注意力 机制模块(CSAM),如图 3 所示。

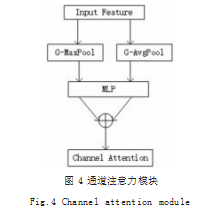

其中的通道注意力模块,如图 4 所示。

具体计算如公式 (1) 所示。

M

c(F)=σ(MLP(GAvgPool(F))+

MLP(GMaxPool(F) )) (1)

通道注意力模块将输入的特征图 F(H×W×C) 分 别经过基于宽度和高度的全局最大池化和全局平均池 化,得到两个 1×1×C 的特征图,再将它们分别送入 一个两层的 MLP 神经网络,其中第一层神经元个数为 C/r,其中 r 为减少率,激活函数为 Relu,第二层神经 元个数为 C,这个两层的神经网络是共享的。随后将 MLP 输出的特征进行基于逐元素的加和操作,再经过 Sigmoid 激活函数,生成最终的通道注意力特征,即 Mc。最后,将 Mc 和输入特征图 F 做逐元素乘法操作, 生成后面的空间注意力模块需要的输入特征。

空间注意力模块,如图 5 所示。

具体计算如公式 (2) 所示。

M

s(F)=σ(f

7×7([GAvgPool(F);GMaxPool(F)])) (2)

由于属于相同类别的垃圾的特征差异性可能较大, 不利于正确识别,这就要求关注图像中的显著区域。本 文在模型网络结构中添加了注意力机制模块,使模型重 点关注有利于分类的特征区域,以实现更好的特征提取 功能。CSAM 注意力机制模块,是一种结合了空间和通 道的注意力机制模块。添加 CSAM 模块后,卷积层输出的结果,会先通过一个通道注意力模块,得到加权结 果之后,再经过一个空间注意力模块,最终进行加权得 到结果。

2.4 垃圾分类网络结构

本文采用 ResNeXt101_32x16d_wsl 网络作为基本 的网络结构进行迁移学习,将 CSAM 注意力机制模块 添加在全连接层前面,CSAM 注意力机制可以提高网络 对感兴趣的区域特征的提取能力,可以增强图像特征表征能力,关注图像的重要特征而抑制不相关的特征。为 了降低过拟合 , 在网络全连接层的前面添加了 Dropout 层,改进后的用于垃圾分类任务的模型网络结构如图 6 所示。

2.5 改进的损失函数

深度学习经常面临的一个问题是样本不平衡问题, 如图 7 所示。

图 7 中 40 种垃圾类别的图像数据样本不均衡,其 中样本较少的类别有 :类别 3- 牙签、类别 20- 快递纸 袋 、类别 36- 饮料瓶 ;样本较多的类别有 :类别 11- 菜 叶菜根、类别 17- 塑料玩具、类别 21- 插头电线、类别 25- 毛绒玩具。由于垃圾数据集中样本类别的不平衡特 点,为了提高模型的分类效果,本文使用 Focal Loss 损失函数代替标准交叉熵损失函数,采用 Focal Loss 对垃圾数据集进行校正,对难分类样本加大权重,对易 分类样本减轻权重,使得模型多关注难分类的样本。如 公式 (3) 所示。

FL(

pt)=-α

t(1-p

t)

γlog(p

t) (3)

公式中 :α

t(1-p

t)

γ 为交叉熵损失函数对应的权 重 ;pt 为特征值属于第 t 类的预测概率 ;γ 为惩罚项 ; α ∈ [0,1],表示权重因子,用来平衡难分类和易分类样 本的重要性。实验中设置超参数 γ 为 2, α 为 0.5 效果 较好。实验结果表明,Focal Loss 通过改变损失函数的 非线性度,使模型在训练过程中针对难分类的样本进行 自动学习调整,解决了数据集样本分布不平衡的特点,有利于提升模型分类精度。

3 实验

3.1 数据分析

本文实验所用的数据集,采用了苏州、深圳等城市 发布的垃圾分类标准,该标准将人们日常生活中常见的 垃圾分为了四大类。其中,将废弃的电器电子产品、玻璃、织物、以及家具等适合回收同时可循环利用的废弃 物归为可回收物。将果皮果壳、剩菜剩饭、花卉绿植以 及其他餐厨垃圾等容易腐烂的废弃物归为厨余垃圾。将 废灯管、废电池、废药品等对自然环境有害和人们身体 健康而且应当处理的废弃物归为有害垃圾。除以上三类 之外的废弃物都归为其他垃圾。

实验采用的数据来源于华为垃圾公开数据集,数 据集中有 40 种物体,合计 14802 张图片数量。对垃圾 数据集按照 8:2 的比例进行划分,其中训练集样本有11841 张,验证集样本有 2961 张。40 类垃圾的训练集 和验证集如图 8 所示。

3.2 模型训练

实验将垃圾数据集随机打乱后按 8:2 划分为训练集 和验证集,一共训练了 50 个 epoch,批次样本数 batch size 是模型进行迭代训练时处理图片的数量,其值越大, 模型的收敛速度就越快,训练时间就越短,但是占用的 显存会越多,这里根据实际情况设置训练批次样本数 train_batch_size 为 32, 验证批次样本数 valid_batch_ size 为 16。学习率是神经网络中较为重要的超参数之 一,当学习率设置过大时会导致模型来回震荡难以收敛, 当设置过小时会导致模型收敛过慢,这里设置学习率为0.001。在文本实验中,Adam 比 SGD 能获得更高的精 度,因此模型的优化器选用 Adam。

3.3 实验结果分析

本文所有实验均在 Ubuntu18.04 使用 GPU 实现, 软件环境为 Cuda10.1、Python3.7.0、Pytorch1.6.0。

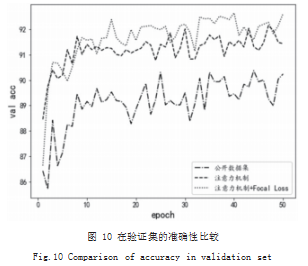

首先搭建 ResNeXt 模型,载入预训练的 ResNeXt101 32x16d wsl 模型权重文件,冻结特征提取层参数, 去除原始 ResNeXt 模型中的全连接层,添加注意力模块, 使得特征可以获得不同的权重,添加 Dropout 层和新 的全连接层。对 ResNeXt 模型改进后,加载垃圾数据 集,在搭建好的 Pytorch 环境中进行模型训练,将训练 过程中每轮迭代的 Train Acc、Valid Acc 等数据保存 到日志文件中,然后使用 Matplotlib 库绘制在训练集 和测试集上的 Accuracy 变化曲线如图 9、图 10 所示。

本文实验以华为垃圾公开数据集作为基准,比较其对 40 类垃圾正确识别的准确率,添加注意力机制的网 络在经过 50 个 epoch 迭代后,比原始网络在训练数据 集的准确率提高 0.54%,添加注意力机制的网络,采用 Focal Loss 作为损失函数在经过 50 个 epoch 迭代后, 比原始网络在训练数据集的准确率提高 0.72%。添加注 意力机制的网络在经过 50 个 epoch 迭代后,比原始网络在验证数据集的准确率提高 2.08%,添加注意力机 制的网络,采用 Focal Loss 作为损失函数在经过 50 个 epoch 迭代后,比原始网络在验证数据集的准确率提高 2.54%。实验表明,本文的方法在不增加模型复杂性的 基础上,不仅提高了模型对垃圾分类的识别能力,而且 也提高了模型的泛化能力。

4 结语

本文针对我国城市建设过程中生活垃圾分类现状,提出了基于迁移学习 , 融合通道空间注意力机制,改进 ResNeXt 网络结构的垃圾分类算法,提高了垃圾分类的 识别精度,有效改善了垃圾分类识别的智能化和自动化 水平。本次实验训练了一个用于垃圾图像识别分类的模 型,采用迁移学习的方法选取性能较好的模型进行调优 改进,经过 50 个 epoch 迭代,缩短了从零开始训练模 型的时间,最终的模型识别准确率在 92.6% 以上,模 型在垃圾识别分类方面有较好的泛化能力。

参考文献

[1] 孙晓杰,王春莲,李倩,等.中国生活垃圾分类政策制度的发展 演变历程[J].环境工程,2020,38(8):65-70.

[2] Abeywickrama T,Cheema M A,Taniar D.K.Nearest neighbours on road network:Ajourney in experimentation and inmemory implementation[J].Proceedings of the VLDB Endowment,2016,9(6):492-503.

[3] 郑佑顺,林珊玲,林志贤,等.基于残差结构和幻象模块的垃圾 图片分类算法[J].信息技术与网络安全,2021,40(1):50-55.

[4] 武凌,王浩,张晓春,等.基于深度迁移学习的垃圾分类系统设 计与实现[J].沈阳大学学报(自然科学版),2020,32(6):496-502. [5] 吕泽正,祁翔.基于GINet的垃圾分类检测网络[J].智能计算 机与应用,2021,11(1):152-160.

[6] 袁建野,南新元,李成荣,等.注意力机制下的轻量级垃圾分类 网络.计算机工程. https://doi.org/10.19678/j.issn.1000-3428. 0058108.

[7] Woo Sanghyun,Park Jongchan,Lee Joon-Young,et al. CBAM:Convolutional Block Attention Module[J].arXiv Preprint arXiv:1807.06521v2,2018.

[8] Tsung-Yi L,Goyal P,Girshick R,et al.Focal Loss for

Dense Object Detection[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017(99):2999-3007.

[9] Ganin Y,Lempitsky V.Unsupervised Domain Adaptation by Backpropagation[C]//Proceedings of the 32nd International Conference on MachineLearning, Lille,France,2015.JMLR:W&CP volume 37.

[10] Mingsheng L,Yue C,Jianmin W,et al.Learning Transferable Features with Deep Adaptation Networks[C]// Proceedings of the 32nd International Conference on Mac hineLearning,Lille,France,2015.JMLR: W&CP volume 37.

[11] Lecun Y,Bottou L,Bengio Y,et al.Gradient-Based learning applied to document recognition[J].Proceedings of the IEEE,86(11):2278-2324+1998.

[12] Krizhevsky A,Sutskever I,Hinton G.Imagenet classification with deep convolutional neural networks[J]. In Advances in Neural Information Processing Systems: 1097-1105+2012.

[13] Szegedy C,Wei L,Yangqing J,et al. Going deeper with convolutions[J].arXiv Preprint arXiv: 1409.4842v1,2014. [14] Simonyan K,Zisserman A.Very deep convolutional networks for large-scale image recognition[J].arXiv Preprint arXiv:1409.1556v6,2015.

[15] Kaiming H,Xiangyu Z,Shaoqing R,et al.Deep Residual Learning for Image Recognition[C]//Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Las Vegas:IEEE, 2016:770-778.

[16] Gao Huang,Zhuang Liu,Laurens van der Maaten,et al. Densely Connected Convolutional Networks[C]//IEEE Conference on Computer Vision and Pattern Recognition. Hawaii:IEEE,2017:2261-2269.

[17] Saining X,Girshick R,Doll´ar P,et al. Aggregated Residual Transformations for Deep Neural Networks[C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Honolulu:IEEE, 2017:1492-1500.

[18] Mahajan D,Girshick R,Ramanathan V,et al.Exploring the Limits ofWeakly Supervised Pretraining[J].arXiv Preprint arXiv:1805.00932v1,2018.

[19] 陈榕,任崇广,王智远,等.基于注意力机制的CRNN文本分类算法[J].计算机工程与设计,2019,40(11):3151-3157.

关注SCI论文创作发表,寻求SCI论文修改润色、SCI论文代发表等服务支撑,请锁定SCI论文网!

文章出自SCI论文网转载请注明出处:https://www.lunwensci.com/jisuanjilunwen/35880.html