SCI论文(www.lunwensci.com)

摘要:移动机器人定位是移动机器人实现智能化与自主化的关键技术。当移动机器人在室内工作时,由于白墙、天花板等人造场景特征稀少,且存在大量重复纹理,现有的基于传统相机的特征定位方法在效率和精度上存在较大的局限性。为此提出一种基于事件线特征的室内移动机器人定位算法。使用事件相机观测周围环境,并利用基于事件的直线特征检测与跟踪算法,对事件相机输出数据进行具象化表达,在此基础上基于迭代单应矩阵进行相机位姿估计,实现移动机器人定位。实验结果表明,所提算法在不同移动速度、光照强度、环境复杂程度下均可实现移动机器人的精确定位,具有良好的准确度和鲁棒性。当环境光照增强时,基于传统单目相机的特征定位相对误差会增大1倍以上,而事件相机基本不受影响;当机器人运动速度由低速转为高速时,基于传统单目相机的特征定位相对误差会增大到8%以上,而基于本文算法的特征定位误差仍在2%以内。

关键词:移动机器人;定位算法;直线检测与跟踪;视觉里程计;事件相机

Abstract:Localization technology is the key technology for intelligence and autonomy.When mobile robot works indoors,due to the scarcity of artificial scene features such as white walls and ceilings,and the existence of repetitive textures,existing traditional camera positioning method based on feature points has great limitations in efficiency and accuracy.In order to solve this problem,an indoor mobile robot positioning algorithm is proposed based on event line features,which uses event camera to observe surrounding environment,and uses event-based linear feature detection and tracking algorithm to visualize the output data,and on this basis,camera posture estimation is carried out based on iterative single response matrix to achieve the positioning of mobile robot.Experimental results show that the performance detection accuracy of visual odometer designed is higher than that of the traditional method,which is insensitive to light and has good robustness.In bright light,the relative error of feature positioning based on traditional monocular camera increases by more than 1 times,while event camera is basically unaffected.When robots’movement speed is changed from low speed to high speed,the relative error of feature positioning based on traditional monocular cameras increases to more than 8%,while the feature positioning error based on the algorithm is still within 2%.

Key words:mobile robot;localization algorithm;line detection and tracking;visual odometry;event camera

0引言

随着科技的进步,机器人逐渐走进千家万户,成为人类日常生活的得力助手。室内移动机器人是在室内进行自动化作业的机器装置,其任务是帮助或代替人类完成重复性或复杂性工作,被广泛应用于医疗健康服务、家居生活、商场导购、清洁卫生等领域[1]。各项移动机器人相关技术中,移动机器人定位技术是实现移动机器人实现智能化与自主化的关键。

移动机器人的定位是指利用自身传感器对周围的环境进行勘测、计算,从而确定移动机器人当前位置的过程。由于室内GPS信号强度会受到障碍物的干扰,室内定位无法采用室外定位常用的已经相当成熟的GPS定位方法[2-3],并且受精度、成本、结构等因素的影响,目前还没有一套通用的定位方法。常用的室内定位技术包括基于信标的定位技术[4]、惯性导航定位技术[5]以及基于地图匹配的定位技术等[6]。

其中,基于机器视觉的定位技术通过采集环境中的特征,将不同帧中的特征进行匹配,从而实现机器人位姿估计与定位,具有精度高、成本低、操作简便等优势[7-8],在学术领域和工业领域都得到了长足的发展,在自动驾驶、虚拟现实与增强现实、辅助生产与产品检验等领域[9]获得了广泛应用。但是,目前视觉定位系统只能解决机器人移动速度较慢、环境光照强度基本不变的场景,很难应对光照变化导致过曝、欠曝或高速运动导致运动模糊等[10]挑战性环境。为解决上述问题,研究人员提出了多传感器融合[11]、结合深度学习[12-13]等解决方案,但在挑战性环境下仍然无法得到令人满意的结果。

因此,本文提出利用事件相机(Event Camera)所具有的高分辨率、高动态范围、低时间延迟、无运动模糊等独特优势,使用事件相机代替传统的视觉传感器,通过基事件流的直线检测与跟踪算法于提取环境中的线特征,在此基础上基于迭代单应矩阵进行相机位姿估计,实现室内移动机器人的定位。

1工作原理

1.1工作特性

事件相机是一种受生物启发的新型传感器[14-15]。与以恒定频率拍摄图像的传统相机不同,事件相机的每个像素单独地检测照射到该像素上的光强对数(Log Inten⁃sity)的变化,并根据光强对数的变化异步地输出变亮(ON)或者变暗(OFF)事件。

在其独特的工作模式下,事件相机能克服传统帧相机的局限性并且拥有独特的优异属性。

(1)高时间分辨率,事件相机输出频率可达1 MHz,即事件时间戳分辨率为微秒级。因此,事件相机可以捕捉到高速运动,不会受到运动模糊的影响。

(2)低延迟,事件相机可近乎实时地输出亮度变化,而传统相机则会受到帧率的限制[16]。

(3)高动态范围,事件相机不受白平衡、感光度等统一成像参数影响,在图像过暗、曝光过度、光线突变等情况下,依然可以通过触发事件来获取视觉信息[17]。

因此,事件相机很适合作为视觉传感器,搭载在无人机、移动机器人、汽车等移动平台上,在自动驾驶、目标跟踪、视觉导航等技术领域得到了广泛的应用。

1.2基于事件相机的直线检测

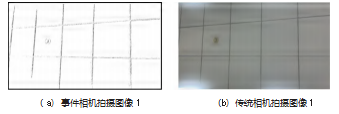

事件相机可以高效提取环境内的边缘特征,以事件相机代替传统基于帧的视觉传感器的,基于线特征的定位算法,能够克服传统相机的多种工作原理导致的性能限制,解决特征点法算法在欠纹理、重复环境下失效的难题,如图1所示。其中图1(a)、(c)为事件相机拍摄的图像,图1(b)、(d)为传统相机拍摄的图像,可以看出,事件相机可以更好地提取环境中的线结构特征,屏蔽非结构化特征。

2基于事件线特征的室内移动机器人定位算法

2.1基于事件相机的直线检测

与传统相机的工作模式不同,事件相机当且仅当某个像素点的亮度变化累计达到一定阈值时,会输出1个数据,即1个“事件”。在t时刻,像素坐标系内,图像上位于%处的像素点的亮度变化ΔI的绝对值达到阈值C时,相机会记录下事件e≜(%,t,p),其中%=(x0,x 1)T为事件的像素坐标,此时:

pC=ΔI(%,t)=I(%,t)-I(%,t-Δt)(1)

式中p∈{+1,-1},为事件的极性。

将时间t0内事件相机拍摄的事件数据流记为ξ={ek(%k,pk,tk)}=1,将事件流按其像素位置绘制到同一张图上,如图2(a)所示,具体地,对于图像上的每个像素点%,该位置上存在事件流时,像素点的灰度值为1,否则灰度值为0。这一初始事件流图像记为S0。为了消除图像中孤立的噪声点,采用中值滤波的方法,将S0中每个像素点附近相邻像素点的像素值进行排序,取其中位值作为新图像中,同一位置像素点的像素值,将新的图像记为S 1,如图2(b)所示。为了凸显图像中的边沿特征,对S 1进行一次图像膨胀运算与一次图像腐蚀运算[18],得到图像S2。

对图像S2进行Hough变换[19],提取图像中的直线{l1,l2,…,lm},其中,第i条直线li在相机坐标系内的直线方程可表示为:

y=ki x+bi(2)

式中ki、bi分别为直线的斜率与截距。

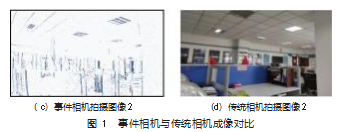

初步直线提取后,会出现同一个线性特征被检测为多条直线的情况,如图3所示。因此,本文设置一个相邻阈值δL,若两条直线li、lj满足式(3),则将这两条直线视为同一条直线,新直线的斜率和截距为原先所有相邻直线斜率、截距的平均值,其中α、β为常数。经过聚类后,图像中直线的集合记为{l1,l2,…,ln}。

α(ki-kj)2+β(bi-bj)2<δL

2.2基于事件相机的特征跟踪

对于时间t0内,事件相机拍摄的事件数据流ξ={ek(%k,pk,tk)}=1中的每个事件ek,若直线{l1,l2,…,ln}中存在直线li满足式(4),则认为ek是li附近的有效点,其中δd表示相机坐标系下,事件所在的像素点和直线之间的距离。本文设定初始化阈值为δN,即当一条直线附近到达δN个有效点时,对直线{l1,l2,…,ln}进行检测,将附近存在γδN个组成点的直线标记为有效直线并结束初始化,γ为常数。

d(ek,li)<δd(4)

完成初始化后,对后续的事件流数据中的每一个事件,根据式(4),判断该事件是否为某一条有效直线附近的有效点,若是,则将该事件加入这条有效直线的有效点集合,并删除集合中触发时间最早的事件,以保持集合中有效点数目不变。

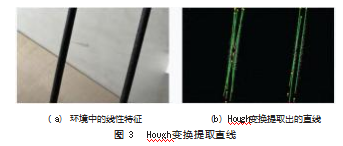

每隔时间t0,采用与第2.1节中相同的方式,绘制t0时间段所有事件流的位置图像,内通过最小二乘拟合更新有效直线的斜率和截距,具体地,对有效直线li以及对应的有效点集合ξli={ek(%k,pk,tk)}其中Nli=γ(δN)表示集合中元素个数,%k=(x,y),直线斜率kli和截距bli可通过以下公式计算。

移动机器人运动过程中,超过边界的直线会离开相机视野,本算法设定当一条有效直线的斜率和截距在一定时间内保持不变时,判定为跟踪丢失,清除该直线。

运动过程中,新的直线会加入图像,本文采用局部初始化方法对新进直线进行处理。具体地,在更新有效点时,将不在任意一条有效直线附近的事件保存下来,当其数量达到一定值后,对其单独进行绘图并进行Hough变换,方法与第2.1节方法相同,若存在有效直线,则提取其斜率、截距参数与有效点,将直线添加到有效直线集合中以进行后续直线跟踪。

2.3基于事件线特征的视觉里程计设计

对于像素坐标系内一点%,将世界坐标系下与%对应的点记为X,X=(X0,Y0)T表示该点在世界坐标系下的坐标,两者之间的坐标变换关系可表示为:

式中:fx、fy、cx、cy为相机内参;R、T分别为相机坐标系与世界坐标系之间的转置矩阵、平移矩阵。

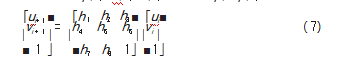

对于2.2节中,每隔t0绘制出的n张图像{I1,I1,…,In},将其中第i张图记为Ii,世界坐标系下的一个特征点p在第i张图像上的坐标为pi(ui,vi),在下一张图像上的坐标为pi+1(ui+1,vi+1),此时pi与pi+1满足:

将式(7)中3×3的位置变换矩阵记为Hi,可见这一矩阵有8个自由度,在相邻两张图上选择4组对应的特征点即可求解得到转置矩阵(通常选取两条相同直线在两张图像上的交点)。

通过位置变换矩阵的迭代相乘,可以得到任意两张图像Ii、Ij之间的坐标变换关系。

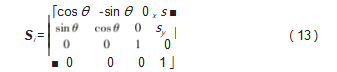

由于搭载相机的室内移动机器人在一个平面上运动,Si应满足以下形式:

式中:θ为移动机器人的旋转角度;(sx,sy)为移动机器人在平面上的位移。

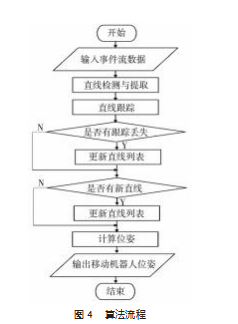

本文提出的基于事件相机的视觉定位方法流程如图4所示。

3实验与分析

3.1仿真实验

如图5所示,本文采用实验室搭建的移动机器人作为实验平台,平台上搭载的视觉传感器为CeleX5事件相机。

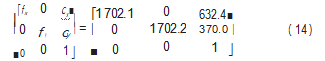

首先,通过张正友相机标定法[19],使用棋盘格获取式(6)中事件相机的内部参数,具体结果如下。

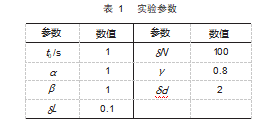

为了模拟室内移动机器人的工作环境,通过蓝牙遥控,控制移动平台在办公室、走廊等场所进行运动拍摄,视觉传感器通过蓝牙连接计算机,从而对传感器的数据进行获取,并按照第2节所述的流程对事件流进行直线检测、特征跟踪和位姿计算,实验过程中所用的参数如表1所示。

3.2评价指标与实验结果

根据式(13),从初始位置到最终位置,移动机器人记移动机器人的起止位置,可获取位移的真实值Δs,本文通过比较测量值和真实值之间的平均相对误差以及最大相对误差,对算法的准确率进行定量评估。

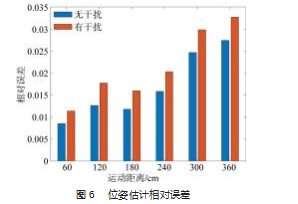

将环境中线性特征相对较为明显的场景记为无干扰场景,线性特征不明显的场景记为有干扰场景,分别进行不同运动距离下的移动机器人定位测试,所得结果如图6所示,可见,不同场景下,本算法均可实现移动机器人的精确定位。

3.3对比实验

为了定量验证基于事件相机的定位算法与基于传统单目相机的定位算法在性能上的差异,本文使用事件相机与传统单目相机共同搭载在可移动平台上,通过相同的运动过程与实验流程,对事件相机记录下的事件流图像与传统单目相机拍摄到的图像进行直线检测、特征跟踪与位姿计算。

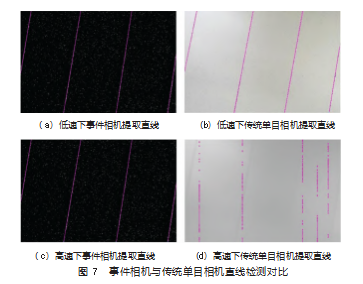

机器人不同运动速度下,事件相机与传统相机的直线检测结果如图7所示。可以清晰地看出,低速时两者误差相差很小,而当移动平台运动速度较快时,传统相机会出现运动模糊的现象,导致直线检测结果极不准确,而对事件相机则无影响。

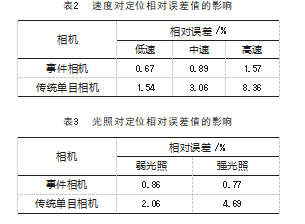

不同运动速度下,事件相机与传统单目相机的位姿估计结果与真实值的相对误差如表2所示,强光与弱光环境下,两者的位姿估计结果与真实值的相对误差如表3所示。综合以上结果,在低速、低光照条件下,事件相机与传统单目相机定位精度差别不大,但在中、高速情况下,传统相机由于运动模糊现象,导致检测结果极不准确,甚至会出现算法失效,无法检测的情况,较高光照下,传统相机则会出现过曝光,导致误差偏大。

因此,本文认为,与基于传统单目相机的视觉定位方法相比,相同条件下,使用事件相机代替传统单目相机,可以使得视觉定位算法具有更高的精度,以及良好的鲁棒性。

4结束语

本文提出了一种基于事件线特征的室内移动机器人定位算法,通过基于事件相机的直线检测、特征跟踪与位姿计算,完成了基于上述算法的视觉里程计设计,通过这一系统,可以在移动机器人工作过程中,实时获取机器人的位置信息,从而完成对移动机器人的定位与监控。实验结果表明,相同条件下,使用事件相机代替传统单目相机,本文算法和准确率和鲁棒性上均有较大的提升,在强光、高速运动等极端条件下,基于本文算法的机器人视觉里程计仍可保持较高的定位精度。本文在提出一种全新的,基于事件相机的移动机器人视觉里程计设计方案的同时,也为后续基于事件相机的移动机器人定位与建图工作提供了一种有效思路。

参考文献:

[1]潘圆媛.物联网环境下的移动机器人定位的应用[J].科技资讯,2022,20(16):33-35.

[2]高扬,夏洪,许豪,等.基于GPS与地图匹配的移动机器人定位方法[J].机床与液压,2021,49(3):1-5.

[3]杨海,朱虹,刘业峰,等.移动机器人过程神经网络RTK-GPS定位研究[J].机械设计与制造,2022,(6):282-285.

[4]Mainetti L,Patrono L,Sergi I.A Survey on Indoor Positioning Systems[C]//22nd International Conference on Software,2014:111-120.

[5]叶强强,郑明魁,邱鑫.基于ROS的室内自主导航移动机器人系统实现[J].传感器与微系统,2022,41(2):90-93.

[6]王巍.惯性技术研究现状及发展趋势[J].自动化学报,2013,39(6):723-729.

[7]张广帅,韦建军,刘检权,等.移动机器人导航的路径规划策略[J].机电工程技术,2021,50(4):14-24.

[8]周云飞,王晨霖.基于红外可见光融合图像的车辆定位方法[J].科技与创新,2020,(9):102-103.

[9]Mao G,Fidan B,Anderson B.Wireless sensor network localization techniques[J].Computer Networks,2007,51(10):2529-2553.

[10]Cadena C,Carlone L,Carrillo H,et al.Past,present,and future of simultaneous localization and mapping:toward the robust per⁃ception age[J].IEEE Transactions on Robotics,2016,32(6):1309-1332.

[11]袁千贺,田昕,沈斯杰.基于多传感器融合的移动机器人定位[J].计算机系统应用,2022,31(3):136-142.

[12]Tateno K,Tombari F,Laina I,et al.CNN SLAM:real-time dense monocular SLAM with learned depth prediction[C]//IEEE Conference on Computer Vision and Pattern Recognition,2017,6565-6574.

[13]卢惠林.移动机器人的组合定位系统的研究[J].传感器与微系统,2020,39(12):53-56.

[14]Delbruck T.Neuromorophic vision sensing and processing[C]//European Solid-State Device Research Conference,2016:7-14.

[15]孔德磊,方正.基于事件的视觉传感器及其应用综述[J].信息与控制,2021,50(1):1-19.

[16]张远辉,许璐钧,徐柏锐,等.基于事件相机的人体动作识别方法[J].计量学报,2022,43(5):583-589.

[17]Gallego G,Delbruck T,Orchard G,et al.Event-based vision:a survey[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2020,44(1):154-180.

[18]Aggarwal N,Karl W C.Line detection in images through regu⁃larized Hough transform[J].IEEE Transactions on Image Pro⁃cessing,2006,15(3):582-591.

[19]岳晓峰,祁欢.基于张正友平面模板法的双目立体视觉系统标定[J].机械工程师,2014(2):1-3.

关注SCI论文创作发表,寻求SCI论文修改润色、SCI论文代发表等服务支撑,请锁定SCI论文网!

据媒体报道,三大运营商目前均已制定了2020年... 详细>>

如何设计有效的环境治理政策, 是学术界和政策... 详细>>