SCI论文(www.lunwensci.com)

摘 要 :当前的背景感知相关滤波跟踪方法通常采用固定的尺度步长与特征维度来估计目标的状态,导致跟踪精度和效率 较低。针对该问题,本文提出基于随机尺度高效响应的背景感知目标跟踪方法。首先研究随机尺度步长估计,在视频每一帧随 机生成多个不同尺度步长的目标搜索区域。然后探索多元特征高效响应,在单个目标搜索区域高效融合多个特征维度降低的响 应图。最后实验结果表明,应用所提出的方法后,跟踪目标的精确度和成功率明显增加,运行速度提高约 29.18%,具有良好 的鲁棒性和实时性。

关键词: 目标跟踪,相关滤波,背景感知,随机尺度,高效响应

Background-aware Object Tracking Method Based on Efficient Responses with Random Scales

LI Shengjie

(School of Computer Science (National Pilot Software Engineering School), Beijing University of Posts and Telecommunications, Beijing 100876)

【Abstract】:Current background-aware correlation filter-based tracking methods usually employ the fixed scale strides and feature dimensions to estimate the target state, resulting in low tracking accuracy and efficiency. Aiming at this problem, this paper proposes a background-aware target tracking method based on efficient responses with random scales. Firstly, we study the random scale stride estimation, which randomly generates multiple target search areas with different scale strides in each frame of the video. Then we explore the efficient responses with multiple features, which efficiently fuse multiple response maps produced by dimensionality reduction features in a single target search area. Finally experimental results show that after applying the proposed method, the precision and success of object tracking are significantly increased, and the running speed is increased by about 29.18%, which has good robustness and real-time performance.

【Key words】:object tracking;correlation filter;background-aware;random scales;efficient responses

0 引言

单目标跟踪是计算机视觉领域的核心问题之一,在 无人机侦查、智慧交通、动作识别和野生动物监控等领 域具有广泛的应用 [1]。目标跟踪的一个挑战性问题是如 何设计一种鲁棒的跟踪方法,该方法对于现实场景下将 要跟踪的目标没有任何先验知识(如目标的类别、形 状等), 仅利用目标的初始化状态和后续视频帧的观测 结果就可以在部分遮挡、形状变化、运动模糊、快速运 动、光照变化、背景杂波和尺度变化等场景中高效地检测和定位目标 [2]。

近年来,主流的目标跟踪方法主要分为孪生网络和 相关滤波两大类别。得益于大量数据的离线训练和昂贵 的 GPU 计算资源,孪生网络跟踪方法能够捕获目标的 高阶语义特征,从而获得卓越的跟踪性能 [3]。然而这些 在高端 GPU 上实现的孪生网络跟踪方法对于只配备通 用 CPU 的设备来说并不友好,难以实现基于 CPU 的实 时目标跟踪。

另一方面,由于训练样本的周期性假设和频域中的快速傅里叶变换,相关滤波跟踪方法具有计算效率高 的优势,使其特别适用于基于 CPU 的实时鲁棒目标跟 踪 [4.5]。特别是 Galoogahi 等 [6] 提出了背景感知相关滤 波(BACF)跟踪方法,通过增加密集采样搜索区域背 景中真实的负训练样本数目,缓解了相关滤波跟踪方法 的边界效应问题。但是 BACF 跟踪方法采用固定的尺度 步长与特征维度来生成响应图并估计目标的状态,在跟 踪精度和效率方面仍存在进一步改进的空间。因此,本 文在 BACF 的基础上,提出了一种基于随机尺度高效响 应的背景感知目标跟踪方法。

1 基于随机尺度高效响应的背景感知目标跟踪

1.1 背景感知相关滤波

BACF 的核心思想是通过增加搜索区域背景中负样 本的数目来提高相关滤波方法的判别能力,同时利用闭 式求解方案来保证跟踪效率。此外 BACF 还利用乘法器 交替方向法 (ADMM) 来训练目标搜索区域多通道特征 的定制滤波器。具体地,假定xk ∈ RD 和hk ∈ RD 分别是 目标搜索区域的第 k 维通道特征和滤波器, K 表示

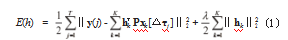

特征通道数目, y ∈ RD 是由高斯分布构成的软标签, 那么目 标函数就可以表示为如式(1)所示的岭回归形式 :

这里 λ是正则化系数, [△τj ]是循环移位运算符, y(j)表示y 的第j 个元素。为了增加背景样本的数目, 一个较小的滤波器 h ∈ RD 在具有较大目标搜索区域的 x 和y 上被训练,这里xk ∈ RT , y ∈ RT , T ≫ D。然后一个二值矩阵 P 被构建通过抑制边界效应来获得真实 的背景样本,并且裁减了信号 xk 中间的D 个元素, D 是 x 的长度。类似于文献 [4],可以将目标函数的求解 转换到频域来提高计算效率,如式(2)所示 :

这里,和中的帽子表示离散傅里叶变换。 F是离散傅里叶变换复机向量的正交 T× T 矩阵,如=Fc, c 是 T 维向量化信号。 ⊤表示共轭转置,⊗表示克罗内克积, IK 是一个 K× K 的单位矩阵。关 于以上目标函数更为详细的求解过程, 请参考文献 [6]。 此外,目标外观特征在第 t 帧的更新过程可以表达为如 式(3)所示 :

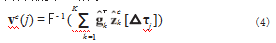

这里η 表示在线更新频率。在目标状态预测阶段,多尺度目标搜索区域 {k(c)}1 方案被采用, C 表示尺度数目,并使用这些尺度中具有最大峰值的响应图来估计 目标的位置和大小。这里每个响应图都可以在傅里叶域 中计算,如式(4)所示 :

由于利用了大量没有边界效应的背景样本,学习到 的滤波器可以变得更加鲁棒并且具有泛化性。同时在求 解背景感知相关滤波器的时候,许多有效的加速方案被 采用来减少计算量实现实时跟踪 [6]。然而 BACF 在预测 阶段采用具有固定尺度步长和特征维度的多尺度搜索区 域方案来估计目标的状态,这对于目标外观剧烈变化的 场景来说可能不是最佳的,并且会影响计算效率。针对 此,本文在 BACF 基础上提出了随机尺度步长估计和多 元特征高效响应方法,保证目标状态精准预测的同时降 低多尺度目标搜索区域和多元特征维度的数目。

1.2 随机尺度步长估计

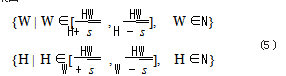

在相关滤波跟踪方法的尺度估计方面,一个最常用 的方案是利用目标搜索区域的多个尺度分辨率来估计 目标大小,例如 BACF[6]。另一个方案是通过一个专用 的尺度空间相关滤波器来估计目标的尺度状态,例如 fDSST[7]。虽然这些方案在特定场景下表现出较好的尺 度估计性能,但是它们仅使用手工设计的固定尺度步长 来应对目标外观的显著变化,而不是利用一种更为详尽 的尺度步长搜索方式。此外,也有一些文献 [9-11] 尝试 利用穷举搜索的方式来实现鲁棒的尺度估计,但是当目 标尺度在整个视频序列中变化很大时,计算效率会显著 降低。因此,一个理想的尺度估计方案不仅应该对目标 的尺度变化具有鲁棒性,而且还应该考虑该方案的计算 效率问题。鉴于此,本文探索了一种随机尺度步长估计 方案,该方案能够减少目标搜索区域的多尺度分辨率数 目,在跟踪精度和计算效率之间进行有效的权衡。具体地,假定 W 和 H 分别为目标所在搜索区域的宽度和高度,目标搜索区域的多个尺度分辨率 {c }1 在视频的每一帧被随机地生成通过如式(5)所示的宽度和长度 的集合 :

值得注意的是,除了上述多尺度分辨率外,随机尺度步 长估计方案在每一帧中始终使用宽度为 W 和高度为 H 的尺度分辨率来保证跟踪的鲁棒性。然后将背景感知相 关滤波器应用于这些具有随机尺度步长的多分辨率搜索 区域,并且这些搜索区域的中心位置与之前视频帧的跟 踪结果一致。最终的目标状态可以由具有最大峰值响应 图的搜索区域大小和预测的目标位置来确定。值得一提 的是,即使在单个视频帧中随机尺度步长估计方案所 生成的多尺度目标搜索区域可能并不包含合适的目标尺 度,但是根据连续视频序列中目标尺度变化的微小性和 平滑性,合适的目标尺度步长很可能在接下来的视频帧 中被随机地生成。因为从整个视频序列的角度来看,随 机尺度步长估计方案会在整个视频中生成大量不同的尺 度步长。在本文的实验部分也验证了随机尺度步长估计 方案可以采用较少的多尺度目标搜索区域,显著提高计 算效率的同时保持较高的跟踪精度。

1.3 多元特征高效响应

多特征集成是加强相关滤波跟踪方法鲁棒性的常用 方案。不同于常用的多种特征通道级联方案,本文提出 了基于维度降低的多元特征高效响应方案,在经过多元 降维特征生成的响应图层面进行高效融合,保持跟踪实 时性的同时提高跟踪鲁棒性。具体地,多元特征高效响 应方案采用了 3 个常用的特征,分别包括方向梯度直方 图(HOG)、颜色名称(CN)和强度通道(IC)。这里 CN 特征用于彩色视频序列, IC 特征用于灰度视频序列。

至此,两个背景感知相关滤波器被训练来计算具有不同特征的响应图,其中h 表示基于 HOG 特征的背景感 知相关滤波器,h 代表基于 CH 或 IC 特征的背景感知相关滤波器。此外,多元特征高效响应方案采用基于 标准主成分分析的维度降低技术,因此定义单个特征降 维更新后的目标搜索区域为u(t ) = (1−η)u(t −1) +ηx(t ) 然后通过线性傅里叶变换F{u(t ) }将公式(3) 重新公式化为F{u(t ) } = (1−η)F{u(t −1) } +η(t ) 。最后可以采用更新后的目标搜索区域u(t ) 构造一个投影矩阵 P(t ) ,即低维子空间。多元特征可以通过大小为× K 的投影矩阵 P(t ) 投影到该子空间上,其中表示压缩特 征后的维度。这里投影矩阵P(t ) 是通过最小化重建更新后 目标搜索区域u(t ) 的目标函数获得的,如式(6)所示 :

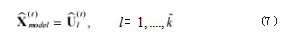

其中, m 表示覆盖目标搜索区域u(t ) 中所有元素的索引元组。更新后的目标搜索区域可以使用降维后的目标搜索区域(t ) = F{P(t ) u(t ) }来表示,如式(7)所示 :

在目标状态预测阶段,第 c 个尺度目标搜索区域z(t )c 的响应图可以通过单个特征滤波器在降维目标搜索 区域c = F{P(t −1) z(t )c } 上计算所得如式(8)所示 :

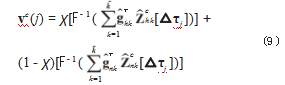

为了高效地融合由多元维度降低特征产生的这些响 应图,可以利用常数参数χ 给不同特征响应图分配不同 的可靠性值,以完成高效多元特征响应融合。因此,公 式(8)可以改写为如式(9)所示 :

1.4 目标跟踪总体流程

联合背景感知相关滤波、随机尺度步长估计和多元 特征高效响应,本文提出了基于随机尺度高效响应的背 景感知目标跟踪方法。整个跟踪过程分为两部分 :滤 波器训练阶段和目标状态预测阶段。在滤波器训练阶 段,通过增加真实背景样本的数量来训练基于多元维度 降低特征的不同背景感知相关滤波器。在目标状态预测 阶段,首先应用随机尺度步长估计方案,通过公式(5) 抽取多个尺度目标搜索区域,然后采用经过训练的背景 感知相关滤波器和多元特征高效响应通过公式(9)计 算最终的响应图,最后使用最大峰值响应图的目标搜索 区域来预测目标的状态。

2 实验分析

为了充分评估所提出方法的有效性,本文在两个 标准基准数据集上进行了详细的实验 :OTB2013[1] 和 DTB70[2]。这些基准涉及具有各种挑战的视频序列,包 括快速运动、运动模糊、平面内旋转、尺度变化等。具 体地, OTB2013 通过 51 个视频序列来评估 29 个流 行的跟踪方法。DTB70 是由无人机收集的 70 个视频 组成,共有 15777 帧。本文遵循这些数据集中的协议 和评估指标标准,包括精确度(Precision)和成功率 (Success)。精确度衡量目标中心位置在真实位置 20 个像素点范围内的帧率,成功率度量跟踪结果和真实框 之间的重叠百分比。此外,所有实验中都采用了一次性 评估策略(OPE)。

本文所提方法在没有任何优化的 MATLAB 中执行。

所有实验均在配备 Intel Core i7-1165G7 CPU(2.80GHz)、 16 GB RAM 的电脑上实施。在 OTB2013 上,本文所提 方法以大约平均 45.6 帧每秒(FPS)的速度运行。正则 化参数 λ设置为 0.01.学习率η 设置为 0.014.HOG 和 CN/IC 的响应可靠 χ 为 0.7.尺度因子 s 为 1.75. 多尺度目标搜索区域数量 C 为 3.

2.1 解耦分析

从理论上讲,本文方法主要与随机尺度步长估计和 多元特征高效响应有关,因此实现了另外 4 种方法来证 明本文方法的有效性。(1)以多尺度分辨率背景感知相关滤波器为基线实现 BACF ;(2)构建了没有多尺度目 标搜索区域方案的 BACF(BACF-NS) ;(3) 在 BACF 上生效了仅利用随机尺度步长估计的跟踪方法(BACF- RS) ;(4)在 BACF 上实现了仅使用多元特征高效响应 的跟踪方法(BACF-ER)。如表 1 所示给出了以上跟踪 方法在 OTB2013 上有关精确度、成功率以及跟踪速度 的解耦分析实验结果。从表 1 中可以看出,相比较于 BACF-NS,本文方法和 BACF 通过不同的尺度估计方 式提高了跟踪性能,这说明了准确尺度估计对于目标跟 踪方法的重要性。此外与 BACF-RS 和 BACF-ER 相比,本文方法在精确度和成功率方面均有不同程度的提高, 这说明了本文所提出的随机尺度步长估计和多元特征高 效响应是有效的。最后在所有评估指标方面,本文方法 均优于基线跟踪方法 BACF,尤其是平均运行速度提高 了约 29.18%,以 45.6 帧每秒的平均速度表现出良好的 实时性。

2.2 定量分析

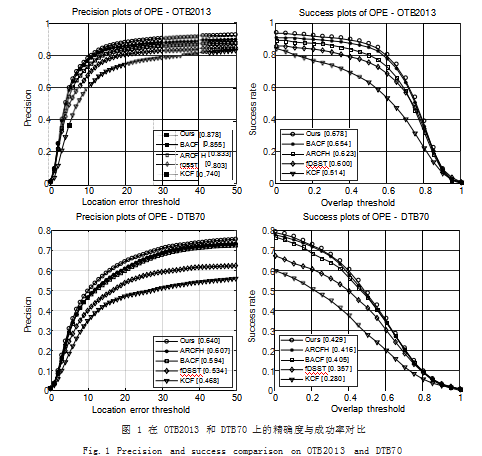

本节通过与流行跟踪方法在 OTB2013 和 DTB70 上的对比来评估本文方法的有效性,包括异常抑制相关 滤波 ARCFH[8]、基线跟踪方法 BACF[6]、尺度空间滤波 fDSST[7] 以及核化相关滤波 KCF[4]。如图 1 所示显示了 所有跟踪方法在 OTB2013 和 DTB70 上的精确度和成 功率得分。由图 1 可知,本文方法在精确度和成功率方 面都优于其他方法,表现出良好的跟踪鲁棒性。值得注 意的结果是与 KCF 相比,本文方法在 DTB70 的精确度 和成功率方面显著提高了 17.2% 和 14.9%。

2.3 定性分析

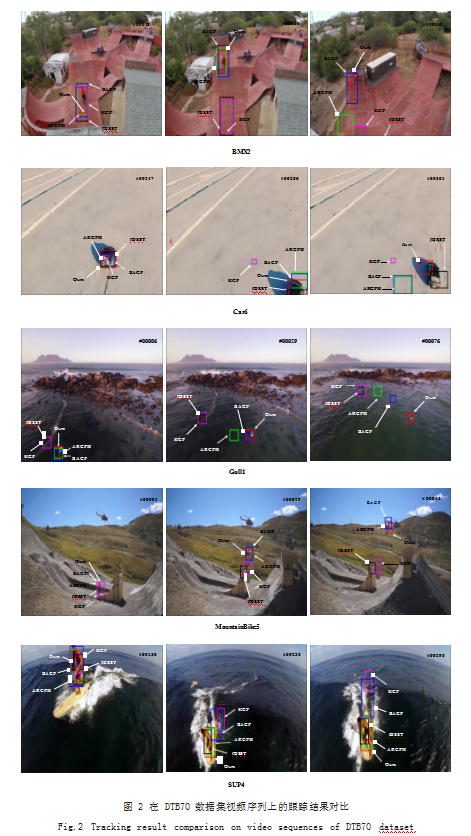

如图 2 所示给出了本文方法、ARCFH、BACF、fDSST 与 KCF 在 DTB70 数据集视频序列上的跟踪结果对比,包 括 BMX2、Car6、Gull1、MountainBike5 与 SUP4 视 频 序列。由图 2 可知, ARCFH 和 fDSST 能够很好地处理尺 度变化和形状变化(Car6 和 SUP4) 等挑战性场景, 但在 低分辨率和平面内外旋转(Gull1 和 MountainBike5) 等 情况下会发生跟踪漂移。BACF 和 KCF 在背景杂波和 运动模糊的视频序列(BMX2)中表现出很强的判别能 力,但是在出视场外和部分遮挡发生(Car6 和 SUP4) 时表现不佳。然而本文方法在估计这 4 个具有挑战性视 频序列的所有目标位置和大小方面都非常的准确,主要 原因可归纳为以下两个方面 :一方面是由于随机尺度步 长估计,在视频每一帧随机生成多个不同尺度步长,实 现了高效的尺度估计 ;另一方面是因为多元特征高效响 应,快速地融合多个特征维度降低的响应图,使得本文 方法能够鲁棒地处理平面内外旋转、形状变化、部分遮 挡和背景杂波等情况,缓解目标跟踪漂移的问题。

3 结语

本文在背景感知相关滤波的基础上,提出了基于随 机尺度高效响应的背景感知目标跟踪方法,通过随机尺 度步长估计和基于维度降低的多元特征高效响应,解决 了固定的尺度步长与特征维度问题,降低了多元特征维 度和多尺度目标搜索区域数目。在 OTB2013 和 DTB70 数据集上详细的实验评估表明,本文方法提高了基线跟踪方法的预测精度和计算效率,并且与流行的跟踪方法 相比在实时性和鲁棒性方面表现良好。

参考文献

[1] WU Y,LIM J,YANG M H.Online Object Tracking:A Benchmark[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2013:2411-2418. [2] LI S,YEUNG D Y.Visual Object Tracking for Unmanned Aerial Vehicles:A Benchmark and New Motion Models[C]// Thirty-first AAAI Conference on Artificial Intelligence, 2017.

[3] 张雨杨,施展.基于背景感知相关滤波的深度提取跟踪算法 研究[J].软件,2020.41(3):84-87.

[4] HENRIQUES J F,CASEIRO R,MARTINS P,et al.High- Speed Tracking with Kernelized Correlation Filters[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015.37(3):583-596.

[5] 朱建章,王栋,卢湖川.背景与时间感知的相关滤波实时视觉 跟踪[J].中国图象图形学报,2019.24(4):48-61.

[6] GALOOGAHI H K,FAGGA,LUCEY S.Learning Background- Aware Correlation Filters for Visual Tracking[C]//Proceedings of the IEEE International Conference on Computer Vision, 2017:1135-1143.

[7] DANELLJAN M,HÄGER G,KHAN F S,et al.Discriminative Scale Space Tracking[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017.39(8):1561-1575. [8] HUANG Z Y,FU C H,LI Y M,et al.Learning Aberrance Repressed Correlation Filters for Real-Time UAV Tracking[C]//Proceedings of the IEEE International Conference on Computer Vision,2019:2891-2900.

[9] LI S J,ZHAO S,CHENG B,et al.Efficient Particle Scale Space for Robust Tracking[J].IEEE Signal Processing Letters, 2020.27:371-375.

[10] LI S J,ZHAO S,CHENG B,et al.Noise-Aware Framework for Robust Visual Tracking[J].IEEE Transactions on Cyber netics,2022.52(2):1179-1192.

[11] LI S J,ZHAO S,CHENG B,et al.Dynamic Particle Filter Framework for Robust Object Tracking[J]. IEEE Transactions on Circuits and Systems for Video Technology,2022.32(6): 3735-3748.

关注SCI论文创作发表,寻求SCI论文修改润色、SCI论文代发表等服务支撑,请锁定SCI论文网!

文章出自SCI论文网转载请注明出处:https://www.lunwensci.com/jisuanjilunwen/55882.html