SCI论文(www.lunwensci.com):

摘要:对RGB-D数据的三维重建进行优化,由此提出基于时间连贯的重建策略。在完成数据收集之后,对其中的RGB数据进行光学特征点的提取,由此获取两帧相互之间的初始系数3D关系。在对这些特征点进行细化时,则运用了最优几何匹配系统,然后利用特征点对连续帧的三维点云展开匹配,这个过程与帧分辨率独立;最后完成时间连贯的3D动画重建,具体是借助于运动向量对齐策略。通过实验得出,本文提出的策略能够对该3D动画进行重建。相较于其他方法,数据利用率更高,同时还有较高的精准度,在计算效率方面也具有一定优势。

关键词:RGB-D数据;特征点;3D重建;最优几何匹配;平均误差

Research on Rebuilding Time Coherent 3D Animation under Optimal Geometry Matching Program

WANG Yongliang

(Fuyang Vocational and Technical School,Fuyang Anhui 236000)

【Abstract】:The three-dimensional reconstruction of RGB-D data is optimized,and a reconstruction strategy based on time coherence is proposed.After the data collection is completed,the optical feature points are extracted from the RGB data,so as to obtain the initial coefficient 3D relationship between the two frames.When refining these feature points,the optimal geometric matching system is used,and then the feature points are used to expand and match the three-dimensional point cloud of consecutive frames.This process is independent of the frame resolution;finally,the time-continuous 3D animation reconstruction is completed.Specifically,it is with the help of the motion vector alignment strategy.Through experiments,it is concluded that the strategy proposed in this paper can reconstruct the 3D animation.Compared with other methods,the data utilization rate is higher,and at the same time there is a higher accuracy,and it also has certain advantages in terms of calculation efficiency.

【Key words】:RGB-D data;feature points;3D reconstruction;optimal geometric matching;average error

0引言

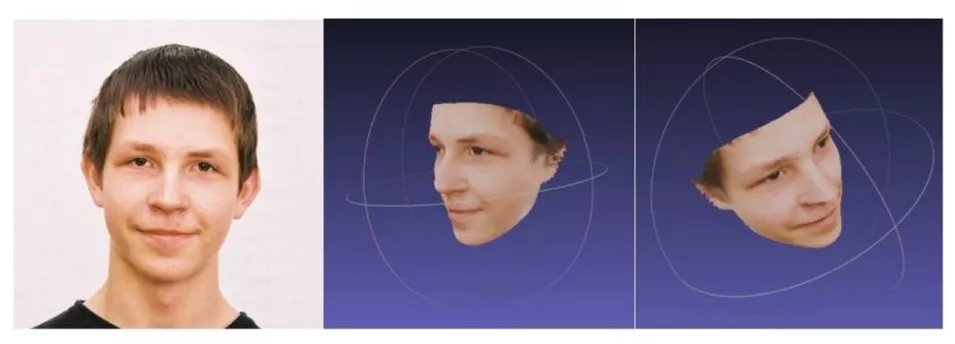

当前,3D动画重建技术广泛应用在越来越多的领域,而且发挥着重要作用。生活中很多方法都利用多视角RGB进行重新构建3D动画,之后利用一系列现代技术进行捕捉连贯动画。在这之中,最重要属性就是所有动画都具有时间连贯性,一部分经过处理的动画图像也必须具有时间连贯性,比如场景分析与视频编辑等都会用到。想要使RGB数据系统作用发挥到实处,就必须使用多个相机最少两个相机来进行3D重建,从而也导致底层的图像配准算法与底层特点决定了3D重建的质量好坏。本文基于RGB-D视频数据提出了时间持续性的3D动画重建方法。当完成数据收集工作后,就能以此视频数据为对象,对其光学特征点进行提取,进而获取两帧之间的初始稀疏3D关系[1]。随后对特征点进行细化,具体运用的是迭代几何匹配程序,这样就能实现三维点的有效匹配。相较于其他方法,本文所提出的重建方法优势体现在:第一,运用了隐式三维数据,对其动态对齐。传统方法在重建时,仅仅依赖RGB数据,对动态场景下的底层表征则给予了忽视。第二,本次提出的几何匹配策略,对过去深度映射带来的较大误差问题进行了很好解决。通过实验,得出本文提出的方法具有较高的有效性。

1 3D动画重建方法

系统输入属于典型3D云序列,其中涉及到某个或者数个相机的RGB映射。每一帧的3D点云呈现出相互独立关系,同时每一帧的对应点云数量也具有差异性。假定将某个点云使用下式表示C=(V,T),其右侧表达式就是该点的集合,以及点在点云中的映射(RGB)。

由此可见,(V,T)∈C[2]。三维位置使用p进行表示,将其与相应点的坐标(x,y,z)进行关联;纹元对应的是图像2D位置,使用q进行表示,相应纹理坐标使用(u,v)表示,其中q∈T,借助于T的作用,就能将深度数据中的V,也就是三维位置映射至RGB。本文分析的视频数据,是一个典型的视频序列,涉及到N时间帧,为此,点云序列就是时间t函数。这样就能获得C(t)=(V(t),T(t))。其中的t从零至N-1。该算法的目的就是将C(0)映射至序列C(t),在动画序列之上,对C(0)加以跟踪。具体而言,要从C(0)至C(1)映射,进而获得与后者能够对齐的C0(1),由此V(0)∈C(0)成立。这样C0(t)即为在通过t次迭代之后,和C(t)对齐,进而得到C(0),其中t在零值N-1之间。由此,本文的公式和其余跟踪系统都缺乏显著不同[3]。本文算法是基于相应的t,获取C0(t),由输入至输出。

1.1特征点估计

将输入用Ic(t)表示,具体是RGB帧,相机与时间步为t和c,第一步,根据它们对2D下的恒定特征转换位置进行提取,该转换使用SIFT表示。对于各个视频序列,每个输入影像图的特征在2百至3百之间。借助于该转换特征,能获取更多优势,譬如稳定性、准确度、尺度不变性等。而且这些特征与纹理空间位置具有对应关系,具体表达式:q(t)=(u,v,t)。借助于(V(t),T(t))∈C(t),就能将相应的特征映射至p(t)∈V(t)。t与该特征点具有关联性的三维点集合,就能对光学特征点进行表示,该点用L(t)表示[4]。接着,借助于欧式距离,对D进行度量,获得匹配的相应特征,从而使得L(t)与L(t+1)存在映射关系。目前这种匹配算法,在实现过程方面颇为简单,倘若最近与次近特征之间的比例,比某个阈值更低,于是就能将其构建相应的匹配。这种方法,还能对很多假阳性样本进行去除。可是,由RGB至深度数据之间的映射,呈现出“1:n”的关系,而非“1:1”的关系。于是,将某个q(t),映射至三维空间,就有数个p(t)距离较近。为此,就存在着与该特征存在着相同关联特定点,也就是l(t)∈L(t)。倘若借助于L(t)与L(t+1)映射关系,来对C(t)与C(t+1)加以匹配,那么要对其中非确定性问题进行处理,另外,t处对应的相应特征,仅仅和某个p(t)进行关联。该方法主要借助于几何匹配算法,对其中最为可靠的特征点进行遴选,进而对其中的非确定性进行去除。

1.2运动向量对齐

为了将C(t)和C(t+1)加以对其,就需要对V(t)∈C(t)映射进行获取。利用特征点关系,就能获得稀疏匹配,亦即是M(t)。为了让那些与后者没有关联性的特征点p(t)∈V(t),构成相应的映射关系[5],本文所采用的算法具体步骤如下所示:

第一步:寻找出距离最短的N个特征点位置Ln(t)p(t),其中n=0,…,N-1。

第二步:通过M(t)寻找出从Ln(t)点到t+1点所映射出的Ln(t+1)点。

第三步:寻找出Vn(t)运动向量,并需要满足于Vn(t)=Ln(t+1)-Ln(t)。

第四步:通过计算得出全部Vn(t)之和,将结果并除以N,最终结果为p(t)平均运动向量是Vp(t)。

第五步:利用p(t+1)=p(t)+Vn(t),得出p(t)匹配p(t+1),即匹配点在Ln(t+1)到Ln(t)之间。

要基于平均运动距离一致的区域,按照五个最近特征点,对相应运动向量进行计算。进而获得t+1区域的匹配点。当给定动态对象正处于任意运动状态,那么形变大概率具有等距性,这样,本文提出的对齐算法即具有一定的合理性。当然,对于极端非等距形变,本文算法的适用性较弱。另外,文章还验证了数据集算法,结果显示该算法具有较佳的准确度,对时间连贯性进行提取,即便是噪声会让深度数据在相应区域之中,有一定空洞,或者深度传感器遭受制约,同时区域运动信息具有极端性,利用本文的方法,依然能够实现动态跟踪。

2实验结果和验证

2.1数据集

基于三个数据集,运用3D动画重建,其中一个数据集,涉及到8个RGB相机对行人信息进行采集,进而对视觉外壳中,对点云数据进行提取。另外两个则对视频采集系统进行运用。各种序列长度都超过了百帧。

对前面两大数据集而言,这两个连续帧的特征点,其平均的匹配数量达到3百个。对于第三个数据集而言,匹配数量则是150个。前面两大序列,对应相机的点数量均值已经达到6万,而第三个,则十分稀疏。本文提出的3D动画重建策略,即便是有较大的时间与空间噪声,依然能够获得时间连贯性。尤其是缺乏视频流深度数据依然能够通过该方法来进行解决。即便最后序列没有通过视频采集框架获取,只要此数据集存在RGB映射动态点云格式,就能得出本文算法能够在不同数据集上实现。

2.2定量分析

在本文实验中,定量分析就是检测特征点映射过程,是不是有助于提升跟踪性能,以及特点点数N,对最终跟踪效果的作用。通过对齐算法,获取N数量的最近特征,这样就能为p(t)打造相应的向量场。对于N大小,主要和运动目标外形、类型有着关联性。譬如,借助于全局变换,动画处理目标,这样,对N进行增加,则不会对误差进行显著提升,并能对匹配的误差均值进行降低。另外,部分目标还涉及到局部运动,譬如人体,其中某个部位有了独立性运动,那么N增加数超过某个相应阈值,就会使得动画变得不正确。对于“老虎气球”序列,因为它几乎没有局部运动,为此,在N数增长后,该平均误差呈现出逐渐下降的特点。表1给出了不同N值的误差均值。其中,给出了簇类两点的随机匹配等方面的误差。对这些数据进行分析可知,在N值达到10时,对应误差均值为2.55%,到了20,则是1.9%。这意味着,在N值增长时,该误差虽然下降,但是并呈现出线性下降。虽然,该N值增大,能减小误差,然而会让运动呈现出正规化特点。当前,在该气球序列视频中,当N为10时,可以获得较佳的结果。

为了验证几何特征点映射情况,同时是用来三种匹配方法,分别为几何匹配、随机匹配与质心匹配,之后将其得出的平均误差与全部序列误差进行对比。当N=5时,使用期上诉三种匹配方法时,在这之中含有一个老虎气球序列的平均误差。通过分析得出,通过本文方法进行皮牌的误差平均值更小,这就代表本文所研究方法可以将多个光学特征点与SIFT特征匹配点相联系的不确定性问题进行解决。对于“老虎气球”多目标序列而言,本文所运用的两大度量,亦即是多目标跟踪精度与准确度,它们分别使用MOTP和MOTA进行表示。对该点云时间连贯性进行评价。通常,在N为5之际,它们分别低于7mm,超过9.5成。为此,这两个层面都表现优秀。此外,非连贯点与连贯点云的轮廓,有着差异性的重叠。为此,本文方法中误差均值不超过0.02。这意味着该重建法能够很好跟踪动态序列。为了对所提出的文献和方法[5-6]加以对比分析,具体可以运用Capoeira序列,具体数据如表2所示。有关随机与质心匹配,在误差方面基本相类。本文所选用的匹配算法,则能将误差均值减小0.005。这一点和上述的测试结果基本相类。

本文提出的重建方法,能够在不同帧中维持统一,与该方法相近的则是文献[5]给出的方法,获得了较佳的效果。不过文献[6]中的数据则有了较为显著改变,特别是头部信息,因为有着较多的缺失。为了对比其他方面,利用三维点云,其中文献[5]和文献[6]对应的点云,有了一定的改变,而且后者改变最为突出。它主要运用的是单个深度相机,因此容易带来较多的数据丢失问题。此外,本文所提出的方法,存在着计算层面的高效属性,平均来说,其帧速为每分钟25帧,由此对连贯动画加以重建。在对双核i5处理器进行配置后,对一百帧序列进行处理,总共耗时约为5分钟,得到表3结果[7]。从中得出,本文所提出的方法,相较于文献[6]而言,速度快了四分之一,和文献[5]的速度,则基本上一致。

3结论

本文提出在不同视角下对于RGB-D视频数据中进行重建时间连贯的3D动画方法,主要是通过无偏特征3D点云中各个点位与下一帧进行的全面映射。实验最终评价是通过多组Kinect所记录的数据所记录的,通过实验结果可以看出,本文所提方法是否成功,在运行效率与误差方面表现都较为突出[8]。本文所提出的方法可以用于较多十五中,例如场景分析与视频剪辑等。当然,本文所提出的方法也存在一定局限性,文中方法其中全部步骤都需依照欧式距离来测量,它存在一定的硬件约束,之后也会将这一缺点进行完善。

参考文献

[1]林正日,孙志斌,Pavel Paces,等.基于TOF-3D相机单视角物体表面重建研究[J].电子设计工程,2018,26(12):50-54.

[2]汪香香,张成,沈川,等.三维复杂场景的菲涅耳全息图频域压缩重建[J].光学学报,2017,37(7):83-90.

[3]胡正乙,谭庆昌,孙秋成.基于RGB-D的室内场景实时三维重建算法[J].东北大学学报(自然科学版),2017,38(12):1764-1768.

[4]李祥攀,张彪,孙凤池,等.基于多视角RGB-D图像帧数据融合的室内场景理解[J].计算机研究与发展,2020,57(6):1218-1226.

[5]Fu Y P,Yan Q G,Yang L,et al.Texture mapping for3D reconstruction with RGB-D sensor[C].2018IEEE/CVF Conference on Computer Vision andPattern Recognition,2018:89-97.

[6]MehtaD,SridharS,SotnychenkoO,etal.VNect:Real-time 3D human pose estimation with a single RGBcamera[J].Acm Transactions on Graphics,2017,39(7):83-92.

[7]李鹏.基于虚拟现实技术的移动端交互性动画自主生成方法研究[J].自动化与仪器仪表,2020(12):169-172.

[8]王菲,王球,孙建龙,等.真实数据驱动下的变电站三维智能仿真技术研究[J].智慧电力,2020,48(7):112-117.

关注SCI论文创作发表,寻求SCI论文修改润色、SCI论文代发表等服务支撑,请锁定SCI论文网!

文章出自SCI论文网转载请注明出处:https://www.lunwensci.com/jisuanjilunwen/40439.html