SCI论文(www.lunwensci.com)

摘要:机械臂操作动态工件在分拣、上下料等作业场合有着广泛的需求。针对特定型号工件的移动机械臂动态抓取问题,提出一种基于特定工件ID编号识别和机械臂抓取位姿预测的运动工件鲁棒抓取方法。该方法选取AprilTag视觉标签来标记工件,通过图像采集、自适应阈值处理、连续边界分割、四边形拟合、快速解码等数据处理过程,获取局部视野下运动工件的ID、位置和姿态,实现工件的初次定位。结合移动机械臂的运动规划工艺策略,对特定型号目标工件的抓取位姿进行计算,实现抓取时刻的工件位姿预测。搭建了动态抓取实验平台进行了视觉标签ID识别、工件定位、动态目标抓取实验。结果表明,所提出的移动机械臂动态抓取方法,可以准确识别特定型号工件,并能够对不同运动速度的特定工件进行鲁棒抓取,抓取成功率平均值约为98%。该方法在智能产线的移动机械臂上下料等场景有着广泛的应用价值。

关键词:动态抓取;移动机械臂;局部视觉;特定工件

Local Vision-based Specific Workpieces Dynamic Gripping Method for Mobile Manipulators

Diao Shipu1,Li Zhaopeng2,Cui Guanqun2

(1.School of Automation,Guangdong University of Technology,Guangzhou 510006,China;

2.School of Mechatronic,Guangdong Polytechnic Normal University,Guangzhou 510665,China)

Abstract:Performing moving workpiece operations with operator has a wide range of demands in sorting,loading/unloading operations.A

robust gripping method for moving workpieces based on specific workpiece ID number recognition and operator grasping position prediction is

proposed for the dynamic gripping problem of specific types of workpieces.This method selects the AprilTag visual label to mark the

workpiece,and through data processing processes such as image acquisition,adaptive threshold processing,continuous boundary segmentation,

quadrilateral fitting,and fast decoding,obtains the ID,position,and posture of the moving workpiece under local vision,realizing the initial

positioning of the workpiece.Combined with the motion planning process strategy of the mobile manipulator,the grasping pose of a specific

type of target workpiece is calculated to achieve the prediction of the workpiece position at the grasping time.A dynamic grabbing experimental

platform was built for visual label ID recognition,workpiece positioning,and dynamic object grabbing experiments.The results show that the

proposed dynamic gripping method for mobile robotic arms can accurately identify specific types of workpieces and perform robust gripping on

specific workpieces with different motion speeds,with an average gripping success rate of about 98%.This method has broad application value

in scenarios such as loading and unloading of mobile manipulators in intelligent production lines.

Key words:dynamic gripping;mobile manipulators;local vision;specific workpiece

0引言

目标工件自主抓取是机器人最为典型的应用之一,相关技术在智能生产线的上下料场景中被广泛应用[1-3]。在工件多流程加工或者多工位协同装配等场合,都需要对特定型号工件多工位转运。目前,各工位之间的工件运输,主要采用人工拾取和推车托运方式,不仅人力成本较高,而且生产效率低下,难以适应智能制造的作业要求。近年来,上下料移动机械臂在自动化动态备料产线中的应用越来越广泛[4-5]。机器人控制技术与视觉技术相结合,所形成的机器人视觉抓取技术是目前该领域较为成熟的技术方案[6-9],其中动态抓取作业方式可大幅提高机器人系统的作业效率。

国内外对运动物体的机器人动态抓取做了大量的研究。Pengzhan Chen等[10]提出了一种基于深度强化学习和物体检测技术的接近-跟踪-抓取算法,并采用一种改进的软行为批判算法来加速学习过程,但是这种抓取方法对于硬件计算资源要求较高。Jie Huang等[11]设计了一个运动物体跟踪算法来跟踪物体,并基于机器人操作系统ROS,验证了对随机运动物体跟踪抓取的有效性,但是这种方法不能对特定目标工件进行有选择的抓取,难以实现基于工艺策略的工件操作。郝大孝等[12]为提高机器人动态抓取的速度与精度,利用Delta机器人视觉系统定位抓取目标位置,并与控制系统相融合,实现了目标的动态抓取,但是全局视觉的定位方式限制了该方法的使用场景。倪鹤鹏等[13]提出了一种基于牛顿-拉夫森迭代和新型图像去重策略的动态抓取算法,根据预测工件直线运动到达固定参考点的时间进行抓取,但是这种方法在产线配置的灵活性不足,且计算过程实时性不足。李志昂等[14]提出了一种基于SURF算法和RGB颜色空间的目标对象特征提取算法,用以缩短机械臂在产品抓取过程的耗时,但该方法对目标工件的初始姿态有较高要求。针对姿态存在随机偏差的工件操作,董大钊等[15]提出了一种基于图像处理的机器人位姿在线校正算法,但是该算法对硬件计算资源要求较高。Bhusapalli Dhamodar Reddy等[16]将快速响应(Quick Response,QR)码引入全向移动机器人的运动规划,使得移动机器人可以在没有任何整体环境信息的情况下,以较少的计算时间自主地规划出一个最短的运动路径。Mooi Khee Teoh等[17]利用针孔成像理论的基本原理和类似的三角形规则,将三维环境中的二维码角点与二维图像相对应,并使用QR码的四个顶点作为定位点,从欠确定的系统中提取三维(3D)位置信息。视觉标签在机器人智能化操作中的应用越来越广泛,因此有必要将二维码相关技术引入移动机械臂动态抓取。

针对上述研究的不足,本文采纳了视觉标签的优势,提出一种基于眼在手上视觉感知方式的特定型号工件移动机械臂动态抓取方法。该方法的关键是对特定工件的视觉标签ID检测和抓取位姿预测,包含特定型号工件识别、工件初次定位、工件抓取姿态预测等步骤。

1方法

本文的特定工件动态抓取基于特定工件ID编号识别和机械臂抓取位置预测。

1.1特定型号工件识别

本文基于AprilTag视觉标签[18]对特定型号工件ID进行识别,AprilTag是一种视觉定位标志符,类似于二维码或者条形码,可以用于快速检测标签并计算其位姿。AprilTag是由Uni‐versity of Michigan的APRIL Ro‐botics Laboratory提出的视觉基准系统(Visual Fiducial System),其应用领域涵盖AR、机器人、相机校正等领域。本文采用Tag36h11视觉标签(图1),该族标签编码范围为0到586,既能对足够多的工件进行编码,又能满足位姿计算的实时性要求。

1.2工件初次定位

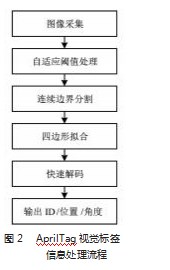

工件初次定位是为了获得工件的初始位姿。如图2所示,识别AprilTag视觉标签时,一般按照图像采集、自适应阈值处理、连续边界分割、四边形拟合、快速解码、输出ID和位姿的信息处理流程[18]。

其中,四边形拟合的输出是一组候选四边形,解码的核心是寻找四边形的4个顶点。当存在视觉标签变形时,需要首先对无序轮廓点以重心为旋转中心实施排序;然后依次选取距离中心点设定范围内的点实施直线拟合,并迭代求取直线的误差和;接着对误差和进行低通滤波,选取误差和最大的4条直线用于确定四边形角点;最后选取角点进行直线拟合,4条直线的角点就是视觉标签的顶点。

1.3工件抓取位姿预测

静态视觉引导系统控制相机采集图像,处理图像并将其处理结果传递给运动控制系统,引导其实现工件抓取操作。由于工件在传送带上匀速运动,要对目标工件精准抓取就必须预测抓取位姿,使机械臂在恰当的位置以恰当的姿态抓取工件。

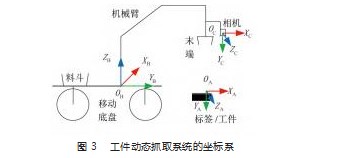

本文的移动目标抓取方法考虑了工件随传送带的运动,用于精确地预测抓取位姿。如图3所示,本文的工件动态抓取系统涉及到机械臂基坐标系XB-YB-ZB,局部相机坐标系XC-YC-ZC,工件坐标系XA-YA-ZA。视觉系统的标定方法可以参考文献[19]。

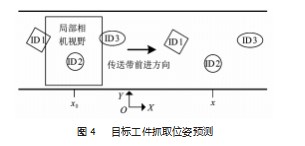

如图4所示,假设目标工件一次定位后的坐标为(x0,y0),传送带的运动速度为v,从工件初次定位到机械臂实施抓取的时间设定为t,那么可以求得动态目标工件的位置坐标(x,y)为:x=x0+vt,y=y0。另外,在机械臂抓取过程中,目标工件的姿态,相对机械臂基坐标系保持不变。

2实验

为了验证本文所提出的特定型号工件机械臂动态抓取方法的有效性,搭建了所需的动态抓取实验平台,并基于该平台进行了机械臂抓取过程的视觉标签ID识别与定位实验、动态目标抓取实验。

2.1实验环境搭建

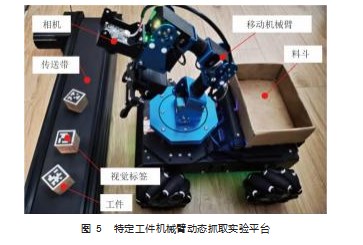

实验平台如图5所示,包含移动机械臂、料斗、局部相机、传送带、视觉标签和工件。采用的移动机械臂为定制型号,负载500 g,理论重复定位精度为±1.0 mm;采用的局部相机像素值为800 W像素,感光芯片为索尼IMX219,对角视场角为160°,默认设定高度为60 mm;采用的视觉标签为Tag36h11标签族,视觉标签固定在工件上;传送带运动速度范围为2~20 mm/s;料斗用于放置所抓取的特定型号工件。

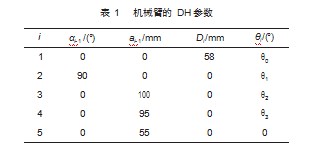

如图3所示,移动机械臂的基坐标系在移动底盘的上平面。机械臂DH参数如表1所示。

2.2视觉标签ID识别实验

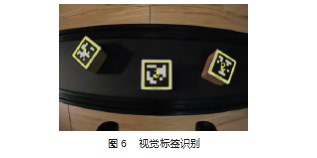

根据1.2节方法开展了视觉标签ID识别与定位实验。首先分别打印Tag36h11视觉标签的编码1、2、3,然后将编码分别固连在待抓取的工件上面,为视觉标签ID识别实验做好准备工作。

在移动机械臂特定位置、特定姿态下,通过局部相机可以获取当前场景的二维图像信息。使用1.2节的方法,识别出视野内的视觉标签(图6)。

识别了视觉标签的ID后,移动机械臂就可以根据识别到的ID编码信息,抓取所需的特定型号目标工件。多次实验结果统计发现视觉标签识别准确率为100%。

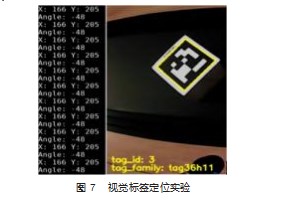

2.3视觉标签定位实验

使用上述方法,对视觉标签信息进行处理,可以定位出视觉标签中心点的位置,以及视觉标签的旋转角度(图7)。

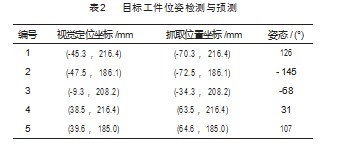

表2是传送带速度为5 mm/s、机械臂在初次定位后5 s实施抓取的设定情形时,记录得到的5组视觉定位和抓取位置预测的实验结果。5组结果视觉标签放置位置分别为机械臂基坐标系的YB-ZB平面与传送带上表面交线的右上方、右下方、中间、左上方、右下方,位姿具有代表性。

表2展示的结果是以机械臂基坐标系描述的x值和y值(视觉系统的标定方法参考文献[14],这里不再详述)。视觉定位和抓取位置的z值,均为传送带平面与机械臂基坐标XB-YB平面的高度差,即-10 mm。另外,传送带的运动正方向与机械臂基坐标系的XB方向一致。

2.4动态目标抓取实验

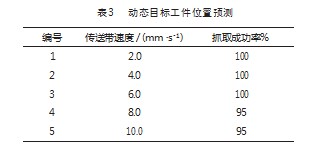

为了验证本文提出的动态目标抓取方法的有效性,开展了动态目标抓取实验,分别设定传送带的速度为2、4、6、8、10 mm/s,并在不同速度设定值工况下测试20次。

动态目标工件位置预测结果如表3所示。发现在传送带的一定运动速度范围内,多次实验结果统计得出动态目标抓取成功率平均值约为98%。同时发现,抓取成功率随着传送带运动速度的提升而降低,其原因是机械臂末端夹持工具与运动工件的接触瞬间存在冲击,可以通过改变夹持工具的形态来提高夹持成功率。

3结束语

智能生产线对机械臂动态作业系统的作业效率要求越来越高。鉴于当前的移动机械臂动态抓取方法存在作业灵活性不高、部署成本较高、对硬件计算资源要求较高等不足,本文运用机械臂末端的局部视觉系统,通过图像采集、自适应阈值处理、连续边界分割、四边形拟合、快速解码等数据处理过程,构建了一种面向特定型号工件的移动机械臂动态抓取方法。该方法不仅能提高产线的作业效率,而且改善了机械臂的作业灵活性。实验验证了该方法的视觉标签ID识别、定位的鲁棒性,以及动态目标抓取方法的有效性。多次实验结果表明,机械臂抓取特定动态目标的平均成功率约为98%。提出的特定型号工件移动机械臂动态抓取方法不仅适用于智能制造生产线的高效率动态作业场合,也可用于复杂数字车间内特定型号工件的移动机械臂动态上料场景。

参考文献:

[1]吴斌.基于工业机器人的智能制造生产线设计[J].机床与液压,2020,48(23):55-9.

[2]智能制造编辑部.《中国机器人产业发展报告(2021年)》发布[J].智能制造,2021(6):6.

[3]田学军,彭雪敏,谭文渊.基于嵌入式机器视觉的机器人抓取系统[J].机电工程技术,2019,48(12):26-9.

[4]陈梅,车尚岳.无标定视觉伺服机器人跟踪控制策略研究[J].控制工程,2019,26(6):1055-9.

[5]陶波,龚泽宇,丁汉.机器人无标定视觉伺服控制研究进展[J].力学学报,2016,48(4):767-83.

[6]WANG Y,TANG C,CAI M,et al.Real-time underwater onboard vision sensing system for robotic gripping[J].IEEE Transactions on Instrumentation and Measurement,2020,70:1-11.

[7]ROSENBERGER P,COSGUN A,NEWBURY R,et al.Object-in‐dependent human-to-robot handovers using real time robotic vision[J].IEEE Robotics and Automation Letters,2020,6(1):17-23.

[8]ALI M H,AIZAT K,YERKHAN K,et al.Vision-based robot ma‐nipulator for industrial applications[J].Procedia computer sci‐ence,2018,133:205-12.

[9]邓群,周波,胡国武.基于视觉识别及机器人技术的变速箱悬置自动拧紧设备[J].机电工程技术,2022,51(3):217-20.

[10]CHEN P,LU W.Deep reinforcement learning based moving ob‐ject grasping[J].Information Sciences,2021,565:62-76.

[11]HUANG J,ZHANG F,DONG X,et al.Vision-guided dynamic object grasping of robotic manipulators[C]//2020 IEEE Interna‐tional Conference on Mechatronics and Automation(ICMA),New York:IEEE,2020.

[12]郝大孝,舒志兵,孙学.基于机器视觉的Delta机器人分拣与跟踪系统设计[J].机床与液压,2019,47(17):36-42.

[13]倪鹤鹏,刘亚男,张承瑞,等.基于机器视觉的Delta机器人分拣系统算法[J].机器人,2016,38(1):49-55.

[14]李志昂,李少波,白强,等.基于视觉的机器人目标抓取研究[J].组合机床与自动化加工技术,2020(9):108-11.

[15]董大钊,徐冠华,高继良,等.基于机器视觉的机器人装配位姿在线校正算法[J].浙江大学学报(工学版),2021,55(1):145-52.

[16]REDDY B D,KUMAAR A.Indoor mobile robot path planning using QR code[C]//2020 International Conference on Communi‐cation,Computing and Electronics Systems,Berlin:Springer,2020.

[17]TEOH M K,TEO K T,YOONG H P.Numerical computation-based position estimation for QR code object marker:mathemat‐ical model and simulation[J].Computation,2022,10(9):147.

[18]WANG J,OLSON E.AprilTag 2:efficient and robust fiducial de‐tection[C]//2016 IEEE/RSJ International Conference on Intelli‐gent Robots and Systems(IROS),New York:IEEE,2016.

[19]刁世普,秦磊,郑振兴.自主分拣机器人视觉系统的快速标定方法[J].组合机床与自动化加工技术,2020(11):91-93.

关注SCI论文创作发表,寻求SCI论文修改润色、SCI论文代发表等服务支撑,请锁定SCI论文网! 文章出自SCI论文网转载请注明出处:https://www.lunwensci.com/ligonglunwen/61158.html