SCI论文(www.lunwensci.com)

摘要:针对生产出的干辣椒品相不一的问题,提出基于Transformer模型的干辣椒等级分类识别方法。根据干辣椒特征,确定干辣椒等级标准,包括优质干辣椒、合格干辣椒和不合格干辣椒3个等级。制备干辣椒数据集并划分为训练集和测试集。首先结合Vi‐sual Transformer(ViT)网络和分类网络,引入并改进Shifted windows Transformer(Swin Transformer)网络,使用高斯误差线性单元(GELU)做激活函数,使用自适应矩估计(Adam)做优化函数。通过加载在ImageNet数据集训练的权重进行模型初始化,表明迁移学习方式可有效提高模型特征提取能力。通过对比ViT模型和Swin Transformer模型两种模型来训练干辣椒数据集,表明Swin Transformer模型测试准确率较高。实验表明,利用迁移学习的Swin Transformer模型准确率最高,达到95.26%,这为干辣椒等级分拣问题提供了新的解决办法,同时可作为其他果蔬品相识别的参考。

关键字:干辣椒,品质分类,Transformer,迁移学习

Study on Grade Classification Method of Dry Chili Based on Transformer Model

Qiu Xianyan,Guo Shichao※,Wang Junjie

(School of Mechanical Engineering,Hunan University of Technology,Zhuzhou,Hunan 412007,China)

Abstract:In view of the production of dry pepper products inconsistent situation,a classification and recognition method of dry chili based on transformer model was proposed.According to the characteristics of dry chili,the grade standard of dry chili was determined,including high quality dry chili,qualified dry chili and unqualified dry chili.Dry chili dataset was prepared and divided into training set and test set.Firstly,combined with the Visual Transformer(ViT)network and the classification network,then the Shifted windows Transformer(Swin Transformer)network was introduced and improved,using the Gaussian Error Linearity Unit(GELU)as the activation function and the Adaptive Moment Estimation(Adam)as the optimization function.By loading weights trained in Image Net dataset for model initialization,it is concluded that the transfer learning method can effectively improve model feature extraction ability.By comparing ViT model and Swin Transformer model to traindry chilidataset,Swin Transformer model has higher test accuracy.Experimental results show that Swin Transformer model using transfer learning has the highest accuracy,reaching 95.26%,which provides a new solution to the problem ofdry chili grade sorting,and can be used as a reference for other fruits and vegetables.

Key words:dry chili;quality classification;Transformer;transfer learning

0引言

辣椒是茄科辣椒属的重要蔬菜,内含众多营养物质,具有药用价值和食用价值,在我国广泛种植[1]。作为人民必需的餐用调味品,常在市场中以干辣椒、辣椒粉等初级加工品的形式流通[2]。而干辣椒是指将新鲜红辣椒经过人工脱水或自然晾晒等工艺过程而制成的辣椒制品,又称作辣椒干、干制辣椒。但制作干辣椒时,特别是在自然晾晒干制过程中,辣椒皮和肉的红色部分经常褪色,变白色和黄色,形成“花壳”、“白壳”、“花皮”干辣椒[3],花壳干辣椒果皮中的类胡萝卜素的含量较正常红辣椒显著降低[4]。鉴于干辣椒的感官品质和商品价值受到严重影响,需要干辣椒品质分类,但目前对此分类,大多是靠效率低、消耗成本大的人工完成,急需要研制一种操作方便、分类快速、准确率高、大规模自动分选的干辣椒品质分选机器,将花白壳等品质不好的干辣椒挑选出来,利用什么方法在众多的干辣椒当中将其选出是分选机器的关键。

近年来,计算机视觉技术在果蔬质量检测方面应用很广。计算机视觉系统一般由检测箱、光源、CCD摄像头、图像采集卡(帧捕获器或数字化仪)、计算机硬件和软件系统、控制机构等部分组成。电脑硬件和软件系统相互作用,分析水果和蔬菜的外部品质图像,给出了检查对象的最终检测信息,并最终控制整个检测系统完成分级和分类任务[5]。张力超[6]提出一种基于计算机视觉的苹果分类和分级研究方法,通过提取苹果的外部特征,运用Support Vector Machine(SVM)和Convolution Neu‐ral Networks(CNN)方法进行对比,结果表明在有足够的图像数据下,CNN方法在识别苹果种类和单个苹果外观等级的准确率高于SVM方法。文怀兴等[7]提出基于改进深度残差网络的红枣缺陷检测分类方法,在RGB彩色图片中,因G通道在红枣的缺陷部分体现出红枣的正常部位和缺陷部位的反差区别,所以以红枣的G分量作为残差网络的输入,通过神经网络的训练与测试,此分类方法准确率为96.11%。朱幸辉等[8]在卷积神经网络的基础上,利用Single Shot MultiBox Detector(SSD)算法将Region Proposal和分类统一在一起,针对西红柿叶片病斑做出识别仿真,得出的Mean Average Precision(mAP)值为0.988。林雯[9]针对芒果外观品质,提出一种基于计算机视觉和BP神经网络的分类算法,选取芒果的小波特征、颜色特征、形状特征、缺陷面积所占比进行提取,作为BP神经网络的输入,实现的3个等级分类,准确率达到93.3%。余游江等[10]针对新疆红枣在加工过程中需对不同种类区分的问题,构建了Densenet 121、ResNet 50、VGG 16三个种类的卷积神经网络为基础学习器,逻辑回归为次级学习器的Stacking集成学习模型,并进行不同学习器组合的模型对比,结果表明提出的集成模型准确率为92.38%。

对于辣椒的研究,郑凯等[11]针对青椒质量品相问题,提出了利用卷积神经网络方法对其识别分类,通过比较不同的卷积层和优化函数对其准确率的影响,分析出运用3*3卷积核的三层CNN网络模型和Adaptive Moment Estimation(Adam)优化函数在测试分类的准确率最优,准确率达到97.60%。袁开放[12]针对鲜辣椒大小和病残问题,提出基于机器视觉的分类方法,利用最小外接矩形算法识别辣椒的大小,准确率为95%,利用RGB和HIS颜色模型对辣椒病残进行识别并剔除次品。李硕[3]根据干辣椒外观品质国家分级标准,基于机器视觉对干辣椒进行品质分级,对干辣椒图像预处理后,利用最小外接矩形的长宽比鉴定干辣椒是否有柄,有柄为不合格,进一步基于颜色性状差异区分合格干辣椒与不合格干辣椒,实验分级准确率为92.15%。本文针对干辣椒外观品质提出了新的分类方法,研究基于Transformer模型进行干辣椒外观品质分级,并进行同模型间训练是否利用迁移学习对比和不同训练模型的对比,结果表明:利用迁移学习的Shifted windows Transformer(Swin Transformer)模型准确率最高,最稳定。

1数据分析

1.1图像收集

本文收集的图像来自于株洲市本地菜农所卖的干辣椒,当地人称“辣椒王”。收购后干辣椒制备描述如表1所示,在原始辣椒中掺杂着外观品相不一的干辣椒,需用人工把品质相同的干辣椒进行挑选出来,为做图像数据集做准备。本文依据国家对于干辣椒的分级标准[13]和市场需要将其分为3种干辣椒,即优质干辣椒、合格干辣椒、不合格干辣椒。其中不合格干辣椒品质已经破环,严重影响消费者的购买行为。

1.2数据集划分

本文共拍摄2 115张干辣椒,为提高模型的训练量以及泛化能力,利用数据增强技术通过旋转、镜像方法扩增到6 345张图片,此方法增强模型的鲁棒性。数据分为训练集4 445张和测试集1 900张,划分比例为7∶3。其中训练集优质为889张,合格为889张,不合格各小类均为889张;测试集优质为380张,合格为380张,不合格各小类均为380张。利用Python将数据图片像素统一改为224×224。

2模型结构

2.1 Swin Transformer网络模型

Swin Transformer网络起源于Transformer模型,而Transformer模型是谷歌在2017年提出[14],起初针对于自然语言处理领域,利用自注意力机制代替传统处理序列数据时采用的循环神经网络,不仅实现了并行训练,提升了训练的效率,同时也在应用中取得不错的结果。Swin Transformer网络是微软在2021年在ICCV上发表文章[15]中提出,这是Transformer模型在计算机视觉图像分类方面一次大的发展。

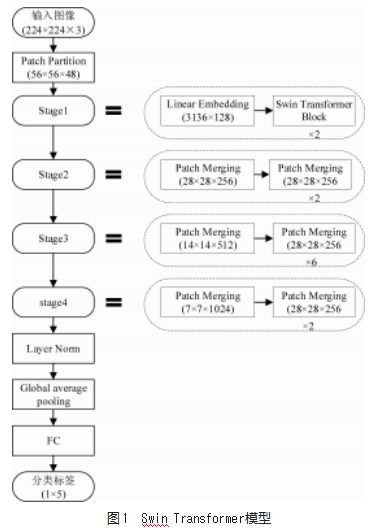

该模型相比之前的VisionTransformer(ViT)[16]做出两个改进:(1)引入卷积神经网络常用的层次化构建方式构建层次化Transformer;(2)引入locality思想,对无重合的windows区域内进行自注意力机制计算,实际表现与ViT模型相比,拥有出色的效果。整体结构如图1所示,输入224×224×3尺寸的干辣椒图像,在Patch Par‐tition阶段,由4×4的滑动窗口将图片划分为56×56×48大小的patch。经过stage1阶段,Linear Embedding对每个像素的channel数据做线性变换,将向量的维度变成一个Transformer可以接受的值,即将shape为(56,56,48)变成(56,56,C),C为超参数,对于Swin-B来说,C为128;接着进入Swin Transformer Block,在模块中,为了减少计算量问题,引入Windows Muti-Head Self-Atten‐tion(W-MSA)模块,为了解决窗口与窗口无法传递信息的问题,引入Shifted Windows Muti-Head Self-Attention(SW-MSA)模块,W-MSA和SW-MSA依次进行,成对出现。在分类部分,依次通过Layer Norm层、全局平均池化层(Global average pooling)、全连接层到分类标签,维度1×5,对应于干辣椒5个分类类别。

2.2激活函数

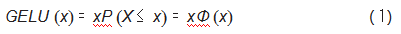

激活函数是神经网络的重要部分,线性神经网络引入激活函数,会引入非线性,增强模型的学习能力。本文使用高斯误差线性单元Gaussian Error Linear Unit(GE‐LU),Dan Hendrycks与Kevin Gimped使用GELU激活函数在MNIST和CIFAR-10/100数据集进行评估,准确性要比ELU和RELU激活函数高,至此可作为激活函数的可

选方案之一。公式如下:

其中,Φ(x)指的x的高斯正态分布的累计分布,该式不能直接计算,近似逼近可表示为:

2.3优化方法

基于梯度下降法的各种改进算法是目前主流的优化方法,其最基本的思想是如果找到某函数的最小值,最好的方法是沿着负梯度方向查寻。公式如式(3)。在数据集上计算梯度进行参数更新,只要学习率足够小,每次更新参数时总能使损失函数变小。

式中:x为参数向量;Ir为学习率;dx为梯度。

Adam近似RMSProp的动量版,加入了迭代衰减因子,采用指数衰减的方法,只对最近的历史梯度信息进行累加。Adam公式如下:t为迭代次数;Ir为学习率;gt为梯度;β1β2为衰减系数,一般用值{0.9,0.99,0.999},取β1=0.9;β2=0.999;ε为小常量,防止除数为0,一般10-8与10-4之间,取10-8;f(x)为参数x下的损失函数;初始化参数x0,t=0,m0=0(一阶矩动量),v0=0(二阶矩动量)。对公式(4)~(10)不断重复,直到xt收敛。本文运用Adam优化方法。具体如下:

3实验分析

3.1评价指标

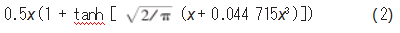

评价模型优劣指标包括准确率Acc(Accuracy)、精确率P(Precision)、召回率R(Recall)等。公式如下:

式中:TP为预测与实际均为正类的样本数量;TN为预测与实际均为负类的样本数量;FP为预测为正类但实际为负类的样本数量;FN为预测为负类但实际为正类的样本数量。

F1-Score为精确率Precision和召回率Recall的调和值,取值范围(0~1),对单个种类越大越可以表达模型的优秀。公式如下:

本模型对每个分类的F1-Score取平均值得到MeanF1-Score。

3.2结果分析

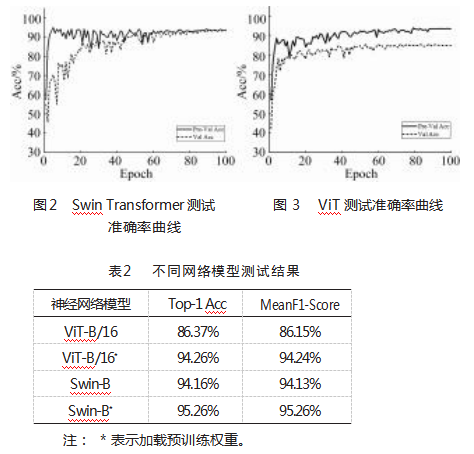

本文针对干辣椒品相分为3个等级,其中不合格又分为3个类别,所以深度学习模型将对干辣椒分拣出5个类别。以Swin Transformer和ViT模型为基础,采用随机初始化学习方式和迁移学习方式在干辣椒数据集上训练并对比;迁移学习所加载的预训练权重在数据集ImageNet1000训练得到,除了全连接层的所有网络进行冻结,保留迁移权重,仅对全连接层训练。模型训练100轮,测试集预测的准确率曲线如图2和图3所示(Pre-Val Acc为运用迁移学习的测试准确率,ValAcc为未用迁移学习的测试准确率),不同情况下测试结果如表2所示。从图中可以看出,采用迁移学习初始化模型比随机初始化模型预测准确率起点更高,特征提取用时更短,且更快达到收敛,收敛性变得更好。这是因为Image数据集与分类任务数据集具有相关性,即在Image训练过的模型可以有效提取干辣椒图像特征,分类效果会更好。表2显示同一模型运用迁移学习方式评估效果会更好,不同模型Swin Transformer模型则比ViT模型测试准确率更高,前者准确率达到95.26%,MesanF1-Score为95.26%。

3.3实验平台

云服务器实验平台参数设置如表3所示。

4结束语

本文利用Transformer模型在图像分类上的优势,通过改进将其应用到干辣椒分类任务,实验结果达到较高的识别准确率,证明方法的有效性。实验通过对比迁移学习初始化权重训练与随机初始化权重训练,证明迁移学习方案可以缩短模型训练时间,模型准确率曲线更快达到收敛,准确率更高,表现正迁移作用;对比改进的Swin Transformer模型与ViT模型,得出Swin Transformer模型特征提取更有效,准确率更高,更稳定,且运用迁移学习方式的Swin Transformer模型测试准确率为95.26%,可作为辣椒分类算法参考。

本数据集的干辣椒图像大部分取样可为其他辣椒检测或识别任务进一步扩充数据集,也可继续优化该模型,并将该模型运用到其他果蔬分拣方面。

参考文献:

[1]刘超.中国加工辣椒产业现状及发展前景分析[J].食品安全导刊,2018(21):55.

[2]石熙明(SEOKHEEMYUNG).中国调味蔬菜出口韩国贸易研究—以辣椒为例[D].咸阳:西北农林科技大学,2015.

[3]李硕.基于机器视觉的干辣椒分级研究[D].保定:河北农业大学,2019.

[4]余清清.花壳干辣椒和正常干辣椒的类胡萝卜素组成及其非靶向代谢组学分析研究[D].重庆:西南大学,2020.

[5]罗雪宁,倪明航,彭云发,等.浅谈计算机视觉技术在果蔬外观品质检测中的应用[J].新疆农机化,2014(4):14-17.

[6]张力超.基于机器视觉的苹果分拣关键技术研究[D].石河子:石河子大学,2018.

[7]文怀兴,王俊杰,韩昉.基于改进残差网络的红枣缺陷检测分类方法研究[J].食品与机械,2020,36(1):161-165.

[8]朱幸辉,周勇.基于卷积神经网络的番茄叶片病斑识别仿真[J].计算机仿真,2021,38(7):481-485.

[9]林雯.基于计算机视觉和神经网络的芒果外观等级分类研究[J].安徽农业科学,2010,38(23):12703-12705.

[10]余游江,喻彩丽,尚远航,等.基于Stacking模型的红枣品种分类识别[J].北方园艺,2022(8):139-148.

[11]郑凯,方春,孙福振.基于深度学习的青椒质量分类[J].山东理工大学学报(自然科学版),2020,34(4):18-23.

[12]袁开放.基于机器视觉的辣椒等级分选研究[D].长沙:湖南农业大学,2016.

[13]GB 10465-1989,辣椒干[S].

[14]Vaswani A,Shazeer N,Parmar N,et al.Attention is all you need[C]//Proceedings of the Advances in neural information process‐ing systems.Long Beach:Curran Associates,2017:5998-6008.

[15]Liu Z,Lin Y,Cao Y,et al.Swin transformer:Hierarchical vision transformer using shifted windows[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision.Piscataway:IEEE,2021:10012-10022.

[16]Dosovitskiy A,Beyer L,Kolesnikov A,et al.An image is worth 16×16 words:transform-ers for image recognition at scale[EB/OL].[2022-8-16]]https://arxiv.org/abs/2010.11929.

关注SCI论文创作发表,寻求SCI论文修改润色、SCI论文代发表等服务支撑,请锁定SCI论文网!

文章出自SCI论文网转载请注明出处:https://www.lunwensci.com/ligonglunwen/58736.html