SCI论文(www.lunwensci.com)

摘要:工件识别是机器人操作中必不可少的重要技术之一。提出了一种基于角点检测的工件类型识别策略,为机器人操作提供了重要的视觉线索。首先,根据工件的封闭区域(被边缘包围),采用多尺度卷积神经网络检测工件的边界盒;其次,利用简单的神经网络检测出Y型、A型和L型3种类型的角点,并根据检测概率和角点之间的几何关系进一步细化检测结果;最后,根据角的相对位置识别工件的类型。工件检测步骤大大减少了角点检测的搜索空间,实现了过程的实时性。该方法的另一个重要特点是检测到的角点可以进一步作为重建工件三维结构的基本建模元素,这有利于机器人确定抓取位置和姿态。在PKU-HR6.0平台上,建立了基于该方法的操作控制器。实验结果表明,PKU-HR6.0机器人能够准确地识别和定位俄罗斯方块,能够很好地完成操作任务。

关键词:角点检测;工件识别;机器人抓取

Research on Robot Recognition System Based on Corner Detection

Liu Yuantao1,Cui Yafei2,Yang Haineng1

(1.Shaoyang Vocational and Technical College,Shaoyang,Hunan 422000,China;2.Yongzhou Vocational and Technical College,Yongzhou,Hunan 425100,China)

Abstract:Product identification is one of the most important technologies required for robotics.A product type recognition strategy was proposed based on corner point detection that provided important visual cues for robot manipulation.First,according to closed jobs(surrounded by edges),detected jobs using a multidimensional convolutional neural network.Secondly,using a simple neural network to detect corner points of type Y,type A and type L and further refined the results on the geometric relationship between the detection probability and the corner point.Finally,the product type was determined by the relative position of the corner.With the product discovery steps significantly reducing the search space at the corner points,the process reaches real time.Another important feature of the approach is that the detected corner points can be additionally used as basic modeling elements to reconstruct the 3D structure of products,which will help robots determine the location and location of the gripper in PKU-HR6.0 platform has an operational controller based on the method.The results of the experiment show that the method of determining the accuracy corresponds to the modern work of PKU-HR6.0,the robot can accurately recognize and localize the Russian square to perform operational tasks well.

Key words:corner detection;workpiece recognition;robot grasping

0引言

抓取是机器人为人类社会服务的基本技能之一。事实上,工业机器人现在很擅长在结构化和不可改变的环境中进行操作,但在现实世界的任务中,它们仍然不够熟练,无法成功地适应复杂和不稳定的情况。在引导机器人运动的各种感官信息中,视觉线索是最常用的一种,可以为机器人的运动决策提供丰富的支持。对于乐高积木、俄罗斯方块等操作任务,工件类型的识别是帮助机器人做出运动决策的第一步基本步骤。在本文中,主要研究如何通过视觉线索实时识别4种俄罗斯方块形状的工件,另外,本文不处理其他形状的物体,如瓶子或玩具枪。

由于物体识别是机器人技术和计算机视觉领域的热点问题,人们进行了大量的工作并取得了许多成功。有些作品使用了之前获取的对象模型,如SIFT[1],特征图[2],可变模型[3],但这些作品只有在模型已知的情况下才能很好地完成。Ckermann[4]提出了一种自底向上分割和自顶向下分类相结合的分层方法,但只有在合适的聚类规则下才有效。GoogleNet[5]和AlexNet[6]在类别识别方面表现良好,但在类内识别方面不够好。事实上,工件的三维位置和方向重构对于机器人来说也是至关重要的,它可以帮助机器人决定如何抓取或放置目标工件。对于物体的三维重建,传统的方法是利用多幅图像将问题作为深度预测。Kresse等[7]提出了RGB-D方法来获取位置、方向等几何特征来诊断不同的工具,但在光线太强的情况下可能无法获得深度信息。一些作品利用几何假设,如形状从阴影[8]和重复结构[9]。然而,识别和重建一直被视为单独的程序。认知心理学研究表明,人类从多视角观察物体,视轮廓和角点为基本单元对物体形状进行分类,三维结构的重建也是基于基本单元[10]。

受人类视觉机制研究成果的启发,本文提出了基于角点检测的工件类型识别方法,并将检测到的角点作为重建工件三维结构的基本单元。基于角点检测的解决方案将工件的识别和重构内在地统一在一个框架内,提高了工作效率,而人性化的机构启发方式有助于提高系统的有效性。为了提高角点检测的效率,首先从背景中提取出候选工件,然后对裁剪后的工件区域进行角点检测,称为目标检测。目前的目标检测方法已经能够用于单个图像,如Fast R-CNN[11],Faster R-CNN[12]和YOLO[13]等。但这些方法需要大量的训练数据,不具有实际应用价值。本文使用基本单元的解决方案也可以用于目标检测,从而避免了大量训练数据的收集。为了对工件进行识别,并进一步重构机器人操作所需的三维结构,该方法可分为3个步骤:首先,为了提高检测效率,从机器人的视线中裁剪候选工件;然后对每个候选点进行角检测;最后,根据检测到的角点识别出候选目标的形状并锁定目标。此外,检测到的角点作为工件三维重建的基本建模单元。在本文中,提出了一种基于角点检测的高效、精确的机器人操作工件识别框架。以俄罗斯方块的识别为例,在PKU-HR6.0机器人上实现。

1角点检测

在本节中,将讨论如何检测角,并改进结果,以识别不同种类的长方体。

1.1角分类器

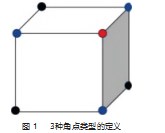

将长方体的角分为3种,如图1所示。首先,本文设计了一个角分类器来检测三种角。由于角是由边引起的一种简单的低级特征,本文使用一个简洁的CNN模型-LeNet来检测不同种类的角。仿真和真实摄像机数据提供训练和验证。网络的输入是角的图像,大小为30×30,和LeNet一样,本文有两个卷积层和两个子采样层。本文将输出设计为4个分类问题,输出Y角、A角和L角等的概率。该网络简洁,检测周期短,但仍能达到相当的性能。该网络的细节将在实验中讨论。

1.2几何关系精炼

由于角是噪声敏感的特征,一些其他的物体也会被当作目标,比如桌子的角或者一些由轮廓引起的噪声。为了处理这些噪声,本文提供了一些方法来获得真正的目标。

(1)背景噪声:一些噪声来自长方体以外的区域,很容易被检测为一个角落,来自一些外部因素,如照明。在本文工作中,这些区域被定义为背景噪声。

(2)拉长的噪声:角是由边缘引起的。由于本文使用图像的默认大小作为训练数据,边缘的某些部分不可避免地会被视为角。区域被拉长,这被定义为拉长的噪声。

(3)错误:由于3类角点的特征相似(由边缘引起),神经网络的结果可能会被误检。经过非最大抑制后,误检区域被认为是错误区域。神经网络的输出只是这个输入图像块的一个检测类,本文假设每个图像块的类等于它的中心像素。因此,本文获得了每个像素的标签映射,并带有该类的分类结果和概率。利用被检测为角点的像素,将它们聚成一个在同一类中的连通域。计算每个域的像素数后,如果一些小的域在阈值以下,则对其进行滤波。在这一步之后,本文可以有效地过滤背景噪声。

利用滑动窗口判断当前窗口的像素数是否在阈值以下,从而对拉长域进行去噪。如果该窗口域的面积在阈值以下,则可判断该域为延长域。大多数边缘的拉长噪声都是通过这个步骤过滤掉的。背景和拉长的噪声很容易被过滤掉,但仍然存在一些错误会误导本文识别。为了优化结果,本文设计了一个评分系统,通过计算被检测到的角落组成的立方体的置信度。本文方法分为以下两个步骤。

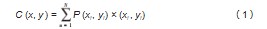

步骤1:在A部分中,神经网络的输出包含了每一个像素在4类中的概率,称为概率中心。将几何质心和概率质心结合起来作为每个角域的中心。质心的计算方法为:

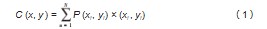

式中:P为点i的位置为(xi,yi)的概率;C(x,y)为质心的位置。

步骤2:得到每个角域的质心后,将它们连线。第二节的输出是灰度图像,每个像素的值表示边缘响应。值越大,表示成为角或边的可能性越大。

2工件识别

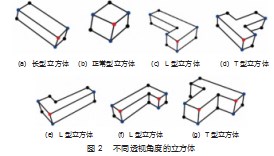

在本文以4种类型的工件为例,图2所示为4种长方体从机器人的不同角度,它们的角被检测。本文可以将不同的长方体从这些情况按一些学科分类。可以根据角的几何关系来识别不同的立方体。根据第二节的结果,Y型和A型角比L型角更精确,因为3条边包含了更多的特征。所以本文只需利用这两种类型的角来识别立方体。

如图2所示,只有(f)和(g)包含两个Y-type角。所以本文可以用这个特征来区分这两个。对于(f)和(g),两个Y型角与type型角连接。它们的区别是A型角,与Y型角连接,Y型角在最左边和最右边。如果两者连接同一个L型角,如(f),则视该立方体为L型立方体,另一个为T型立方体。该方法在前视图上识别T型和L型正方体。对于只有一个Y型角的情况,本文有5个类别需要区分。在这种情况下,本文有两个分支:在(a)和(b)中,只包含三个A型角与Y型角相连接的立方体可以看作是长形立方体和正形立方体,并得出后视图的L型立方体。为了区分L型立方体为(e),本文利用中间位置的L型角,如“v”,如果两个L型角与它相连,则判断该立方体为L型。本文可以使用A型角和Y型角之间的线的方向无线电来区分。超过1.0时,多维数据集被确定为一个Long-type立方体(a),否则,立方体是正常的(b)。等多维数据集(c)和(d),有一个角落A类型相比(a)和(b)。识别(c)和(d),本文可以利用连通性A类型的角落,不区分与引水角落。如果A-type与两个L型角相连,两个L型角又与另一个A型角相连,则侧面视该立方体为L型立方体,背面视该立方体为T型立方体。

通过使用上述原则,本文可以很容易地识别多维数据集,这很容易通过一些决策判断来实现。该方法比其他使用神经网络进行分类的方法更有效。

3实验过程

3.1角点检测

对于角点检测网络的训练,本文使用了155 202幅仿真数据图像和37 478幅真实摄像机数据图像。首先,利用仿真数据对网络进行训练。其次,本文使用相机图像来微调模型。另外,将RGB图像转换为灰度图像,以排除颜色信息。

由于角点检测的结果对三维重建和机器人操作都是非常有效的,本文通过平衡的评分来评估机器人操作任务,通过本文工作来评估角点检测的精度和召回率。本文在每个角落都贴上了两种尺寸的真实区域,9×9尺寸的图像是相对严格的,15×15尺寸的图像是相对宽松的。真正的阳性是那些被检测到的角落落入标记的区域。本文计算所有类型的角,结果显示在表1中。在角点检测的结果中,可以看到本文工作已经足够精确,可以进行三维重建。

3.2立方体识别

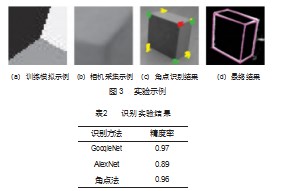

为了评估本文方法在立方体识别方面的性能,有两种最先进的对象识别方法,即AlexNet和GoogleNet。本实验数据集包含10 147幅图像,其中9 018幅图像为训练集,1 002幅图像为验证集,127幅图像为测试集。图像分为T型、L型、正立方和噪声5类。

GooleNet和AlexNet的输入图像大小为480×640,本文使用caffemodel,打开caffemodel来微调本文网络。两者的学习速率都是0.000 1。对于本文方法,为了排除颜色信息,本文将RGB图像转换为灰度图像。本文使用仿真数据和相机数据训练本文角分类器,如图3(a)和(b)所示。细化的结果如图3(c)所示。使用角点信息和本文对不同类型工件的纪律,本文在识别方面取得了相当的性能。利用Ms-CNN的结果,本文对组成进行评估并对其进行排序,如图3(d)所示。本文比较了每个作品的准确性、召回率和参数。实验结果如表2所示。从表中可以看出,本文方法与GoogleNet的准确率水平相同,但在训练上更容易,因为GoogleNet是一个深度网络,包含更多的计算。而且,本文方法比AlexNet更好。

3.3工件抓取

利用所提出的工件识别方法以及基于该方法提供的基本建模元素的三维重建结果,在PKU-HR6.0平台上建立了机器人操作控制器。PKU-HR6.0是本实验室设计开发的第六代儿童型仿人机器人(质量3.93 kg,高59.50 cm)。它有24个自由度(DOFs)由Dynamixel RX-28和RX-64伺服驱动器驱动,并配备了英特尔RealSense SR300深度相机和3轴惯性测量单元。一个英特尔迷你PC NUC 5I7RYH(2核,4线程)作为中央控制器。它在Ubuntu 14.04 LTS和机器人操作系统Indigo上工作。每只手臂有4个移动DOF和一个抓取DOF。

图4给出了整个操作过程的一个例子。首先,机器人将注意力集中在其左侧的4个候选对象上,并被告知寻找T形块,在T形块中使用本文工件识别方法。找到目标后,根据检测到的角点计算出目标的三维位置和方向。该机器人利用其先前开发的内部模型来控制其手臂来驱动手拿起目标。然后机器人将目标放在其右侧的凹槽上。实验结果表明,基于对俄罗斯方块的精确识别和定位,该机器人能够成功地完成操作任务。

4结束语

在本文中,本文提出了一种高效的机器人操作工件识别和三维重建方法,包括使用多尺度卷积神经网络检测立方体,使用简单的卷积神经网络检测角点,对不同的立方体进行形状识别,以及使用基本建模元素进行三维重建。在此框架下,本文在识别和提供基本的三维重建建模单元方面都取得了很好的效果。根据实验结果,本文形状识别方法与目前最先进的工作,如GoogleNet和AlexNet处于同一水平。同时,该算法也能满足机器人在线实时操作的要求。在未来的研究中,可以对该研究进行两个扩展。一个是探索技术,以进一步提高本文方法的准确性。另一个将是研究涉及更复杂的立方体形状的情况。

参考文献:

[1]E Kuzmic,A Ude.Object segmentation and learning through fea⁃ture grouping and manipulation[C]//Ieee-Ras International Con⁃ference on Humanoid Robots,2011.

[2]R B Rusu,G Bradski,R Thibaux,et al.Fast 3d recognition and pose using the viewpoint feature histogram[Z].2010:2155-2162.

[3]W Wang,S Chen,L Chen,et al.A Machine Vision Based Automat⁃ic Optical Inspection System for Measuring Drilling Quality of Printed Circuit Boards[C]//IEEE Access,2017.

[4]A ckermann,C Eibrechter,R Haschke,et al.Real-time hierarchi⁃cal scene segmentation and classification[C]//Ieee-Ras Interna⁃tional Conference on Humanoid Robots,2015.

[5]C Szegedy,W Liu,Y Jia,et al.Going deeper with convolutions[Z].2015:1-9.

[6]A Krizhevsky,I Sutskever,G E Hinton.Imagenet classification with deep convolutional neural networks[J].Advances in Neural Information Processing Systems,2012(25).

[7]I Kresse,U Klank,M Beetz.Multimodal autonomous tool analyses and appropriate application[C]//Humanoid Robots(Humanoids),2011 11th IEEE-RAS International Conference on,2011.

[8]崔亚飞.基于激光扫描的膨胀节三维重构算法研究[D].南京:南京林业大学,2018.

[9]王海云,王剑平,罗付华.融合多层次特征Faster R-CNN的金属板带材表面缺陷检测研究[J].机械科学与技术,2021,40(2):262-269.

[10]彭雨,谈莉斌,余晓流.基于机器视觉的细长产品表面缺陷检测设备研究[J].机械制造与自动化,2021,50(4):166-169.

[11]解思瑶.基于机器视觉的汽车外覆盖件检测与定位研究[D].长春:长春理工大学,2019.

[12]金亦挺.基于双目视觉的角点检测与匹配研究及其在涂胶机器人中的应用[D].杭州:浙江工业大学,2012.

[13]庞鹤强.基于角点检测与图像匹配的机器人示教路径修正算法研究[D].扬州:扬州大学,2012.

关注SCI论文创作发表,寻求SCI论文修改润色、SCI论文代发表等服务支撑,请锁定SCI论文网!

文章出自SCI论文网转载请注明出处:https://www.lunwensci.com/ligonglunwen/51706.html