SCI论文(www.lunwensci.com)

摘要:在目前的高校教育制度下,我国的教育事业蓬勃发展,但是在学生课堂早退违纪问题的处理中仍存在不足之处,由于早退学生的过多遮挡以及背景环境较高的复杂程度,因此在识别学生的身份时很难同时兼顾速度和准确性。针对该问题,基于显著性目标检测U2Net网络和多重损失的GaitSet模型,结合步态识别相关技术,设计和实现了针对于高校课堂早退学生身份识别的系统DGRSML,为有效解决高校学生课堂早退违纪现象的身份识别问题提供了帮助。

关键词:复杂场景;多重损失;课堂早退;步态识别;GaitSet;U2Net

Realization of Gait Recognition System with Multiple Losses in Complex Scenes

LI Changping,YU Dahai,GUO Hao,LI Jie,HU Bin

(College of Computer Science and Technology,Guizhou University,Guiyang Guizhou 550000)

【Abstract】:Under the present university education system,our education enterprise has been developing vigorously,but there are still some shortcomings in the process of the problem of early class leave disciplinary problems,because of the excessive cover of early students and the complexity of the environment,can not quickly and accurately identify the identity of the students.To solve this problem,based on significant object detection U2Net network and multiple loss GaitSet model,combined with gait recognition technology,the identification system for college students who leave class early is designed and implemented,which provides help to effectively solve the discipline problem of college students who leave class early.

【Key words】:complex scene;multiple losses;class leaves early;gait recognition;GaitSet;U2Net

0引言

课堂早退是高校学生中一种常见的课堂违纪行为,其是指学生未到下课或放学时间擅自离开课堂。该违纪现象的产生极易扰乱课堂纪律,严重影响师生教学进度。伴随着智能监控技术的发展,它已经初步具有代替人眼对目标进行检测和跟踪的部分功能,各大高校也基本实现了监控系统的全面覆盖,但这种传统的方式仅依靠视频中的人脸进行身份识别,而早退学生常通过遮挡来掩盖自己的身份,同时走廊环境较为多变,进而产生目标检测难度大和特征提取不充分的问题,使得传统的人脸识别[1]方法检测精度低,误检率高。因此,对课堂早退场景下学生的自动检测与身份识别是维护高校正常课堂教学秩序中亟待解决的一个关键问题,同时也成为计算机视觉、图像序列处理、人工智能等领域的一大难题。

伴随着智能监控技术的发展,人工智能、计算机视觉已在基于视频监控的行人目标检测、身份识别等领域得到了成功的应用。近年来,一种新的依据行人生物特征进行身份识别的技术,即步态识别已被提出。相比传统的行人身份识别技术,它不需人脸识别,同时可以在远距离和行人伪装情况下较好地识别目标身份,因此它在非接触式的行人身份识别领域具有较大优势[2]。尽管目前国内外已有相关研究人员提出了基于步态特征构建的行人身份识别方法并取得了一些初步应用,然而,针对高校课堂早退违纪学生的行人目标检测与身份识别问题的研究与工程应用尚未开展。因此,基于人体运动力学理论来探究复杂场景下多重损失的深度步态识别系统是一个值得研究的科学问题。

本文基于人体运动特性、借助深度机器学习和神经网络算法,深入研究了特定复杂场景下的行人步态识别问题,主要贡献如下:(1)原创性地提出一套复杂场景下多重损失的深度步态识别系统(Deep Gait Recognition System With Multiple Losses,DGRSML),用以检测视频监控中的课堂早退学生的身份;(2)DGRSML从计算机视觉的角度进一步展现了人体运动生理学以及多重损失模型在步态识别领域的应用;(3)基于不同场景下课堂走廊监控视频,对提出的系统进行一系列实验,验证了DGRSML的性能特性。

1相关工作

1.1传统的步态识别模型

近年来,研究人员对于复杂场景下的步态识别问题,开展了探索性工作并提出相应的算法和模型。例如,Niyogi等首次使用步态来对人的身份进行识别,提出了步态时空模式以确定边界轮廓的方法,在单人识别上取得了初步成功的尝试;Wren等利用单高斯分布近似表示图像像素值分布,建立了单高斯背景模型[3],适用于固定背景下的目标检测;Stauffer等提出高斯混合模型法[4],对场景的变化具有一定鲁棒性;Bouchrika等[5]通过模型法研究了多因素共同作用下的步态识别;Lishani等[6]基于MLBP和Gabor滤波器组的两种特征提取方法,能提取多尺度下的步态特征,但对步态序列的完整性有较高要求。Chao等[7]提出了GaitSet模型用以提取行人步态特征,该模型具有时序无关性特点,在复杂场景下有一定的检测准确率,但检测精度仍无法满足实际需要。Qin等[8]设计了用以进行目标检测的深度网络架构U2-Net,融合多层次深层特征集成方法和多尺度特征提取方法,能有效检测复杂场景下的目标。

总而言之,研究工作者提出的传统方法均对输入数据集的时空序列有较高要求,然而,随着监控位置、光线和遮挡等多种外界因素导致场景的变化,实际情况下无法清晰准确地捕捉到行人完整的步态序列并进行精准识别,复杂场景下的行人对象不仅不适用基于背景模型的目标检测方法,而且不适用传统的完整步态序列进行特征表征,其所处场景的复杂性,使得现有的步态识别系统极易在目标检测阶段过多损失图像分辨率,造成行人身份误检率的上升。直至U2Net网络和GaitSet模型的提出,分别解决了复杂场景下目标检测困难和步态序列缺失两大问题。因此,我们考虑采用U2Net网络和GaitSet模型相结合的方法,分别用于复杂场景下目标检测和步态特征的提取。

1.2复杂场景身份识别

复杂场景下目标检测和特征提取一直是步态识别领域探讨的关键问题。在目标检测领域,传统的目标检测网络专注于提取主体的深层特征,往往忽略了局部细节和全局对比信息。针对课堂早退学生身份识别的场景,走廊监控中捕捉到的多为学生个体,因此在目标检测过程中重点不是在于语义的分析,而是在于根据全局对比信息更好地分割出行人步态轮廓。所以我们首次将U2Net网络应用于该场景下步态识别系统的目标检测,该方法在保留较高分辨率便于图像分割的同时,也提取到了图像各尺度下的不同特征,有利于提高后期步态识别的准确率。在特征提取领域,传统的步态识别模型要求步态序列必须按时间顺序依次输入,但实际的走廊场景中,因监控安装较为分散,很难获取到行人完整的步态序列,同时早退学生会在走廊行走过程中发生穿着外衣或背上背包等一系列行为,造成其行走姿态的改变。因此我们首次将GaitSet模型应用于课堂早退场景下的身份识别中,该模型对输入的步态轮廓图的个数、行走状态和拍摄角度等要求较低,适用于课堂早退学生的身份识别场景。

1.3多重损失机理

多重损失函数长期以来是机器学习的研究热点之一。在对它的研究探索过程中,科学家初步定义了多种损失函数,包括均方误差损失函数(MSE)、Huber损失函数、Softmax损失函数、Triplet损失函数等,用来表征预测值f(x)与真实值Y的差距,通常损失函数越小,模型的鲁棒性就越好。传统的步态识别系统的分类识别过程是基于数据上的距离度量开展的,采用的是Triplet损失函数,它仅关注了输入样本的类内距离小于类间距离,但忽视了类内和类间的相似性,会导致识别结果出现偏差。本文提出的DGRSML在步态序列的分类过程同时考虑了类内和类间距离,采用增强约束的三元组损失函数联合加速网络收敛的Softmax Loss。系统实际应用结果表明,多重损失函数的引入可以有效提高复杂场景下目标检测和识别的准确率。

2模型设计与实现

复杂场景下存在目标检测困难和步态序列缺失两大问题,可通过结合U2Net网络和GaitSet模型的方法有效解决该问题。U2Net网络检测时对图像高分辨率的保留特性,为后期GaitSet模型提取更高精度的步态特征信息提供了前提条件。同时GaitSet模型时序无关性的特点更好的弥补了步态序列缺失的问题。另外,多重损失机理的引入为步态识别准确率地提升奠定了基础。因此,本文基于复杂场景下人体运动特性,借助U2Net网络和多重损失的GaitSet模型,构建出一套适用于复杂场景下行人目标检测和识别的系统,即DGRSML。

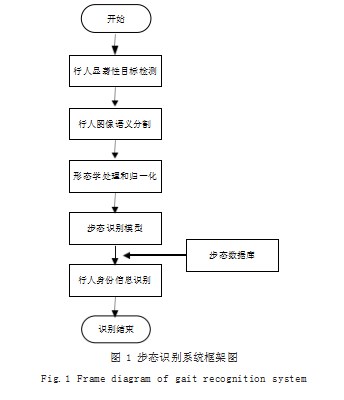

DGRSML将监控设备拍摄的步态视频进行帧提取并输入U2Net中,经过网络的显著性检测后输出步态序列轮廓图,然后进行一系列形态学处理去除噪声,再将处理后的图片输入到多重损失的GaitSet模型中,利用CNN网络提取各通道步态轮廓图的特征,同时在不同层上应用集合池化操作得到集合级别特征,然后聚合多幅步态轮廓图的特征,最终输出单个特征向量。基于上述方法构建起学生的步态特征数据库,存储各学生的步态特征向量及其相应身份信息。最后进行学生身份识别,将提取到的学生步态特征向量与数据库中进行欧式距离的计算,如果欧氏距离小于阈值,则可检索并识别出学生身份。本文提出的复杂场景下多重损失的深度步态识别系统结构如图1所示。图1中,DGRSML由目标检测、语义分割、形态学处理和归一化、多重损失的GaitSet模型和身份识别五大模块组成。系统的详细设计如下所述。

2.1显著性目标检测和语义分割

该模块主要是对行人进行目标检测并通过U2Net网络对行人RGB图像进行语义分割,最终获取到步态轮廓图。通常情况下,监控捕捉到的视频由大量的帧组成,且相邻时刻的帧在步态特征上差异较小,因此首先采用聚类的方法对视频进行关键帧的提取。提取过程中首先假设一段行人步态视频Si包含n个图像帧,表示为Si={Fi1,Fi1,…,Fin},其中Fi1为首帧,Fin为尾帧,另外用相邻两帧图像间直方图的差别来衡量图像之间的相似程度,同时用变量6表示聚类的程度。若与所有现存的聚类质心间的帧间相似度小于6,则说明该帧不能加入该聚类,若相似度均小于6,则当前帧Fii形成一个新聚类,否则将其加入相似度最大的聚类中。最后选取每个聚类中熵最大的图像帧构成该步态视频的关键帧。

接下来是对从步态视频中提取到的关键帧进行行人检测和分割,传统的网络架构采用一系列的下采样减小Feature Map的分辨率,从而降低计算复杂度。然而针对课堂早退学生情景下的分割任务而言,得到具有高分辨率的特征图也是一个关键步骤,因此选择利用U2Net网络边缘特征提取的优势实现步态轮廓图的提取,方便步态识别模型提取到更高精度的图像特征。U2Net通过使用嵌套的残差网络(RSU)在不降低Feature Map分辨率的情况下提取到图像深层和浅层等各个尺度下的特征,即RSU权重层为Unet。U2Net的损失函数值是由6个Block的输出结果与特征融合后的输出结果叠加在一起构成的,相应的公式如式(1)所示:

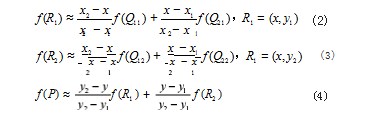

U2Net网络下采样实现输入图像到特征图的转换,采取的是最大池化的方式进行特征提取,虽然会损失一部分图像特征,但是极大地降低了U2Net训练的参数数量,提高了计算速度,同时增强了提取到的步态特征的鲁棒性。上采样将特征图还原成预测图像,采用的是双线性插值的方式将特征图还原到输入图的尺寸并拼接,进而实现抽象特征还原放大。计算方法为已知函数f在Q11=(x1,y1)、Q12=(x1,y2)、Q21=(x2,y1)和Q22=(x2,y2)4个点的值,然后分别进行横纵轴坐标方向的插值得到如式(2)、式(3)、式(4)所示:

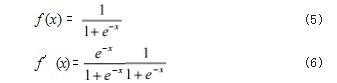

最后通过一个1×1的卷积层得到融合后的步态轮廓图。该层的作用在于降低参数的数目。第一个1×1的卷积把通道从256维降低到64维,最后通过1×1卷积恢复,所使用的总的参数数量为69632,而传统方式下就是两个3×3×256的卷积,参数数量为3×3×256×256×2=1179648。由此可见,1×1的卷积层极大地降低了计算量。同时该层引入了非线性的Sigmoid函数用来表达图像中的复杂特征。Sigmoid的计算公式及求导公式如式(5)、式(6)所示:

因此,f'(x)=f(x)(1-f(x))。由上述公式可知,该函数求导后的表达式可用自身表示,因此计算简便且节省时间。同时该函数的值域取值范围在0-1之间,进而与概率值的范围一一对应,因此通过Sigmoid函数的映射,可最终得到融合后的预测概率图。

2.2形态学处理和归一化

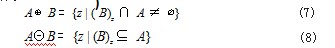

在监控视频中往往由于环境的影响,导致提取到的步态轮廓图存在偏差,会出现噪声、空洞等现象。为提高获取到的步态轮廓图的清晰程度,我们采用闭运算和开运算的方法用于孔洞的填充和噪声点的去除。首先,我们将膨胀和腐蚀的运算过程依次表示如式(7)、式(8)所示:

在形态学中,开运算A·B指A被B腐蚀后再用B膨胀得到的结果,它可用于去掉细小的突起部分,达到去除图像中噪声点的作用。闭运算与开运算相反,闭运算定义A·B指A被B膨胀后再用B腐蚀得到的结果,它可用于平滑图像中的凹陷部分,同时还可用来填充一些细小的孔洞。经过上述基本处理后,有利于后续的识别任务,能够抓住目标步态的本质特征。

但是,由于监控捕捉到的视频中背景和学生比例大小不一,且学生所占图像比例很小,背景的冗余不仅会增大计算量而且会干扰模型的训练。为更好地处理图像中的比例问题,我们将现在的图像再统一进行一次归一化处理,使得处理后的图像中学生轮廓图的大小和行人目标位置尽量保持一致。归一化的过程如下:首先依据每行元素和不为0的原则,寻找上下切割边界;然后改变切割后图像的矩阵大小,高度为64,宽度保持比例;再对中心线左右各32像素处进行切割;最后得到归一化后大小为64×64的轮廓图。

2.3步态识别模型

2.3.1 GaitSet模型搭建

传统的步态识别模型对于输入的步态序列有较高的时序要求,考虑到走廊环境复杂且有遮挡存在,这会造成捕捉到的步态序列不完整,因此,我们选用GaitSet模型进行行人目标的特征提取,该模型具有时序无关性,可接受任意时序个数的步态序列的输入,输出一个融合局部和全局信息的步态特征向量。步态识别模型整体识别过程可以作如下定义,如式(9)、式(10)所示:

上述公式中,N表示行人个数即类别个数;yi表示第i个类别的标签;每个行人的步态特征均具有各自的分布P;x表示第i个行人的j张图像;F表示卷积神经网络;G表示排列不相关函数;H表示学习可区分的特征向量p。

GaitSet模型由SP、HPM和HPP三大模块组成。因为浅层特征图中的像素集中在一些局部的图像特征信息上,而较深层特征图中的像素集中在更全局和粗粒度的信息上,因此,GaitSet通过在不同层上应用SP(Set Pooling)操作将帧级别特征V映射到集合级别特征Z,若Π表示全局的最大、平均和中间值操作的任意组合,则SP集合池化操作的定义如式(11)、式(12)、式(13)所示:

模型中的HPP(Horizontal Pyramid Pooling)操作通过Global Max Pooling和Global Average Pooling将Height和Width维度压缩为一个维度的尺度信息,帮助网络处理各个尺度的特征,如式(14)所示:

整个网络的最后部分是表示特征向量的HPM模块,该模块将提取到的图像时空特征进行Fatten操作,进而转换成一维特征向量,为后期的分类提供前提条件。

2.3.2 GaitSet模型训练

在GaitSet的训练过程中,考虑到仅仅在训练集上评估模型是不够的,在未观测数据集上检验模型的泛化能力才是最好的方法,因此对数据集采用受试者无关协议,选取前74位学生的步态轮廓集作为训练集进行模型训练,其余50位学生进行测试,然后将测试的学生数据进一步划分为注册集和验证集两部分,注册集包含学生在正常状态下行走的前4个步态序列(即NM-1,NM-2,NM-3,NM-4),验证集包含学生NM、CL和BG三种行走状态下的序列各2个。在GaitSet模型训练和测试的过程中,遍历8000次训练集,在每遍历一次训练集后会在验证集上进行验证,同时输出相应损失值与准确率。在每次迭代训练后,Loss值逐渐减小。为寻找损失函数的最低点,我们采用梯度下降的方法来进一步求解,假设wi表示权重的初始值,wi+1表示更新后的权重值,α表示学习率,则得到如式(15)所示:

重复多次计算上式,直至损失函数值收敛不变,从而得到目前最优的模型参数值,模型训练结束。

2.3.3多重损失的改进

由于输入的步态序列在时序、行走状态等方面会出现多种变化,所以做到同类别样本映射出来的特征聚集在一起,而不同类别的样本映射出来的特征相互远离显得尤其重要。为保证训练的模型能更加准确的对该场景下的学生步态进行识别,我们对模型的Loss做了改进。传统的Softmax作为损失函数进行分类时,学生会被划分为不同的类别,但是无法增进学生个体间的关联程度,这就会导致系统在进行步态识别过程中,不能满足对提取步态特征精细程度的要求。本文通过引入度量学习中的三元组损失函数构建多重损失训练网络来解决上述问题。

三元组结构可表示为(Iia,Iip,Iin),分别对应输入的3个步态序列,Iia表示基准样本,Iip表示正样本,Iin表示负样本,其中正负样本代表着标签是否相同。三元组经卷积神经网络映射到特征空间表示为(ϕw(Iia),ϕw(Iip),ϕw(Iin))。假设ε1为阈值(Margin),是一个大于0的超参,目的是使基准样本与正样本的距离比基准样本到负样本的距离要不大于这个阈值α,D(ϕw(Iia),ϕw(Iip))表示基准样本和正样本的归一化后的欧氏距离,因此三元组损失函数可表示为如式(16)所示:

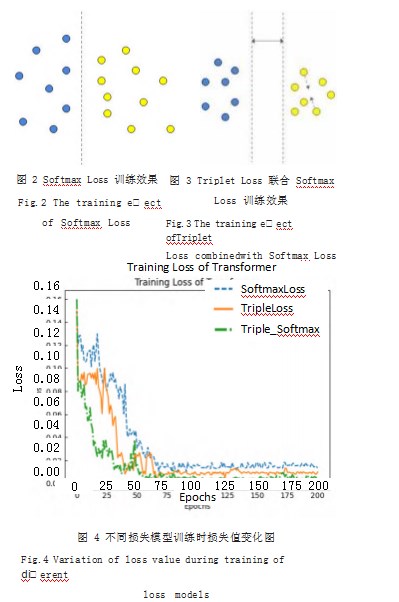

引入三元组损失后的训练优化效果如图2、图3所示。分析图像可知,Triplet Loss联合Softmax Loss的多重损失函数模型能够兼顾类内距离小于类间距离和类内的相似性,从而显著提升了行人步态序列分类识别的准确率。

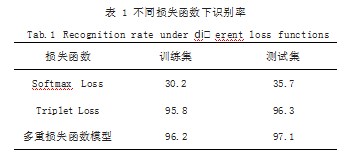

为直观对比不同损失函数模型之间分类效果的差异,我们在公共数据集CASIA-B上进行了课堂早退情境下学生身份识别的验证,考虑了3种损失函数的设置方式,分别是Softmax Loss、Triplet Loss以及Triplet Loss联合Softmax Loss的多重损失函数模型。损失函数值随训练迭代次数的变化如图4所示。

由图4可知,当迭代次数达到某一个值后,损失函数各自收敛且在某一最小值附近小幅度震荡变化,说明此时模型的权重参数不会再发生较大变化,模型训练完成。为防止步态识别模型在训练集上出现过拟合的情况,同时更好地展现损失函数对系统识别准确率的影响,我们针对3种损失函数的设置方式,分别在训练集和测试集进行识别准确率实验,观察模型的拟合情况,实验得到的识别准确率如表1所示。

通过观察最后的结果可知,当设置Triplet Loss联合Softmax Loss的多重损失函数时,算法收敛速度最快且拟合效果最好,在训练集和测试集上的识别准确率分别达到96.2%和97.1%,未出现过拟合现象。因此,在进行步态识别系统的设计时,我们选择Triplet Loss联合Softmax Loss的多重损失函数代替传统的Softmax Loss,以便能够更好的学习步态特征和距离度量。

2.4身份识别

身份识别前首先需要一个包含学生步态特征的数据库,以便进行身份的匹配识别。由于本项目研究对象为本校某学院班级学生的步态特征,目标对象为已知人群,所以其步态特征可提前获取并录入到数据库进行存储,便于后期比对时调用。同时本项目研究范围小且所用数据相对较少,这也有利于实现数据库的建立以及步态识别系统的实现。本系统使用MySQL数据库存储对象的身份信息,具有体积小、速度快、可移植性高、使用成本低等优势。

步态数据库存储特征是聚合多幅步态轮廓图特征得到的单个特征向量,具体来说,首先经卷积神经网络逐层的卷积池化操作可以获得步态轮廓图的帧级特征,同时通过集合池化操作将帧级特征序列化,从而实现特征信息的聚合。考虑到实际情况中的学生步态图像数目差异较大,因此设置集合池化过程可处理任何基数的集合。为减少学生个体之间的微小差别,首先采用水平金字塔池(HPP)中四层结构提取出不同尺度下的全局和局部特征,然后使用多层全局通道(MGP)网络提取不同层的步态特征信息,最后,通过水平金字塔映射(HPM)结构聚合神经网络中的全局和局部特征,得到的特征向量如图5所示。

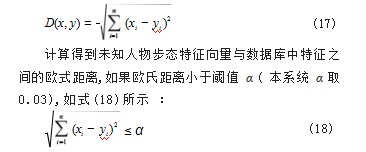

在进行系统身份识别测试时,首先获得模型提取到的视频中待识别行人的步态特征向量,然后与事先构建好的步态数据库中的特征向量一一比对,最终选取相似程度较大的特征向量并提取出对应的标签。相似程度的比较采用简单快捷的度量学习方法—欧氏距离(Euclidean Distance),它表示在n维空间中两个点之间的真实距离。假设n维空间中两个样本分别是x=(x1,x2,……,xn)和y=(y1,y2,……,yn),则n维空间两个样本的欧氏距离计算公式表示为如式(17)所示:

则认为当前数据库中特征与未知人物步态特征匹配,从而提取数据库中该人物标签,检索并识别出学生身份。如果欧氏距离均大于阈值α,则反馈当前未知人物信息无法识别,同时修改数据库,增加该人物步态特征信息。

3步态识别系统的实际应用

3.1不同数据集下模型实验

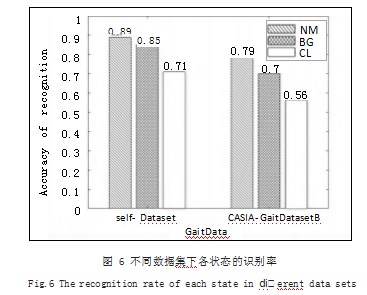

在实际应用中分别基于自设计步态数据集和公共数据集对步态识别系统DGRSML进行评估。自设计数据集共124个人的步态视频数据以及通过U2NET网络获取到的轮廓图,包含NM下6段,BG和CL状态下各2段,拍摄场地位于本校各教学楼走廊,拍摄对象均为在校大学生。该数据集测试集部分包含50名受试者(25名女性和25名男性)。公共数据集则基于中科院-CASIA-GaitDatasetB步态图像轮廓数据库。实验结果如图6所示,当测试数据集为自设计数据集时,3种状态下系统的识别准确率分别达到89.19%、85.04%和70.94%;当测试数据集为公共数据集时,3种状态下系统的识别准确率分别达到79.58%、70.15%和56.63%。由此可见,本文所设计的步态识别系统DGRSML更好的适用课堂早退学生的身份识别情景。

3.2具体实验验证

3.2.1目标检测应用

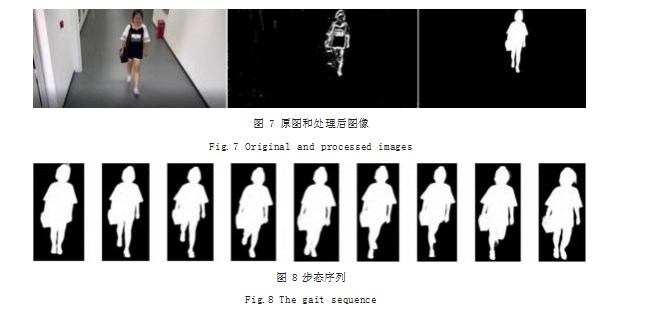

考虑到课堂早退情景中,走廊监控视频捕捉到的多为单人步态视频,因此在进行课堂早退情境下的目标检测中,只涉及前背景分割不涉及语义分割。在此种情境下我们分别对比了两种检测方式,一种是基于固定模型的背景减除法;另一种是基于U2Net网络的显著性目标检测方法,原图像以及两种不同方式处理后的结果分别如图7所示。

通过处理后的结果图可以看出,即使在背景较为复杂且学生背包的走廊情景下,采用U2Net对图像进行显著性检测都可较好地实现了目标轮廓图的提取。同时U2Net网络具有较好的实时性,如图8所示则为使用该方法提取到的学生步态序列,可见序列中的每个图像都较好的保留了学生步态轮廓信息,这为后期的步态识别奠定了坚实的基础。

最后,为更好地展现步态识别系统DGRSML在复杂环境下目标检测和语义分割的高效性,我们做了如下实验,将本文提出的U2Net联合GaitSet实现的步态识别系统与传统的步态识别系统进行对比实验,其中数据集取自中科院-CASIA-GaitDatasetB步态图像轮廓数据库,实验结果如表2所示。

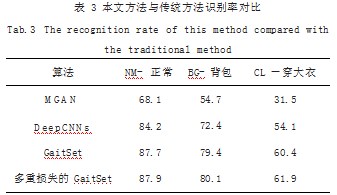

3.2.2损失函数实验验证

在损失函数实验验证阶段选取公共数据集进行实验验证,与传统的步态识别算法相比,本系统采用的多重损失的GaitSet算法的实验结果如表3所示。从表3中可以看出,本文提出的多重损失的步态识别模型在3种行走状态下识别准确率都优于传统算法。与原来的GaitSet模型相比,损失函数改进后,在正常行走状态下平均识别率仅提升0.2%,在背包和穿大衣行走状态下平均识别率提升幅度较大,分别为0.7%和1.5%。总而言之,平均识别率总体提高0.8%,由此可见,本文提出的Triplet Loss联合Softmax Loss的多重损失方法能有效提升步态识别系统的准确率。

3.2.3场景验证

步态识别系统DGRSML将在4种不同场景中进行相应的识别测试,第1种和第2种场景下采用录制好的且身份已知的学生步态视频做测试;在第3种场景下采用录制好的且身份未知的学生步态视频做测试;第4种场景下采用不同于前面背景的学生步态视频。受试者为3名男性,1名女性,皆为在校大学生。

从测试结果可以看出,该步态识别系统在上述4种场景下都能准确检测出行人目标并进行身份识别,因此说明该系统对于多变且复杂的背景具有一定的抗干扰能力。对于身份信息在数据库中记录过的学生,系统可准确识别并显示姓名、性别和班级等身份信息;对于身份信息未在数据库中记录过的学生,系统则无法显示该学生相关信息。另外,因为步态识别模型提前训练好加载到本地服务器中,所以系统对学生的身份识别速度较快。总而言之,本系统可支持复杂场景下行人的检测与身份识别,且具有较好的鲁棒性,实际应用过程中识别准确率较高,具有很强的实用性。

4结论

本文提出并实现了一个复杂场景下多重损失的深度步态识别系统DGRSML,用以检测视频监控中的课堂早退学生的身份。这是首次对高校课堂早退学生目标的自动检测与身份识别问题进行研究,在深入分析了早退学生身份识别的现状以及存在的识别问题的基础上,创新性的选择U2Net网络联合多重损失的GaitSet模型解决此问题,分别用于复杂场景下的目标检测和特征提取。在自设计数据集上识别准确率达97.1%,基本达到课堂早退学生场景中对于步态识别与分析的要求。

虽然本系统已达到较为理想的效果,可以实现复杂场景下目标的检测并且对学生着装等干扰因素具有一定的鲁棒性,但是并未解决多人识别问题,也并未考虑光线等外部因素对系统识别准确率的影响,因此,仍然需要进一步探索研究。总而言之,该深度步态识别系统的实施能为有效解决高校学生的课堂早退违纪问题提供新方法,为智能视频监控技术的具体应用提供新思路。

参考文献

[1]邹国锋,傅桂霞,李海涛,等.多姿态人脸识别综述[J].模式识别与人工智能,2015,28(7):613-625.

[2]朱应钊,李嫚.步态识别现状及发展趋势[J].电信科学,2020,36(8):130-138.

[3]陈银,任侃,顾国华,等.基于改进的单高斯背景模型运动目标检测算法[J].中国激光,2014,41(11):245-253.

[4]康一飞,潘励,孙明伟,等.基于高斯混合模型法的国产高分辨率卫星影像云检测[J].武汉大学学报信息科学版,2017,42(6):782-788.

[5]MAHFOUF Z,MEROUANI H F,BOUCHRIKA I,et al.Investigating the use of Motion-based Features from Optical Flow for Gait Recognition[J].Neurocomputing,2018,(283):140-149.

[6]LISHANI A O,BOUBCHIR L,KHALIFA E,et al.Human gait recognition using GEI-based Local multi-scale Feature Descriptors[J].Multimedia Tools and Applications,2019,78(5):5715-5730.

[7]Chao H Q,He Y W,Zhang J P,et al.Gaitset:Regarding Gait as a Set for Cross-view gait recognition[C]//Proceedings of the AAAI Conference on Artificial Intelligence,2019,33(01):8126-8133.

[8]Qin X B,Zhang Z C,Huang C Y,et al.U2-Net:Going Deeper with Nested U-structure for Salient Object Detection[J].Pattern Recognition,2020(106):107404.

关注SCI论文创作发表,寻求SCI论文修改润色、SCI论文代发表等服务支撑,请锁定SCI论文网! 文章出自SCI论文网转载请注明出处:https://www.lunwensci.com/jisuanjilunwen/62039.html