SCI论文(www.lunwensci.com)

摘 要: 图像风格迁移是人工智能进行艺术创造的一个重要方向。传统风格迁移技术通过逐像素迭代得到风格图片,训练 耗时且迁移效果一般,无法广泛地应用于微端设备上。针对此问题,本文提出了一款轻量的图像风格迁移模型,该模型能够充 分利用 VGG-16 卷积网络强大的图像特征提取功能。通过优化兼顾了图像内容和风格信息的损失函数,该模型能够在短时间内 完成图像的风格学习,并迁移运用到目标图片上,所得到的迁移图片效果优于传统风格迁移技术。

Image Style Transfer Model Based on VGG-16 Neural Network

LI Gongwei

(College of Computer Science and Technology, Zhejiang University of Technology, Hangzhou Zhejiang 310023)

【Abstract】: Image style transfer is an important direction of art creation by artificial intelligence. The traditional style transfer technology gets the style image by pixel iteration, which is time-consuming to train and the transfer effect is not good, so it can't be widely applied to the micro-terminal device. To solve this problem, this paper proposes a lightweight image style transfer model, which could make full use of the powerful image feature extraction function of VGG-16 convolutional network. By optimizing the loss function of image content and style information, the model can complete image style learning in a short time, and transfer to the target image, and the obtained transfer image effect is better than the traditional style transfer technology.

【Key words】: style transfer;VGG-16;loss function;convolutional neural network

1 背景前言

随着当下社会的快速发展和科技日新月异的进步, 人工智能逐步走进人们的生活。在计算机领域,人工智 能的发展为计算机艺术创作提供了成长的土壤,其中, 图像的风格迁移是一颗耀眼的明珠。图像风格迁移是一 种将两幅图像的内容和风格合并的技术。该技术可以用 于创建艺术作品,增强图像的美感,或者用于计算机视 觉领域中的许多应用,例如图像合成和图像生成等。

近年来,图像风格迁移算法已经得到了极大的发 展,并在艺术和计算机视觉领域中得到了广泛应用。例 如,基于图像风格迁移的算法已经被应用于图像生成、 图像增强、视频分割和语音转换等领域。另外,随着深 度学习技术的不断发展,基于神经网络的图像风格迁移 算法已经得到了极大地提高,可以生成更加逼真和细腻的合成图像。

图像风格迁移的算法可以分为基于优化和基于神经 网络的方法。基于优化的方法尝试最小化两个图像之间 的距离,以产生一张新的图像。其中著名的算法包括 L-BFGS 算法 [1] 和基于变分自编码器(VAE)的算法 [2] ; 基于神经网络的方法则使用卷积神经网络(CNN)来 提取图像的内容和风格信息,并生成一张新的图像。其 中最流行的算法是由 Gatys 等人提出的神经风格迁移算 法 [3],其核心思想是利用 CNN 网络的卷积特征提取器 来提取不同图像的内容和风格信息,并将这些信息合并 到一个新的图像中。

虽然风格迁移的理论目前已经十分成熟,但是许多 迁移模型受限于模型架构或数据样本,有的只能满足单 一的风格迁移,有的则需要长时间的训练来完成新风格的转换。本文在近年来提出的神经网络 VGG-16 预训练 模型的基础上,通过适配输入与自定义损失函数,搭建 出一款支持多风格的图像风格迁移模型,该模型可以快 速提取风格图片中的有效信息,完成对指定图像的风格 转换。本文主要涉及两项关键技术,一项是风格迁移 ; 另一项是 VGG-16 卷积网络模型。

1.1 风格迁移

风格迁移指的是两个不同域中图像的转换,风格迁 移中有两类图片 :一类是风格图片,通常是一些艺术家 的作品,往往具有明显的艺术家风格 ;另一类是内容图 片,这些图片往往来自现实世界,如个人摄影等。利用 风格迁移能够将内容图片转换成具有艺术家风格的图 片。风格迁移的效果主要表现在物体的纹理、颜色和轮 廓上,所以在挑选风格图时,其纹理越显著或者与内容 图的轮廓越接近,所得到的迁移效果就越出色。

风格迁移在大多数情况下可以实现类似于滤镜的图 像处理效果,给人们提供强烈的视觉观感,并且可以根 据个人需求完成所需风格的迁移程度。在学术界,风格 迁移最常用到的地方是扩充图片数据集,通过改变指定 图片的颜色深浅或者轮廓纹理来实现。此外,基于对抗 生成网络实现的风格迁移甚至可以实现物体语义上的迁 移,比如橘子变苹果、马变斑马、卡车变汽车 [4] 等。

虽然图像风格迁移技术有很多优点,例如可以生成 具有艺术价值的图像,但是也存在一些缺点。生成的图 像通常需要经过后期处理才能达到更好的效果,因为算 法往往会产生一些伪影和不自然的细节。其次,该技术 的计算成本通常很高,特别是在生成高分辨率图像时。 此外,由于该技术主要基于静态图像,因此它对于视频 和动态场景的处理仍然存在挑战。

1.2 VGG-19 神经网络模型

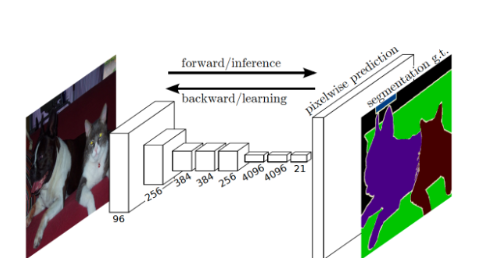

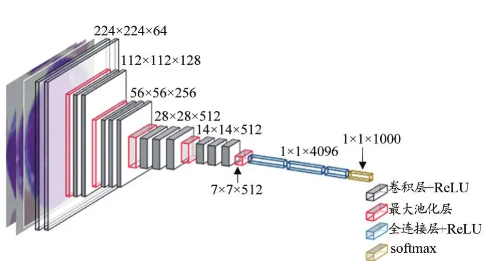

已有研究表明,随着神经网络结构深度的增加,所 取得的性能也会更好 [5]。VGG-16 神经网络模型包含了 13 个卷积层和 3 个全连接层,网络深度深,且结构一 致,如图 1 所示。

以 VGG-16 卷积网络为基础模型有两点理由。首先 是其预训练模型在 ImageNet 数据集 [6] 上经过了大量 的图像训练。模型训练的过程可以视为模型逐步掌握图 像特征提取方法的过程。所以 VGG-16 预训练模型为图 片的风格信息提取和内容提取提供了可靠支撑 ;其次是 使用预训练模型可以节省训练时间。采用常规的神经网 络模型训练方法时,需要一定的训练时间和大量的训练 数据来提升模型的泛化能力。

2 模型编写

2.1 VGG-16 预训练模型修改

由于风格迁移网络的输入是图片,输出也是图片, 对这种网络一般实现为一个全部都是卷积层而没有全连 接层的网络结构 [7]。全卷积网络的一个重要优势在于对 输入的尺寸没有要求,也就是说模型能够接受不同分辨 率的图片。

从 Pytorch 第三方库下载的 VGG-16 预训练模型, 带有 3 层全连接层,全连接层用于输出图像的分类信 息,不能提取图像特征信息,所以需要舍弃。保留下 13 层卷积层以及对应的池化层,用于提取图像的风格 和内容特征。对于保留下的卷积层参数,将其训练属性 设置为不可训练,防止由于多次风格变换导致模型的图 像特征提取能力下降。

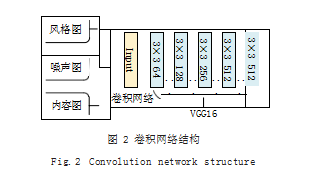

如图 2 所示,设置输入层为可更改,即通过前馈神 经网络来修改输入层信息。最开始除了输入风格图和内容图以外,还需要输入一张噪声图。前两张图是训练结 果的具象化参考,噪声图则是训练的最终目标。初始噪 声图同时具有一定的内容图信息和风格图信息,但看 起来是杂乱无章的,通过不断训练降低设定的损失函数 值,从而优化噪声图的参数信息。在经过一定次数迭代 后,得到的图片就会呈现出理想的效果。当训练结束时, 噪声图所在的输入层参数就是需要生成的图片信息。

2.2 损失函数的搭建

在神经网络模型中,定义高效的损失函数是模型取 得满意结果的关键步骤,一个好的风格迁移模型需要保 证内容图中的内容信息不过分失真,也要确保风格图的 风格信息得到充分的提取。

在 VGG-16 预训练模型的修改中,本文提出了采 用全卷积神经网络,并将最终结果保存在输入层上的想 法。由于图像在每个卷积层计算后都有对应大小的参数 矩阵,可以利用这些参数矩阵来表示输入层的内容特征 以及风格特征 [8]。一般来说浅层网络提取的是局部的细 节纹理特征,深层网络提取的是更抽象的轮廓、大小等 信息。本文选取了 3 个卷积层 [c3_2|c4_2|c5_2] 的计算 结果表示内容特征, 使用 5 个卷积层 [c1_1|c2_1|c3_1. |c4_1|c5_1] 的计算结果表示风格特征。以 c4_2 为例, 它表示的是第 4 轮卷积的第二个卷积层。下面是对内容 损失和风格损失的具体定义。

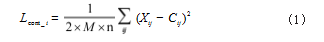

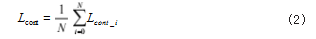

定义内容损失 :内容图在指定层上提取出的特征矩 阵,与噪声图在对应层上的特征矩阵的差值的 L2 范数。 即求两两之间的像素差值的平方,如式(1)所示 :

其中, M 是特征矩阵的尺寸, n 是通道数目, X 是 噪声图的特征矩阵, C 是内容图的特征矩阵。最终的内 容损失 Lcont 为每一层的内容损失加权和再求平均。其中 N 为总层数,如式(2)所示 :

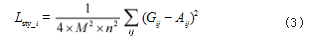

定义风格损失 :使用风格图在指定层上的特征矩阵 的 GRAM 矩阵表示其风格信息。于是,每一层风格损失可以表示为 :噪声图特征矩阵的 GRAM 矩阵 G 和风 格图 GRAM 矩阵 A 的差值的 L2 范数如式(3)所示 :

最终的风格损失 Lstyle 为每一层的风格损失加权和再 求平均,如式(4)所示 :

最终用于训练的损失函数为内容损失和风格损失的加权和。本文选取两个超参数各为 0.5.如式(5)所示 :

3 实验过程

3.1 实验环境

Window11 操作系统,Python 编写脚本语言, 以 Pytorch 为框架编写神经网络模型。实验硬件平台处理 器为 AMD Ryzen 7 5800H, 主频 3.20GHz,16GB 运 行内存。

设置模型迭代 20 轮,每轮结束后保存风格迁移图 片,每一轮训练 20 次,学习率设为 0.03.实验使用风 格图由 ImageNet 提供,内容图源自网络。

3.2 模型运行结果分析

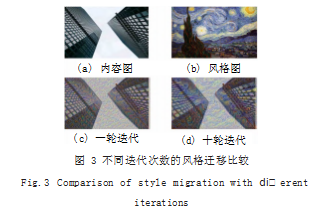

比较不同轮次的风格迁移图, 可以发现, 随着轮次 的增加,损失值不断下降,风格迁移的效果也越明显。 以城市建筑融合梵高星空油画为例子,如图 3 所示,可 以看到迁移图的具体内容仍是原来的城市建筑,但迭代 次数的增加,图像的色彩特征和纹理脉络都更加贴近风 格图。

如图 4 所示展现了比较不同风格的迁移效果, 可以 发现,当采用相同的内容图和不同风格画像时,所得到 的迁移图有很大差异,主要表现在风格迁移后图片的颜 色、轮廓等方面。特别是强纹理风格图,得到的迁移图 纹理效果非常明显。

每一次风格迁移所花费的运行时间与每轮训练次 数呈正相关。经过多次实验测算,本文提出的 VGG-16风格迁移模型在 CPU 上得到每次训练所需要的时间为 0.64s,每轮所需时间为 12±3s。如表 1 所示,与传统 模型进行比较,本文提出的模型可以节省几十分钟甚至 数个小时的时间,并且支持任意风格,实现了快速轻量 的风格迁移。

4 总结

本文提出了一种基于 VGG-16 神经网络的风格迁移 模型,在预训练模型上做出了适配性修改,使其能够满 足图片风格迁移的需求 ;并定义了合理的损失函数,既 保障内容图片不过分失真,也确保能够充分提取风格特 征。通过该模型得到的风格迁移图片具有一定艺术性和 观赏性。此外,也可以根据具体需要调整风格化程度, 能够作为扩充图片数据的辅助工具。在常规算力处理器 上,该模型可以快速完成部署并生成迁移图像,出图速 度约为 12 秒 / 张。未来,将进一步研究提高模型的运 行效率和图像迁移效果,并将模型运用到实际生产当中。

参考文献

[1] MORITZ P,NISHIHARA R,JORDAN M.A Linearly- convergent Stochastic L-BFGS algorithm[C]//Artificial Intelligence and Statistics.PMLR,2016:249-258.

[2] PENG J,LIU D,XU S,et al.Generating diverse structure for image inpainting with hierarchical VQ-VAE[C]// Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition,2021:10775-10784.

[3] GATYS L A,ECKER A S,BETHGE M.Image Style Transfer Using Convolutional Neural Networks[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2016:2414-2423.

[4] LI C,WAND M.Combining Markov Random Fields and Convolutional Neural Networks for Image Synthesis[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2016:2479-2486.

[5] PARK D Y,LEE K H.In Arbitrary Style Transfer with Style-attentional Networks[J].Proceedings of the IEEE, 2019:5880-5888.

[6] RUSSAKOVSKY O,DENG J,SU H,et al.Imagenet Large Scale Visual Recognition Challenge[J].International Journal of Computer Vision,2015(115):211-252.

[7] 刘建锋,钟国韵.基于神经网络的图像风格迁移研究综述[J]. 电子技术应用,2022.48(6):14-18.

[8] JOHNSON J,ALAHI A,FEI-FEI L.In Perceptual Losses for Real-time Style Transfer and Super-resolution[J]. Lecture Notes in Computer Science,2016.9906:694-711. [9] LEI X,ZHAO G,KUO C C J.NITES:A Non-parametric Interpretable Texture Synthesis Method[C]//2020 Asia- Pacific Signal and Information Processing Association Annual Summit and Conference (APSIPA ASC).IEEE, 2020:1698-1706.

关注SCI论文创作发表,寻求SCI论文修改润色、SCI论文代发表等服务支撑,请锁定SCI论文网!

文章出自SCI论文网转载请注明出处:https://www.lunwensci.com/jisuanjilunwen/61107.html