SCI论文(www.lunwensci.com)

摘 要:舰船目标检测任务在海上交通管制和航道安全维护等方面发挥着重要作用。为减小复杂背景的干扰,增强网络在 遮挡环境下的检测准确率,本文在先进的 S2A-Net(Single-shot Alignment Network) 的基础上,采用了 3 种改进方法 :首先 增加骨干网络的深度,使得骨干网络更加充分提取目标特征 ;其次增加可变形卷积模块(Deformable Convolution Module, DCM),使得采样点可以根据目标形状自适应发生改变,更为全面精准地提取目标特征 ;最后,增添 Cutout 模块,使得网络 在训练过程中学会应对遮挡情况,进一步提升目标检测精度。在 HRSC2016 数据集上进行的消融实验表明了本文提出的网络 的有效性。

关键词:遥感图像处理,旋转框舰船目标检测,改进的 S2A-Net,卷积神经网络

Rotating Ship Object Detection Algorithm Based on Convolutional Neural Network

DING Jialiang

(Electronic and Information Engineering College, Tiangong University, Tianjin 300380)

【Abstract】:Ship object detection plays an important role in maritime traffic control and waterway security maintenance. In order to reduce the interference of complex background and enhance the identification accuracy of network in occlusion environment, three improved methods are adopted in this paper based on the advanced S2A-Net (Single-shot Alignment Network). Firstly, the depth of backbone network is increased to enable the backbone network to extract object features more fully. Secondly, the deformable convolution module (DCM) is added to make the sampling points adaptively change according to the shape of the object, so that the object features can be extracted more comprehensively and accurately. Finally, Cutout module is added to make the network learn to deal with occlusion in the training process and further improve the object detection accuracy. The ablation experiments conducted in the HRSC2016 dataset demonstrate the effectiveness of our proposed network.

【Key words】:remote sensing image processing;rotating frame ship object detection;the improved S2A-Net; convolutional neural network

遥感舰船检测是一项非常重要的基础任务 [1],随着 成像技术和人工智能的发展,遥感目标检测逐渐成为研 究热点,遥感目标检测主要发展自通用目标检测,通用 目标检测主要分为单阶段网络和双阶段网络,单阶段 网络直接进行回归和分类,主要有 SSD[2]、YOLOv1[3]、 YOLOv2[4]、YOLOv3[5] 等网络架构,检测速度较快。双 阶段网络增加一个生成候选框阶段,速度略慢,代表有 R-CNN[6]、Fast R-CNN[7]、Faster R-CNN[8]、R-FCN[9] 等网络架构,在两阶段级联网络的作用下相比单阶段网 络可以使检测结果有一个较高的准确度,不过速度较慢,实时检测表现效果较为不佳。

通用目标检测主要采用水平检测框,水平检测框可 以使候选区域表现得更加简洁直观,对于停车场车辆、 建筑物及人物等形状的检测具有较好的适用性。然而, 由于水平框的局限性,尺寸和高宽比不能正确反映出检 测目标的真实形状,还存在目标与背景像素不能有效分 离致使检测结果不准确,对于密集的目标不易区分产生 强烈重叠等问题 [10]。对于信息量复杂、近岸港口干扰 因素多、码头舰船排列紧密、舰船朝向各异的遥感舰船 图像而言,水平检测框不再适用。因此有一些学者开始将目光转向旋转检测框。

旋转框主要有以下几个优点 :首先, 旋转检测可以 精确反应目标的物理尺寸,并且边界框包含极少的背景 像素区域,从而减少背景对物体定位的影响 ;其次,旋 转检测框之间几乎没有重叠,从而可以更清晰更有效地 检测所检测的物体 ;最后,可以从旋转检测框的旋转角 度粗略得到物体的运动方向信息,从而判断物体的运动 轨迹 [11]。综上,在遥感舰船图像目标检测实验中,使 用带有角度信息的旋转检测框可以使实验结果达到一个 较高的水准。因此有些学者提出旋转目标检测网络,近 些年来也逐渐有更多学者在旋转框领域进行开拓,如 Ma 等人 [12] 提出的两阶段文本检测算法 RRPN 网络,基 于 RPN 架构引入旋转检测框,通过对角度的调整进行边 界框回归, 具有较好的有效性 ;中科院电子所团队 [13] 提出的两阶段目标检测算法 SCRDet, 通过添加特征融 合方法和对锚点的精细采样的特征融合网络,提高了对 图像中小目标特征的捕捉能力 ;Yang 等人 [14] 提出的单 目标旋转目标检测算法 R3Det,设计了一种端到端的特 征精细化模块,通过提取更加精确的目标特征来加强网 络的性能 ;Zhou 等人 [15] 创新性地将极坐标引入深度学 习网络中,使用更简单的模型和更少的回归参数,实现 了一个先进的网络性能。

但船舶目标检测还面临如下困难与挑战,例如 :首 先,复杂的港口背景会干扰检测器对船舶的特征提取, 特征提取不充分不精准问题 ;其次,港口图片经常会出 现一些云雾遮挡,这会增加对目标提取的一个难度。因 此本文在先进的 S2A-Net 网络 [16] 基础上,提出了 3 点 改进,具体有以下 3 个贡献 :(1)加深了目标网络的深 度,使得网络可以更充分地提取目标检测特征 ;(2)增 加了可变形卷积模块,使得标准卷积的采样点可以根据 网络自身发生改变,更加充分适应目标形状 ;(3)增加 了 Cutout 数据增强策略,在网络上随机铺设一些 0 像 素的矩形,使得网络在训练过程中学习到在遮挡情况下 的应对措施,提升网络对遮挡目标检测的精度,有效提高了网络模型的鲁棒性,减少了过拟合现象的出现。

1 网络结构

1.1 改进后的算法整体框架

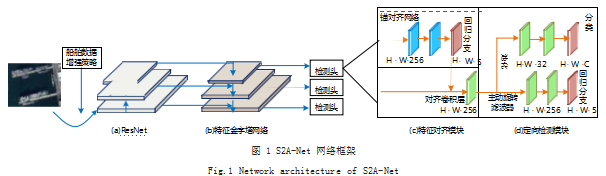

本文提出的遥感舰船目标检测算法是基于 S2A-Net 网络改进而来,整体网络框架结构如图 1 所示。在数据 增强阶段增加了 Cutout 数据增强策略 ;骨干网络选用 ResNet, 并增加了骨干网络的深度, 同时引入了可变 形卷积模块。接下来分别介绍改进后 S2A-Net 的基本 结构 :骨干网络—残差网络 ResNet、可变形卷积模 块以及 Cutout 数据增强策略。

1.2 S2A-Net 网络结构简介

为解决单级检测器存在的水平锚盒与卷积特征之间 存在的严重错位即锚盒在一定程度上很难代表整个物 体从而导致分类评分不能准确反映出定位精度的问题, Han 等人提出了一种新颖的对齐卷积算法 [16],以完全 卷积的方式很大程度上解决了轴对齐卷积特征与任意面 向对象之间的不对齐的情况。通过嵌入对齐卷积, Han 团队设计了 S2A-Net 检测网络,使之能够生成高质量 的锚点和对齐特征,用于舰船图像中的精确目标检测。 本文提出的网络则是在 S2A-Net 的基础上引入可变形 卷积模块,提高网络的性能及效果。

图 1 为改进后的 S2A-Net 框架,由骨干网络、特 征金字塔网络 [17]、特征对齐模块和定向检测模块构成。 特征对齐模块和定向检测模块构成检测头部分。在特征 对齐模块结构中,提出锚对齐网络用以形成高质量的旋 转锚。然后在对齐卷积层中提取锚点与输出特征的对齐 特征。注意,为了简化方便,本文只可视化锚对齐网络 的回归分支而忽略了分类。在定向检测模块中,首先对 方向信息应用主动旋转滤波器 [18] 进行编码,生成方向 敏感特征,并将这些特征集合用以提取方向不变特征, 最后分别对方向敏感特征和方向不变特征进行分类和回 归,进而生成最终的检测结果。

S2A-Net 网络在 HRSC2016 数据集上进行目标检 测任务,实现了先进的速度和准确性。S2A-Net 网络是一个完全卷积的网络,能够很方便地通过网络转发图 像。详细来讲,本文将输入图像传递到骨干网络,随后 提取金字塔特征,然后金字塔特征被送入功能定位模块 用以产生精致的锚和对齐特征,最后面向检测对方向信 息进行编码,得到高置信度的预测结果。

1.3 ResNet 骨干网络

何凯明团队在 2015 年提出 ResNet 网络 [19],该网 络有效避免了网络层数加深后出现的网络退化的情况。 为解决随着网络的加深导致训练精度退化的问题,在输 入输出之间让堆叠的层去拟合残差映射从而创建出一种 直接联系,即建立了一个新的深度残差网络,在形式上 将几个堆叠层匹配的底层映射表示为 H(x),叠加的非线 性层则去拟合另一个映射 :F(x):=H(x)-x,因此原始映 射被重置为 F(x)+x。

该表达式通过跳过堆叠层连接的方式,在一个前馈 网络中实现,如图 2 所示, ResNet 提出了 2 种映射, 即本体映射和残差映射,当网络已经到达最优性能,继 续深化网络则残差映射会变为 0.只余下本体映射,如 此以来,在理论上网络会一直处于最佳状态,性能也 就不会随着深度增加而退化。这样可以避免 H(x) 梯度 消失问题,从而把问题转化为对残差 F(x):=H(x)-x 的估 计。通过实验证明了 ResNet 网络进行加深后, 其性能 比之前的网络得到了进一步的优化提升,基于此本文采 用 152 层的 ResNet 网络作为骨干网络来提升网络的检 测精度。

1.4 可变形卷积模块

遥感舰船图像中的舰船是任意朝向的,而且由于卷 积神经网络构造模块固定的几何结构,对未知的变化适 应性不高,泛化能力不强等问题,本文通过引入两个模 块来提高 S2A-Net 的建模几何变换能力,即可变形卷 积和可变形 Rol 池化 [20]。在可变形卷积中,提出了一 种增加采样位置和额外偏移量的算法,在卷积的常规网 格采样处引入 2D 偏移量, 而这偏移量是可学习的,它 可以使采样网格自由形变,使得感受野可以根据不同的 物体去自适应调整相应形状。如图 3 所示,卷积核在每一个元素上额外增加了一个方向参数,让采样具有不规 则性,提高了模型对目标物体的检测能力。

如图 3(a)所示为标准卷积的规则采样点网络,圆 点表示原始感受野范围,如图 3(b)所示外围的点是变 形卷积中加入偏移量后变形位置,如图 3(c)、图 3(d) 所示则是图 3(b)的特殊情况,表示可变形卷积泛化 到了不同尺寸、不同形状和不定向旋转的各种变换。

2D 层面的可变形卷积由两个步骤组成 :(1) 在常 规网格 R 中对输入特征映射 x 进行采样 ;(2) 计算 w 采 样值的加权和。网格 R 规定了感受野的尺寸和扩张情况,如式(1)所示 :

R = {(−1. −1), (−1. 0), , (0.1), (1.1)} (1)

定义了一个 3×3 的卷积核, 膨胀率设置为 1.对于 输出特征映射y 上的每个位置p0.得到如式(2)所示 :

y(p0 ) =w(pn ) ⋅ x(p0 + pn )

式(2) 中的pn 是在卷积核范围内所有点的枚举。 随后在公式 (2) 的基础上给每个点加入了一个偏移量 {∆pn | n = 1. ..., N} 进行扩张,其中N =| R |,公式 (2) 变为

如式(3)所示 :y(p0 ) =w(pn ) ⋅ x(p0 + pn + ∆pn )

引入之后采样是在位置p0+pn 上,由于加入偏移量 后的位置带有小数部分,和实际的像素点不匹配,因此 引入双线性插值公式如式(4)所示 :

x(p) =G(q, p) ⋅ x(q)

其中 q 是特征映射 x 中空间坐标的枚举,而二维的 双线性插值的核 G 则转化为两个一维的核,如式(5) 所示 :

G(q, p) = g(qx , px ) ⋅g(qy , py ) (5)

在这里,得到如式(6)所示 :

g(a, b) = max(0.1− | a − b |) (6)

所以公式 (3) 的意义是将插值点坐标的像素值设为 离其最近的 4 个坐标点像素双线性插值的加权和,这 4 个点都是在特征图上实际存在的像素点,每个点所占 权重由它与插值点横、纵坐标的位置关系来设置,公式 (6) 的max(0.1− ...) 就是限制了插值点与邻域点之间的距 离不会超过 1 个像素。

1.5 Cutout 数据增强策略

此外为了防止 CNN 学习中的过拟合问题, Terrance DeVries 团队 [21] 提出一种在训练过程中随即屏蔽输入的 平方区域的正则化技术,称之为 Cutout,用来提高 CNN 的鲁棒性和整体性能。Cutout 的实现方式为,在图像中 任意选取一个固定大小的小正方形区域(Cutout 区域的 尺寸要比形状重要,所以该区域满足是正方形即可), 并 把该区域的像素值设置为 0(或其他统一的值),通过在 图像中增加遮挡,为模型在现实世界中遇到遮挡做好准 备。提前预知应对方案,对模型泛化能力的提高和网络 性能指标的增强都起到一个较好的效果。如图 5 所示是 Cutout 的可视化效果,图中的遮挡矩形框是随机产生的。

2 实验

2.1 数据集准备

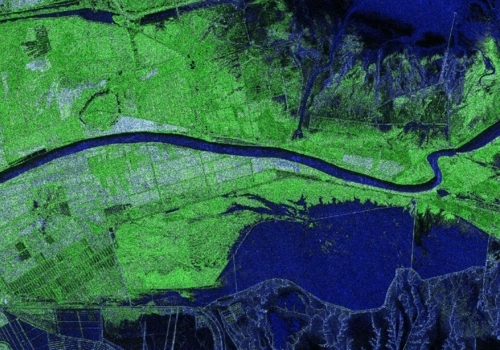

本文采用中国科学院自动化研究团队建立的专门针对舰船目标检测的遥感图像数据集 High Resolution Ship Collection 2016(HRSC2016)[22] 数据集(谷歌地图 公开数据集),共计 1061 张舰船图像。为保证实验的公 平性 [16],所选训练集有 617 张,测试集有 444 张。图像 包含了海面和近岸港口的场景,大小介于 300×300 到 1500×900 之间。

2.2 评估指标

为了评估改进网络模型的性能,本文采用平均精度 均值(mAP) 作为本文的网络模型评估指标, mAP 代 表预测结果里包含目标区域的比例, mAP 值越高代表 目标检测的效果越好。在机器学习中,网络需要鉴别出 其精确率(Precision) 和召回率(Recall), 精确率表 示被正确检测出来的舰船个数占总检测出来物体个数的 比例,而召回率则是被正确检测出来的舰船个数占应该 被检测出的舰船个数的比例,由此可获得 mAP 的计算 公式如式(7)所示 :

mAP = j0(1)Precision(R)dR (7)

2.3 实验准备

本文方法是用 Pytorch 深度学习框架实现提出改进 S2A-Net 模型, 硬件环境为 :12 核 Intel(R) Xeon(R) Platinum 8255C CPU、RTX 2080 Ti, 实验环境为 Pytorch1.5.1、Python3.8、Cuda10.1.学习率设置为 0.001.

2.4 消融实验

2.4.1 基于 ResNet 网络模型加深的测试实验

从测试结果可以看 ResNet_50 的基线网络的 mAP 为 92.73%,已经达到了一个较高的指标,证明了基线 网络的可靠性。可以看出随着网络层次的加深,直至加 深到 ResNet_152.mAP 增加了 1.56%, 证明了随着 网络深度的加深可以更加充分地提取网络特征,从而提 高了网络的准确性,如表 1 所示。

加入可变形卷积模块可看出对舰船图像检测的 mAP 提升了 1.03%,说明对卷积核训练范围的拓展有助于更 充分地提取舰船特征,如表 2 所示。

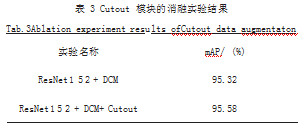

2.4.3 基于 Cutout 模块的测试实验

运用 Cutout 的数据增强方法,通过对图像随机矩 形区域的遮挡,使得卷积层的效果得到了一个小范围的 提升,如表 3 所示。

2.5 可视化效果分析

从如图 6 所示的训练结果可以看出, 该旋转检测框 可以充分地提取目标特征,对近岸背景的抗干扰能力较 好,有效避免了框重叠问题,对比其他先进算法可以达 到一个更高的平均精度,可视化效果更好。

2.6 与现有其他网络的对比实验

我们对改进的 S2A-Net 算法性能进行计算评估,与R3Det[14]、DRN[23]、SBD[24]、RDD[25]、S2A-Net[16] 基 线等多种目标检测算法进行对比,如表 1 所示。需要注 意的是,R3Det 和 RDD 是采用 PASCAL VOC2007 指 标进行评估,而其他算法都是改用 PASCAL VOC2012 指标 进行评估,值得注意的是, VOC2012 指标要好于VOC2007 指标。如表 4 所示,我们提出的网络在 VOC2012 指标 下实现了 95.58% 的 mAP,均优于其他算法。可以看 出本文提出改进后的 S2A-Net 网络结构具有很好的先进 性,对舰船目标检测的灵敏度可以达到一个优秀水准。

3 结语

本文提出了一个基于 S2A-Net 网络改进的舰船目 标检测网络,在 S2A-Net 网络上增加 ResNet 网络的深 度,加入可变形卷积模块,并引入 Cutout 数据增强策 略,消融实验的结果表明提出的网络达到了一个优秀的 检测效果,能起到一个很好的对舰船检测的作用,对其 领域发展有很大的意义。

参考文献

[1] CHEN Z J,CHEN D P,ZHANG Y S,et al.Deep Learning For Autonomous Ship-Oriented Small Ship Detection[J]. Safety Science,2020.130:104812.

[2] LIU W,ANGUELOV D,ERHAN D,et al.Ssd:Single Shot Multibox Detector[C]//European Conference On Computer Vision.Springer,Cham,2016:21-37.

[3] REDMONJ,DIVVALA S,GIRSHICK R,et al.You Only Look Once:Unified,Real-Time Object Detection[C]//Proceedings of The Ieee Conference on Computer Vision And PatternRecognition,2016:779-788.

[4] REDMON J,FARHADI A.YOLO9000:Better,Faster,Stron ger[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2017:7263-7271.

[5] REDMON J,FARHADI A .YOLOv3:An Incremental Improvement[J].2018.

[6] GIRSHICK R,DONAHUE J,DARRELL T,et al .Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2014:580-587.

[7] GIRSHICK R.Fast R-CNN[C]//Proceedings of the IEEE International Conference on Computer Vision,2015: 1440-1448.

[8] REN S P,HE K M,GIRSHICK R,et al .Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks[C]//Annual Conference on Neural Information Processing Systems,2015:91-99.

[9] DAI J F,LI Y,HE K M,et al .Object Detection Via Region Based Fully Convolutional Networks[J].Curran Associates Inc,2016.

[10] LIU L,PAN Z X,LEI B.Learning a Rotation Invariant Detector with Rotatable Bounding Box[J].2017.

[11] SHI P F,ZHAO Z X,FAN X N,et al .Remote Sensing Image Object Detection Based on Angle Classification[J]. IEEE Access,2021(99):1.

[12] MA J Q,SHAO W J,YE H,et al .Arbitrary-Oriented Scene Text Detection Via Rotation Proposals[J].IEEE Transactions on Multimedia,2018.20(11):3111-3122.

[13] YANG X,YANG J R,YAN J C,et al .SCRDet:Towards More Robust Detection for Small,Cluttered and Rotated Objects[C]//International Conference on Computer Vision,2019:8231-8240.

[14] YANG X,LIU Q Q,YAN J C,et al . R3Det:Refined SingleStage Detector With Feature Refinement for Rotating Object[C]//Proceedings of the AAAI Conference on ArtificialIntelligence,2021.35(4):3163-3171.

[15] ZHOU L,WEI H R,LI H,et al .Objects Detection forRemote Sensing Images Based on Polar Coordinates[J]. 2001.

[16] HAN J M,DING J,LI J,et al .Align Deep Features for Oriented Object Detection[J] .IEEE Transactions on Geoscience and Remote Sensing,2021.60:1-11.

[17] LIN T Y,GOYAL P,GIRSHICK R,et al .Focal Loss for Dense Object Detection[C]//Proceedings of the IEEE International Conference on Computer Vision,2017: 2980-2988.

[18] ZHOU Y Z,YE Q X,QIU Q,et al .Oriented Response Networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2017:519-528.

[19] HE K,ZHANG X,REN S,et al . Deep Residual Learning for Image Recognition[C]//Proceedings of the IEEEConference on Computer Vision And Pattern Recognition,2016:770-778.

[20] DAI J F,QI H Z,XIONG Y W,et al . Deformable Convolutional Networks[C]//Proceedings of the IEEE International Conference on Computer Vision,2017:764-773.

[21] DEVRIES T,TAYLOR G W.Improved Regularization of Convolutional Neural Networks with Cutout[J].2017.

[22] LIU Z K,YUAN L,WENG L B,et al.A High Resolution Optical Satellite Image Dataset for Ship Recognition and Some New Baselines[C]//International Conference on Pattern Recognition Applications and Methods,2017:1-8.

[23] PAN X J,REN Y Q,SHENG K K,et al . Dynamic Refinement Network for Oriented and Densely Packed Object Detection[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2020:11204-11213.

[24] LIU Y L,ZHANG S,JIN L W,et al .Omnidirectional Scene Text Detection with Sequential - free Box Discretization[C]//International Joint Conference on Artificial Intelligence,2020:2923-3648.

[25] ZHONG B,AO K .Single-stage Rotation-decoupled Detector for Oriented Object[J].Remote Sensing,2020.12 (19):3262.

关注SCI论文创作发表,寻求SCI论文修改润色、SCI论文代发表等服务支撑,请锁定SCI论文网!

文章出自SCI论文网转载请注明出处:https://www.lunwensci.com/jisuanjilunwen/55749.html