SCI论文(www.lunwensci.com)

摘 要:基于神经网络的图像样式转换算法成为计算机视觉的一个热点。单一神经网络的图像样式转换算法存在损失函数 初值大,收敛速度慢,生成图像质量欠佳等问题。针对上述问题,本文提出了基于多维卷积神经网络的图像样式转换算法。首 先,叠加了不同卷积神经网络。然后,降低了叠加网络深度,引入多维网络的特征提取模型。最后,采用一种预测方法对该网 络的输入结果进行评估,从而实现了图像样式转换。试验结果表明,预测方法有效地预估了算法执行质量,且相比于单一卷积 神经网络,所提风格迁移算法的收敛速度和生成的图像质量更优。

关键词: 图像样式转换,卷积神经网络,VGG16.TensorFlow,Google Net

Image Style Transfer Algorithm Based on Multidimensional Convolutional Neural Network

LIU Qingfu, QIAN Kun

(College of Artificial Intelligence and Computer, Jiangnan University, Wuxi Jiangsu 214122)

【Abstract】: Style transfer algorithm based on neural network has become a hot spot in computer vision. The style transfer algorithm of single neural network has some problems, such as large initial value of loss function, slow convergence speed, poor image quality and so on . To solve the above problems, a style transfer algorithm based on multidimensional convolutional neural network is proposed in this paper. Firstly, different convolutional neural networks are superimposed. Then, the depth of overlay network is reduced, and the feature extraction model of multi-dimensional network is introduced. Finally, a prediction method is used to evaluate the input results of the network, so as to realize style migration. The experimental results show that the prediction method can effectively predict the execution quality of the algorithm, and the convergence speed and image quality of the proposed style transfer algorithm are better than that of a single convolutional neural network.

【Key words】: image style transfer;convolutional neural network;transfer learning;VGG16;TensorFlow;Google Net

0 引言

图像样式转换,也叫风格迁移 [1] 是将一张普通照片 转换为一张具有其他风格艺术效果图像的过程,其被广 泛应用在手机滤镜、艺术着色等领域中。传统的图像样 式转换算法通常不能兼顾语义和风格信息。随着深度学 习的兴起,图像样式转换也取得了突破性进展。但实际 应用中,算法需渲染快速且能获取较为客观的艺术风格 效果。

传统的图像样式转换 [2] 算法主要有非真实感渲染 算法 [3-5] 和纹理合成 [6] 算法两类。前者渲染的方式更加多样化,包括笔触渲染 [3]、图像类比 [4]、图像滤波 [5] 等 算法。笔触渲染根据图像生成笔触,再根据笔触进行重 绘,本质上是模仿人画画的过程。图像类比通过对图像 进行编码、解码以及融合等步骤,将特定的风格作用到 内容图上。图像滤波是在保留图像细节特征的情况下对 图像上的噪声进行抑制的方法。上述算法均只利用了图 像底层特征,因而不能兼顾图像的语义信息和风格信 息。纹理合成 [6] 主要分为过程纹理合成 [7] 和基于样本 的纹理合成 [8] 两类。过程纹理合成通过将纹理生成的过 程抽象成物理公式,模拟纹理的真实生成过程。基于样本的纹理合成通过对现有纹理的重构和再组织,渲染出 一张自然的、与原纹理相似的纹理。上述纹理合成算法 都有参数数量大,参数难以调整的缺点,在图像样式转 换领域表现欠佳。

近年来,随着 Google Net[9] 网络模型和 VGG(Visual Geometry Group)等深度网络模型被广泛应用在计算 机视觉领域,基于深度学习的图像样式转换也获得了飞 速发展。Gatys 等人 [10] 利用了预训练的卷积神经网络 (Convolutional Neural Networks,CNN), 分 离 了 图像高层与底层信息,从而实现了图像样式转换。该方 法仅需要获取风格图和内容图,就能生成质量较高的图 像,且无需模型训练。Li 和 Wand[11] 通过基于马尔可 夫随机场 [12] 的前馈神经网络对 CNN 特征进行区域分 割,生成了真实感较强的图像。Jing Y 和 Liu Y[13] 等人 提出了笔触可控的实时图像样式转换算法,实现了比较 精细的笔触控制。但上述两种算法难以生成具有复杂风 格表示的图像,笔触的细节不能较好的展示 , 模型训练 时间较长。

基于上述分析,本文提出了一种基于多维卷积神经 网络的图像样式转换算法。首先,引入了结果预估策 略,对算法结果进行了有效预估。另外,为降低损失函 数初始值和特征提取的多样性,本文采用多维卷积神经 网络模型替代了单一的神经网络,一定程度上增加了算 法的鲁棒性 , 这也增加了损失函数收敛速度。最后,较 好地生成图像质量进一步验证了算法的有效性,这也为 迁移方法的后续研究提供了一种可行性方案。

1 基于多维卷积网络的图像样式转换方法

1.1 基于单一 VGG 网络的图像样式转换

Gatys 的算法解决了传统方法只关注图像底层特征 的局限性,有效利用了图像的高层特征,生成图像的质 量有明显的提升。Jing Y 和 Liu Y[13] 等人的算法采用笔 触损失(Stroke Loss)代替了 Gayts 等人提出的风格 损失,本质上还是通过 Gram 矩阵求得, 并且通过模型 训练的方式降低了生成图像的时间。但是,上述算法得 到的特征多样性通常较低。另外,算法网络参数较大, 因而损失函数的计算复杂度非常高,导致了生成融合图 或模型训练的时间较长。

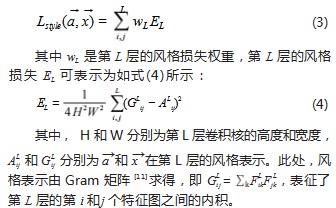

1.2 VGG16 和 Inception-V3 特征提取及网络结构分析

1.2.1 VGG16 和 Inception-V3 网络结构分析

VGG16 网络整体采用卷积层堆叠的结构,由多个 卷积层串联而成。其中全部采用了 3×3 的卷积核和 2×2 最大化池化核。并采用多个小卷积核堆积的方法 替换了 AlexNet[13] 中 7×7 和 11×11 等较大的卷积核, 目的是在感受野相同的情况下,加深网络深度,降低参 数数量,例如使用两个 3×3 的卷积核相对于使用一个 5×5 的卷积核参数数量下降了 28%。但是这也导致了 VGG16 网络深度较大,计算所要求的资源较多。

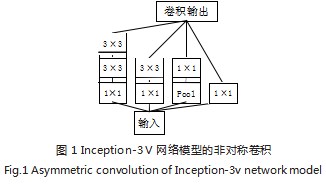

Inception-V3 网 络 整 体 采 用 和 VGG16 相 似 的 卷 积层串联结构,也同样采用了多个小卷积核代替大卷积 核的方式。另外, Inception-V3 还采用了非对称卷积 的方式,并且具有卷积核并联的结构,如图 1 所示。非 对称卷积中采用了大小不同的卷积核并联,从而可以获 得不同的感受野,最后再通过合并的方式将大小不同的卷积输出叠加,实现了单步提取大小不同的特征。相对 VGG16. Inception-V3 提高了对大小不相同的特征的 敏感度。

1.2.2 VGG16 和 Inception-V3 特征提取分析

采用在 ImageNet[13] 数据集预训练的 VGG16 网络 和 Inception-V3[14] 网络,对输入图片进行前向传播, 并根据 TensorFlow 框架提供的特征可视化方法进行可 视化,如图 2 所示。

如图 3 所示,一方面,当卷积层较浅时, VGG16 和 Inception-V3 网络对应的特征主要表现为原图像的 纹理和轮廓等信息,表征了图像风格。而深层卷积输出 表达了抽象特征,可理解为内容信息。

另一方面,无论是在浅层还是在深层, VGG16 和 Inception-V3 提取的特征差异较大。基于对网络结构 的分析, VGG16 网络中每个卷积核的感受野相同,且全 部采用串联的方式组成网络。而 Inception-V3 网络中有 大小不同的卷积核,每个卷积核的感受野不相同,且采 用了部分并联的结构。VGG16 网络和 Inception-V3 网 络的设计思路和结构完全不同,一定程度上决定了这两 个网络对不同特征的敏感度和侧重点是不相同的。对于 相同输入,两个网络对其进行特征提取的结果是具有相异性的。

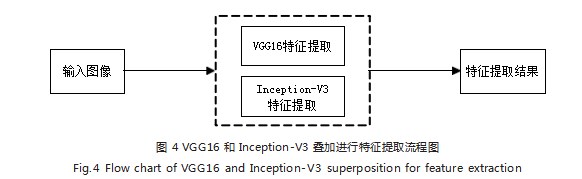

因此,在风格转换的过程中,可以用 VGG16 和 Inception-V3 叠加进行特征提取,从而代替单一的 VGG16 网络。这样利用了两个结构和卷积核感受野 不同的网络,特征提取的过程中,两个网络对特征的 敏感度和侧重点不相同,得到的结果相对于使用单一 VGG16 网络进行特征提取来说, 具有更全面、多样性 更高的特征。

2 基于多维卷积网络的图像样式转换

2.1 多维卷积网络特征提取基于上述分析,本文从提升算法速度和视觉效果两 方面着手,实现了多维卷积网络的图像样式转换。算法 特征提取流程图如图 4 所示。

采用 VGG16 网络的 Block1_conv1、Block2_conv1、 Block3 _conv1 以及 Inception -V3 的 conv2d_1、conv2d_10、conv2d_11、conv2d_15、conv2d_13、 conv2d_16、conv2d_12、conv2d_14、conv2d_17、 conv2d_18 来进行图片的特征提取,作为图像的风格 表示。采用单一卷积神经网络与多维卷积神经网络的参 数数量对比如表 1 所示。

由表 1 可知,相对于采用单一 VGG16 网络的所有 层进行特征提取,采用降低深度后的多维卷积神经网 络使得网络的参数大大降低。

2.2 结果预测

图像样式转换的生成图需兼顾内容图与风格图的内 容和风格信息,这就要求内容图和风格图的内容和风格 不能相差太大。如内容图像是一座楼,风格图像是一个 猫, 将猫的花纹转移到楼的身上大概率不会起到太好的 效果,甚至会造成大量的语义和风格损失,导致算法执 行结果太差。

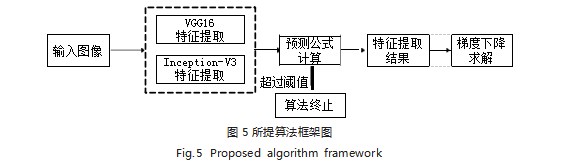

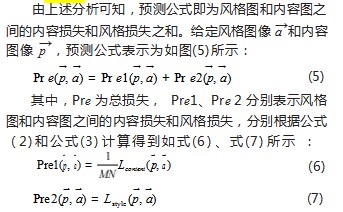

因此,算法执行前可对风格图和内容图做一次内容 损失和风格损失的计算,若预测值超过阈值,说明风格 图和内容图的内容表示和风格表示差距太大,生成图像 无法兼顾风格损失和内容损失,导致较差的视觉效果。由此,选择性的停止算法。相对于上百次梯度下降的工 作,该方法只是在特征提取之后进行了一次损失函数的 计算,时间复杂度微乎其微。另外,该策略是建立在原 算法基础上的,对原算法影响较小。加入预测部分的算 法模型如图 5 所示。

Pre1 中系数 1/MN 是为了将大小不同图片的预测 结果进行归一化。而 Pre2 在公式 (3) 已经进行了归一 化,无需多余系数。

3 实验结果与分析

3.1 实验数据及参数设置

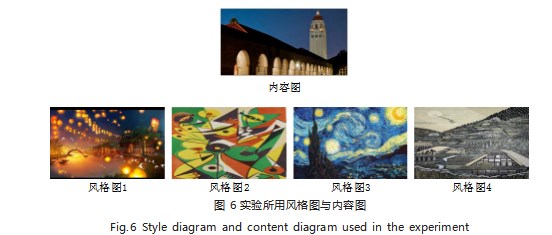

实验采用的内容图(图宾根大学景色)和风格图 (古风画、后印象画、油画和线条画)如图 6 所示。

仿真平台是 Intel-Core2.8GHz、8G 内存和独立显 卡下的 Python3.4 和 TensorFlow2.1.0. 并将所提算法 分别与 Gatys 的算法 [11] ,Jing Y 和 Liu Y[13] 等人提出的 笔触可控风格迁移算法做对比。

所提算法中,内容损失权重 α 取 0.001.风格损失权重 β 取 1.以契合 Gatys 提出的最佳比例 α/β=10-3. 输入图像宽度设置为 200 像素,高度自适应且向下取 整, 并使用 VGG16.preprocess_input 函数进行预处 理。由图 9 可知,所提算法损失函数通常在迭代 20 次 后收敛,但为保证所提算法运行质量,应选取至少迭代 40 次之后的图像作为生成图像。

对比算法中, Gatys 算法参数和所提算法相同,迭 代次数设为 100.Jing Y 和 Liu Y[13] 等人的算法学习率 取 1×10-2. 并使用在 MSCOCO[15] 训练集随机抽取 2000 张图片进行训练后的模型输出作为生成图。风格权重和 内容权重未作改动。

3.2 定性定量分析

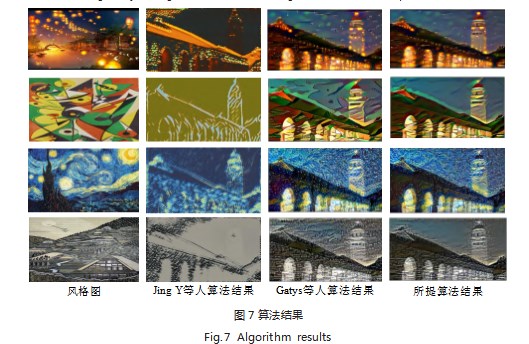

由公式(1)进行获取风格迁移的损失,公式(6) 获取预测结果,具体结果如图 7、图 8 所示。

由图 7 可知, Jing Y 等人的算法对风格图和内容图 的笔触信息能有比较好的迁移效果,但是对于复杂的风格信息表现欠佳。而 Gatys 使用的单维卷积神经网络算 法和所提多维卷积神经网络算法对图片复杂的风格内容 都有较好的表示。由图 8 可知,得益于多维卷积神经网 络特征提取更加全面的特点,所提算法不仅能够将风格 图复杂的风格较好地迁移到内容图,通过对内容图的特 征更加敏感的捕获,能够比单维卷积神经网络算法更好 的保留内容图的语义信息。

为评价算法的生成图质量,引入均方误差(Mean Square Error, MSE)和 PSNR 两种评判准则。MSE 通 过计算当前图像与参考图像之间差的平方期望来估计图 像质量的好坏。该值越小,图像样式转换的效果越好。 MSE 表达公式如式(8)所示:

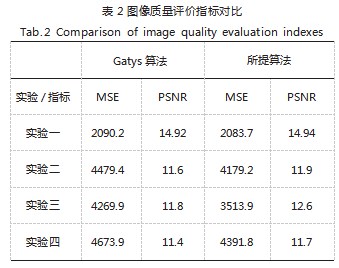

将所提算法和对比算法的迭代次数设置为 300. MSE 和 PSNR 的实验结果如表 2 所示。损失函数迭代 曲线如图 9 所示。

由表 2 可知, 多维卷积神经网络算法生成图比单一 VGG16 网络算法生成图的 MSE 更低, PSNR 表现也更好。由此可知,多维卷积神经网络算法的生成图的质量 更好,与原图更接近,内容损失更少。

由图 9 可知, 多维卷积神经网络的风格转换算法损 失函数初值相对于单一 VGG16 网络大大降低,且随迭 代次数的增加下降地更快,收敛地更早。两种算法单次 的迭代时间相差甚微,因而多维卷积神经网络的风格迁 移算法对应的损失函数收敛更快。

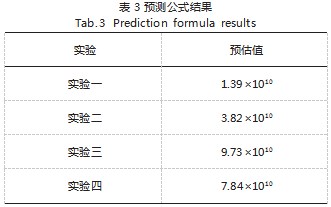

记录预测公式(6)的结果,如表 3 所示。

由图 7 可知,实验一和实验二的生成图较为平滑, 实验三和实验四的生成图产生了肉眼可见的噪声。由表 3 可知,实验一和实验二的生成图,预测函数的值都比 较低, 在 4×1010 以下。反之,实验三和实验四的生成 图对应的预测函数值较高(均超过了 4×1010 )。实验结 果表明,阈值选取为 4×1010 时,能够有效的避免生成 图像有较大语义和风格损失的情况。

综上所述,所提算法在视觉效果和生成图的质量评 价指标上均具有较好的效果。

4 结语

本文提出了一种基于多维卷积网络和结果预测的图 像样式转换算法,可在一定程度上预估算法结果,并用 来决定算法是否提前中止。VGG16 和 Intption-V3 的 叠加取得了比单一网络更优的生成图质量,收敛更快。 实验验证了所提算法在视觉效果和评价指标上,具有更 好的效果,这也为后续进一步研究奠定了坚实的基础。

参考文献

[1] 唐稔为,刘启和,谭浩.神经风格迁移模型综述[J].计算机工程 与应用,2021.57(19):32-43.

[2] 刘哲.基于深度学习的图像风格化方法研究[D].兰州:西北师范大学,2020.

[3] 王涛,高贤强 .一种多笔触各向异性梵高风格油画的渲染方 法[J].计算技术与自动化,2017.36(2):125-128.

[4] 郑程耀 .任意图像快速风格类比方法研究[D].南京:东南大 学,2020.

[5] ZHAO H,YANHUI LI,LIU F,et al.State and Tendency: an Empirical Study of Deep Learning Question&answer Topics on Stack Overflow[J].Science China(Information Sciences),2021.64(11):23.

[6] 易慧敏,朱子奇 .基于自纠正机制的动态纹理合成模型[J].计 算机与现代化,2021(08):40-45.

[7] 朱弋 .基于纹理合成的图像修复研究[D].阜阳:阜阳师范大 学,2021.

[8] 蔡秀霞.基于样本的纹理合成算法及其应用研究[D].西安:西 安电子科技大学,2018.

[9] 李炳臻,刘克,顾佼佼,等 .卷积神经网络研究综述[J].计算机 时代,2021(4):8-12+17.

[10] GATYS L A,ECKER A S,BETHGE M .Image Style Transfer Using Convolutional Neural Networks[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).IEEE, 2016.

[11] LI C,WAND M .Precomputed Real-Time Texture Synthesis with Markovian Generative Adversarial Networks[C]//European Conference on Computer Vision. Springer,Cham,2016:702-716.

[12] LI C,WAND M.Combining Markov Random Fields and Convolutional Neural Networks for Image Synthesis[C]// 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).IEEE,2016:2479-2486.

[13] 赵卫东,施实伟,周婵 .基于ImageNet预训练卷积神经网 络的图像风格迁移[J].成都大学学报(自然科学版),2021.40(4): 367-373.

[14] 曹建芳,闫敏敏,贾一鸣,等 .融合迁移学习的Inception-v3 模型在古壁画朝代识别中的应用[J].计算机应用,2021.41(11): 3219-3227.

[15] LIN T Y,MAIRE M,BELONGIE S,et al.Microsoft COCO: Common Objects in Context[C]//European Conference on Computer Vision.Springer International Publishing,2014: 740-755.

关注SCI论文创作发表,寻求SCI论文修改润色、SCI论文代发表等服务支撑,请锁定SCI论文网!

文章出自SCI论文网转载请注明出处:https://www.lunwensci.com/jisuanjilunwen/52924.html