SCI论文(www.lunwensci.com):

摘要:神经机器翻译发展至今,已经成为目前应用最为广泛的机器翻译方法,其优秀的性能依赖于丰富的语料库和庞大的计算机算力。但通过此方法,在语料库稀缺或者数据算力达到一定规模的情况下,进一步提高翻译质量十分困难。为更好的解决上述问题,实现融入语言学知识的机器翻译是一种重要的方法。本文提出了一种对HNC理论中基本句类语义块表示式进行边界识别,在汉英机器翻译中融入句类知识的方法。首先对属于HNC理论基本句类的句子进行分词和词性标注,根据词性标注的结果进行特征语义块识别和句类分析,然后再由句类表示式对整个句子的语义块表示式进行边界识别。最后设计了一种融入句类知识的汉英神经机器翻译模型,将每个边界划分后的对象单独计算注意力和词向量计算的注意力进行相加,做为输入训练翻译模型。

关键词:HNC;基本句类;机器翻译

Application of HNC Basic Sentence Class Expressions in Chinese-English Machine Translation

XING Mengyang,MA Yanzhou

(Strategic Support Force Information Engineering University Luoyang Campus,Luoyang Henan 471003)

【Abstract】:Up to now,neural machine translation has become the most widely used machine translation method.Its excellent performance depends on rich corpus and huge computer computing power.However,with this method,it is very difficult to further improve the translation quality when the corpus is scarce or the data computing power reaches a certain scale.In order to better solve the above problems,it is an important method to realize machine translation integrating linguistic knowledge.This paper proposes a method to recognize the boundary of the semantic block representation of basic sentence classes in HNC theory and integrate sentence class knowledge into Chinese-English machine translation.Firstly,the sentences belonging to the basic sentence class of HNC theory are segmented and labeled,and the feature semantic block recognition and sentence class analysis are carried out according to the results of part of speech labeling.Then,the boundary of the semantic block representation of the whole sentence is recognized by the sentence class representation.Finally,a Chinese-English neural machine translation model integrating sentence knowledge is designed.The attention calculated by each boundary object separately and the attention calculated by word vector are added as the input training translation model.

【Key words】:HNC;basic sentences;MT

0引言

神经机器翻译是一种将源语言信号通过计算机自动翻译成目标语言信号的过程。最早由Sutskever等人[1]于2014年提出,该论文采用长短期记忆(Long Short-Term Memory)神经网络[2]训练机器翻译模型,并采用门开关的方式解决了神经网络训练时的梯度消失和梯度爆炸问题。目前主流的神经机器翻译有基于循环神经网络[3]、卷积神经网络[4]和Transformer等多种方式。Transformer由Vaswain等人[5]在2017年提出,由于该模型引入的注意力机制(Attention)能够捕捉到待译文本的全局信息进而提升了机器翻译的效果,使得该模型成为了最受欢迎的机器翻译模型。但是Transformer模型在处理文本时存在一些弊端,例如缺乏语言学知识的融入,对待译句子的注意力采取平均分配的原则,因此其翻译质量的提升依然是有限的。针对以上问题,本文提出了一种对HNC基本句类中的语义块表示式进行边界识别的方法,在构建汉英机器翻译模型时融入句类知识提高翻译质量。首先,对符合HNC理论的七大句类的句子进行分词和词性标注,根据词性标注的结果进行句类分析,然后再由句类表示式对整个句子的语义块表示式进行边界识别。最后将每个边界划分后的对象单独计算注意力和词向量计算的注意力进行相加,输入到Transformer模型中进行训练。

1 HNC相关理论介绍

1.1 HNC句类知识

汉语是世界上最复杂的语言之一,因此许多语法关系理论,例如费尔莫尔[6]提出的、经典的用于分析英语的格语法无法完全适应汉语复杂的语言现象,而HNC理论通过以概念联想脉络为主线,建立大脑模拟感知自然语言表述模式的方法更好的去理解和表达了汉语自然语言中的现象。HNC语言理解技术主要从概念、句类、语境单元和语境框架4个层级进行,概念层和句类分析层级是HNC理解技术的基础[7]。

HNC理论建立了能够表述语句语义的表示式,即57组基本表示式,分别是作用、过程、转移、效应、关系、状态和判断七大句类及其所有的子句表示式。事实证明,无限的自然语言现象可以利用有限HNC的句类表示式来表达,同时基本句类又是混合和复合句类构成的基础,因此解决基本句的翻译问题是解决其他句类翻译不可绕过的前提。

1.2语义块

语义块是句子下一级语义的构成单位,是句子语义构成的直接成分,而不是间接成分。语义块可以用来写出句类的表示式,是短语和词概念所无法替代的。从构成上来讲语义块比较灵活,可以是一个词也可以是一个短语,既可以分离成两个不相邻的成分,也可以融合在一起。根据对句子基本语义信息重要程度的不同,语义块可以分为主语义块和辅语义块。主语义块又可以分为对象语义块(B)、作用这语义块(A)、特征语义块(E)和内容语义块(C)4种基元类型,其中B、A、C统称为广义对象语义块。

句子的句类一般可以由E块来进行确定,因此E块在解决基本句类翻译问题上起着至关重要的作用。E块在概念上不仅仅等于一个术语动词,而是一个结构体:由核心部分Ek和上装(QE),下装(HE)组成。

E=上装+Ek+下装

上装、下装是特征语义块的说明部分。上装的语义类有五种:分别是基本判断逻辑修饰、时态修饰、语言逻辑修饰、属性修饰和动词前加成分qv[8]。

下装分为两类,一是动词后的属性修饰成分;二是对E块基本特性的说明。

对于E块和Ek而言,都有分离现象。正是这种分离现象为我们处理汉语句子翻译时提供了很好的语义块表示式边界识别的功能,为机器学习表示式的位置信息提供了便利。

2基本句类表示式边界识别

2.1边界识别流程

HNC理论共有七大句类和57种基本句类。这57种句类中的大部分句类可以通过E块就确定和划分对应的句类。因此我们首先要做的是识别句子中所含的E块,然后是具体句类的划分,最后由句类表示式对整个句子的语义块表示式进行边界识别。例如:

基本作用句:XJ=A+X+B张三|打断了|李四的胳膊

我们首先找到该句中的E块为“打断了”,然后通过语义网络概念节点表[8]确定其属于基本作用句。最后根据E块的边界和基本作用句句类表示式,很容易得出张三就是作用者A,李四的胳膊就是对象B。

其余稍微复杂的句类,例如:

一般转移句:T0J=TA+T0+TB+TC张三|提供给了|李四|一份材料

我们首先对E块进行识别,然后依据E块确定该句的句类为一般转移句,由句类的表示式确定E块后面应有接收者TB和接收内容TC,因此句子中的“李四”为接收者TB,“一份材料”为接收内容TC。因此确定了语义块表示式的边界识别结果。如果一个E块对应两个以上的句类表示式,应先假设其中一种,然后按照表示式尝试对应句子中具体内容,对应失败则排除该句类,尝试下一个,确定最终的句类表示式。

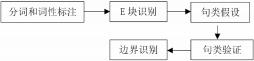

为了能让机器自动识别基本句类的边界,为后续的机器翻译提供可靠信息,具体的识别流程如图1所示:

图 1 HNC 基本句类表示式边界识别流程图

Fig.1 Flow chart of HNC basic sentence class representation boundary recognition

2.2边界识别方法

虽然E块不等于动词,且含义远远比动词要丰富,但是因为基本句类只含有一个E块,因此我们在基本句类的处理中可以依靠分词和动词的词性识别来区分E块,这样更简单快捷,然后再通过HNC理论的语义网络概念节点表进行最终的分析和确认。以上述基本作用句为例,我们采用国内主流的Jieba分词对“张三打断了李四的胳膊”进行分词和词性标注,采用精确模式,得到以下标注结果:

张三nr打断v了ul李四nr的uj胳膊n

其中nr为人名,v为动词,ul为时态助词,uj为结构助词的,n为名词。

经过人工制定的规则确定,该句中的E块是动词“打断”和时态助词“了”,从HNC理论的语义网络概念节点表中可查的“打断了”为一般作用句。由基本作用句的句类表示式可知,张三为作用者A,李四的胳膊为对象B。此时再判断A和B符合一般作用句假设,因此基本句类边界确认为:张三|打断了|李四的胳膊。当一句话中E块上装分离时,例如“政府必须对物价进行调控”:

政府n必须d对p物价n进行v调控vn

这里的“必须”就是“调控”的上装。由上装的语义类可知,该上装属于基本判断逻辑修饰。此时的基本句类边界识别为:

政府|必须|对物价|进行调控|

我们把句子按照以上边界分割成了四块。

3融合边界识别结果的神经机器翻译模型

3.1 Transformer模型

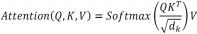

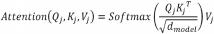

由谷歌提出的基于自注意力的Transformer模型一经问世就在机器翻译领域中取得了重大的成功。该模型采取了一种新的自注意力机制完成对序列信号的特征提取,计算公式如下:

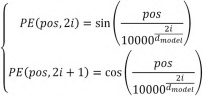

(1)Transformer模型缺乏顺序序列的捕捉能力,无法捕捉句子的结构信息。为了解决这个问题。Transformer模型在编码器和解码器中引入了位置编码,将其直接加到词向量中来捕捉不同单词的位置,公式如下:

其中PE指的是位置编码。pos对应的是词在句子中的位置,i指的是向量中每个值对应的下标。

3.2融合边界识别的注意力机制

本文在Transformer的架构上,提出了融合边识别的注意力机制(Boundary Recognition Self-Attention,BR-SefAtt)。在编码器自注意力机制的子层,我们把完整的句词序列用W=(w1,…,wL)来表示。句类表示式中除E块(因为E块位置比较灵活,且常见分离现象,所以这里我们不对其进行编码)以外的分割部分按从句子开头至结尾的顺序定义为Cj(1≤j≤M,M为整个句子中含有的C个数)。并按照点乘自注意力计算公式计算W和各个C的注意力。其中整句序列W的计算公式如下:

计算结果得到注意力矩阵HM,其中Q,K,V由整句序列W转换得到,dmodel为词向量的维度。

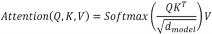

每个C单独计算注意力:

其中,Qj,Kj,Vj由分割成分C转换得到,dmodel为词向量的维度。

将每个C的注意力矩阵集合Hi按照句子序列进行拼接,其中E块部分的注意力统一设置为0。拼接结果{H1,…,0,…,Hi,0,…,HM}为HC,其中零向量的个数和位置与特征语义块的个数和位置一致。此时得到的HM和HC矩阵的大小是一致的。最后把HM和HC矩阵按照公式(5)进行合并,得到最终的注意力矩阵Hfinal:

Hfinal=(1-λ)HM+λHC

其中λ是权衡两个矩阵的超参数。

Hfinal将作为最终的注意力矩阵输入到Transformer模型中进行训练。至此,按照句类表示式对整个句子进行边界识别的句类知识已经作为特征融入到模型中。

4结语

本文针对汉英机器翻译基于数据和算力驱动导致翻译效果受限的问题,探讨了在利用HNC理论基本句类表示式进行边界识别的基础上,将识别后的对象作为注意力机制的一部分输入到神经网络模型中,以此融入句类知识改善翻译质量的方法。但是本研究中还有很多不足,比如本文并没有进一步探讨融入句类知识在复合句、混合句这种复杂语言现象中的实现。同时因为没有标注好的数据集进行实验,本文只在理论上进行了可行性的分析,这是下一步的研究着重要解决的地方。

参考文献

[1]Ilya Sutskever,Oriol Vinyals,Quoc V Le.Sequence to sequence learning with neural networks[C]//Advances in Neural Information Processing Systems,2014:3104-3112.[2]Sepp Hochreiter,Jürgen Schmidhuber.Long short-term memory[J].Neural Computation,1997,9(8):1735-1780.

[3]Jeffrey L Elman.Finding structure in time[J].Cognitive Science,1990,14(2):179-211.

[4]Yann LeCun,Yoshua Bengio.Convolutional networks for images,speech,and time series[J].The Handbook of Brain Theory and Neural Networks,1995,3361(10):1995.

[5]Ashish Vaswani,Noam Shazeer,Niki Parmar,et al.Attention is all you need[C]//Advances in Neural Information Processing Systems,2017:5998-6008.

[6]Walter Anthony Cook.Case Grammar Theory[M].Washington:Georgetown University Press,1989.

[7]张克亮,黄金柱,曹蓉,等.基于HNC语境框架和情感词典的文本情感倾向分析[J].山东大学学报(理学版),2016,51(7):51-58+73.

[8]苗传江.HNC(概念层次网络)理论导论[M].北京:清华大学出版社,2005.

关注SCI论文创作发表,寻求SCI论文修改润色、SCI论文代发表等服务支撑,请锁定SCI论文网!

文章出自SCI论文网转载请注明出处:https://www.lunwensci.com/jisuanjilunwen/37779.html