SCI论文网(www.lunwensci.com):

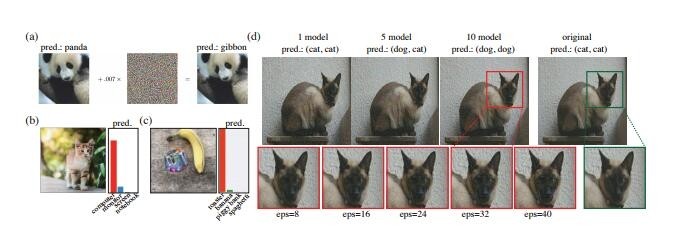

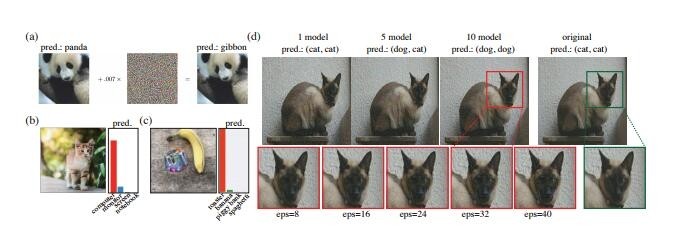

我们都知道,机器学习模型容易受到对抗样本的影响。比如,稍稍修改一点图像,就会导致计算机视觉模型出现错误,像是把校车认成鸵鸟。然而,人类是否容易出现类相似的错误呢?

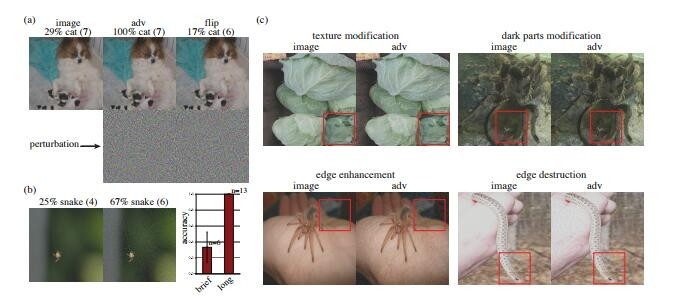

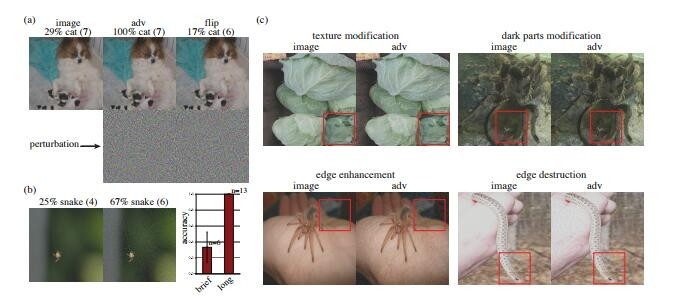

图片加入干扰能让猫看起来像狗

在这里,谷歌大脑的研究人员通过利用最近的技术创造了第一个欺骗人类的对抗样本,这些技术将具有已知参数和体系结构的计算机视觉模型的对抗样本,转换为其他具有未知参数和体系结构的模型,并且通过修改模型更加有效地匹配初始处理的人类视觉系统。

不同扰动方式对图片进行处理

研究发现,在人类观察时间有限的情况下,这些在计算机视觉模型之间进行重度迁移的对抗样本,已经干扰了人类对图像的分类。

论文原址:

https://arxiv.org/abs/1802.08195

关注SCI论文创作发表,寻求

SCI论文修改润色、

SCI论文代发表等服务支撑,请锁定SCI论文网!

文章出自SCI论文网转载请注明出处:https://www.lunwensci.com/scizixun/96.html